Potenziamento GPU 2.0

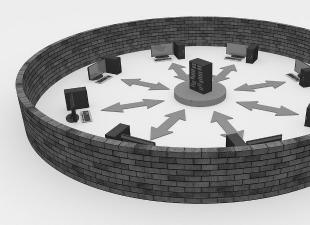

Con la scheda grafica NVIDIA GeForce GTX 680 otteniamo una nuova importante funzionalità: GPU Boost. E la nuova NVIDIA GeForce GTX Titan fa un ulteriore passo avanti espandendo questa funzionalità a GPU Boost 2.0. La prima versione di GPU Boost 1.0 era focalizzata sul massimo consumo energetico raggiunto nei giochi moderni più esigenti. In questo caso la temperatura della GPU non ha giocato un ruolo particolare, a meno che non si sia avvicinata alla soglia critica. La frequenza di clock massima è stata determinata in base alla tensione relativa. Lo svantaggio era abbastanza evidente: GPU Boost 1.0 non riusciva a prevenire situazioni in cui, anche con tensione non critica, la temperatura aumentava eccessivamente.

NVIDIA GeForce GTX Titan - GPU Boost 2.0

NVIDIA GeForce GTX Titan - GPU Boost 2.0

La GeForce GTX Titan valuta già due parametri: voltaggio e temperatura. Cioè, la tensione relativa (Vref) viene determinata in base a questi due parametri. Naturalmente, si farà ancora affidamento sulle singole GPU, poiché esiste variabilità nella produzione dei chip, quindi ogni scheda grafica sarà diversa dall'altra. Ma NVIDIA sottolinea che tecnicamente l'aggiunta della temperatura ha consentito un overclocking Boost in media del 3-7% più alto. La tecnologia GPU Boost 2.0 potrebbe teoricamente essere trasferita su schede video più vecchie, ma è improbabile che ciò accada.

NVIDIA GeForce GTX Titan - GPU Boost 2.0

NVIDIA GeForce GTX Titan - GPU Boost 2.0

Diamo uno sguardo più da vicino a GPU Boost 2.0. Utility come EVGA Precision Tool o MSI Afterburner supportano già GPU Boost 2.0. Abbiamo utilizzato EVGA Precision Tool versione 4.0.

NVIDIA GeForce GTX Titan - GPU Boost 2.0

NVIDIA GeForce GTX Titan - GPU Boost 2.0

GPU Boost 2.0 tiene conto della temperatura, e a basse temperature la tecnologia può aumentare le prestazioni in modo più significativo. La temperatura target (Ttarget) è impostata di default su 80 °C.

NVIDIA GeForce GTX Titan - GPU Boost 2.0

NVIDIA GeForce GTX Titan - GPU Boost 2.0

La tecnologia GPU Boost 2.0 contiene tutte le funzioni a noi familiari dalla prima generazione di tecnologia, ma allo stesso tempo consente inoltre di impostare una tensione più elevata e quindi velocità di clock più elevate. Per gli overclocker è possibile modificare le impostazioni. Puoi abilitare la sovratensione GPU, ma tieni presente la potenziale riduzione della durata della scheda grafica.

NVIDIA GeForce GTX Titan - GPU Boost 2.0

NVIDIA GeForce GTX Titan - GPU Boost 2.0

Gli overclocker possono aumentare Vref e Vmax (OverVoltaging). Questo era ciò che molti utenti volevano sul GK104, ma NVIDIA non si fidava né degli utenti né dei produttori di tale opportunità. E la scheda video EVGA GTX 680 Classified che abbiamo testato (test e revisione) è solo un eccellente esempio. Questa scheda video aveva uno speciale modulo EVGA Evbot che forniva agli utenti il controllo sulle tensioni. Ma NVIDIA ha chiesto urgentemente a EVGA di rimuovere apparecchiature aggiuntive dalle sue schede video. Con GPU Boost 2.0 e OverVoltaging, la stessa NVIDIA ha fatto un passo in questa direzione. Pertanto, i produttori di schede video possono rilasciare diversi modelli GeForce GTX Titan, ad esempio versioni standard e versioni overcloccate di fabbrica. L'abilitazione dell'OverVoltaging avviene tramite uno switch VBIOS (cioè esplicitamente per l'utente in modo che sia consapevole delle possibili conseguenze).

| Parametro | Senso |

|---|---|

| Nome del codice del chip | GP104 |

| Tecnologia di produzione | FinFET da 16 nm |

| Numero di transistor | 7,2 miliardi |

| Area centrale | 314 mm² |

| Architettura | |

| Supporto hardware DirectX | |

| Bus della memoria | |

| 1607 (1733) MHz | |

| Blocchi di calcolo | 20 multiprocessori streaming, di cui 2560 ALU scalari per calcoli in virgola mobile nell'ambito dello standard IEEE 754-2008; |

| Blocchi testurizzati | 160 unità di indirizzamento e filtraggio delle texture con supporto per i componenti FP16 e FP32 nelle texture e supporto per il filtraggio trilineare e anisotropico per tutti i formati di texture |

| Monitorare il supporto |

| Specifiche della scheda grafica di riferimento GeForce GTX 1080 | |

|---|---|

| Parametro | Senso |

| Frequenza centrale | 1607 (1733) MHz |

| 2560 | |

| Numero di blocchi di trama | 160 |

| Numero di blocchi di fusione | 64 |

| Frequenza di memoria effettiva | 10000 (4×2500) MHz |

| Tipo di memoria | GDDR5X |

| Bus della memoria | 256 bit |

| Memoria | 8GB |

| 320GB/s | |

| circa 9 teraflop | |

| 103 gigapixel/s | |

| 257 gigatexel/s | |

| Pneumatico | PCI Express 3.0 |

| Connettori | |

| Consumo di energia | fino a 180 W |

| Cibo aggiuntivo | Un connettore a 8 pin |

| 2 | |

| Prezzo consigliato | $ 599-699 (Stati Uniti), RUB 54.990 (Russia) |

Il nuovo modello della scheda video GeForce GTX 1080 ha ricevuto un nome logico per la prima soluzione della nuova serie GeForce: differisce dal suo diretto predecessore solo per il numero di generazione modificato. Il nuovo prodotto non solo sostituisce le soluzioni di punta dell'attuale linea dell'azienda, ma per qualche tempo è diventato anche il fiore all'occhiello della nuova serie, fino a quando la Titan X non è stata rilasciata con una GPU ancora più potente. Sotto nella gerarchia c'è anche il già annunciato modello GeForce GTX 1070, basato su una versione ridotta del chip GP104, che considereremo di seguito.

I prezzi consigliati per la nuova scheda grafica Nvidia sono rispettivamente $ 599 e $ 699 per le versioni normali e la speciale Founders Edition (vedi sotto), e questo è un buon affare considerando che la GTX 1080 è avanti non solo rispetto alla GTX 980 Ti , ma anche la Titan X. Oggi il nuovo prodotto è senza dubbio la migliore soluzione prestazionale sul mercato delle schede video a chip singolo e allo stesso tempo costa meno delle schede video più produttive della generazione precedente. Finora, la GeForce GTX 1080 non ha sostanzialmente concorrenti di AMD, quindi Nvidia è stata in grado di fissare un prezzo adatto a loro.

La scheda video in questione si basa sul chip GP104, che ha un bus di memoria a 256 bit, ma il nuovo tipo di memoria GDDR5X funziona ad una frequenza effettiva molto elevata di 10 GHz, che offre una larghezza di banda di picco elevata di 320 GB / s. - che è quasi alla pari con la GTX 980 Ti con bus a 384 bit. Il volume di memoria installato su una scheda video con tale bus potrebbe essere pari a 4 o 8 GB, ma installare un volume più piccolo per una soluzione così potente in condizioni moderne sarebbe stupido, quindi la GTX 1080 ha logicamente ricevuto 8 GB di memoria e questo volume è sufficiente per eseguire qualsiasi applicazione di giochi 3D con qualsiasi impostazione di qualità per diversi anni a venire.

Il PCB GeForce GTX 1080 è, per ovvi motivi, abbastanza diverso dai precedenti PCB dell'azienda. Il consumo energetico tipico del nuovo prodotto è di 180 W: è leggermente superiore a quello della GTX 980, ma notevolmente inferiore a quello delle meno produttive Titan X e GTX 980 Ti. La scheda di riferimento ha il consueto set di connettori per il collegamento di dispositivi di output delle immagini: un Dual-Link DVI, un HDMI e tre DisplayPort.

Progetto di riferimento della Founders Edition

Anche quando all'inizio di maggio è stata annunciata la GeForce GTX 1080, è stata annunciata un'edizione speciale della scheda video chiamata Founders Edition, che aveva un prezzo più alto rispetto alle normali schede video dei partner dell'azienda. Essenzialmente, questa edizione è un progetto di riferimento della scheda e del sistema di raffreddamento, ed è prodotta dalla stessa Nvidia. Puoi avere atteggiamenti diversi nei confronti di tali opzioni di scheda video, ma il progetto di riferimento sviluppato dagli ingegneri dell'azienda e realizzato con componenti di alta qualità ha i suoi fan.

Ma se pagheranno diverse migliaia di rubli in più per una scheda video della stessa Nvidia è una domanda a cui si può rispondere solo con la pratica. In ogni caso, all'inizio saranno le schede video di riferimento di Nvidia ad essere messe in vendita a un prezzo maggiorato, e non c'è molto da scegliere - questo accade ad ogni annuncio, ma la GeForce GTX 1080 di riferimento è diversa in questo si prevede che sarà venduto in questa forma per tutto il suo ciclo di vita, fino al rilascio della prossima generazione di soluzioni.

Nvidia ritiene che questa pubblicazione abbia i suoi meriti anche rispetto ai migliori lavori dei suoi partner. Ad esempio, il design a doppio slot del dispositivo di raffreddamento semplifica la costruzione sulla base di questa potente scheda video sia di PC da gioco con un fattore di forma relativamente piccolo che di sistemi video multi-chip (anche nonostante la modalità a tre e quattro chip di funzionamento non consigliato dall’azienda). La GeForce GTX 1080 Founders Edition presenta alcuni vantaggi sotto forma di un efficiente dispositivo di raffreddamento che utilizza una camera di vapore e una ventola che spinge l'aria riscaldata fuori dal case: questa è la prima soluzione di questo tipo di Nvidia, che consuma meno di 250 W di potenza.

Rispetto ai precedenti progetti di prodotto di riferimento dell'azienda, il circuito di alimentazione è stato aggiornato da quattro fasi a cinque fasi. Nvidia parla anche di componenti migliorati su cui si basa il nuovo prodotto; anche il rumore elettrico è stato ridotto, consentendo una migliore stabilità della tensione e potenziale di overclocking. Come risultato di tutti i miglioramenti, l'efficienza energetica della scheda di riferimento è aumentata del 6% rispetto alla GeForce GTX 980.

E per differenziarsi nell'aspetto dai modelli "normali" della GeForce GTX 1080, per la Founders Edition è stato sviluppato un insolito design del case "tagliato". Ciò, tuttavia, probabilmente ha portato anche a una forma più complicata della camera di evaporazione e del radiatore (vedi foto), che potrebbe essere stato uno dei motivi per pagare 100 dollari in più per un'edizione così speciale. Ripetiamo che all'inizio dei saldi gli acquirenti non avranno molta scelta, ma in futuro potranno scegliere o una soluzione con il proprio design di uno dei partner dell'azienda, oppure una realizzata dalla stessa Nvidia.

Nuova generazione di architettura grafica Pascal

La scheda video GeForce GTX 1080 è stata la prima soluzione dell'azienda basata sul chip GP104, che appartiene alla nuova generazione dell'architettura grafica Pascal di Nvidia. Sebbene la nuova architettura si basi su soluzioni sviluppate presso Maxwell, presenta anche importanti differenze funzionali, di cui parleremo più avanti. Il cambiamento principale da un punto di vista globale è stato il nuovo processo tecnologico mediante il quale è stato realizzato il nuovo processore grafico.

L'utilizzo del processo FinFET a 16 nm nella produzione dei processori grafici GP104 negli stabilimenti dell'azienda taiwanese TSMC ha permesso di aumentare significativamente la complessità del chip pur mantenendo un'area e un costo relativamente bassi. Confronta il numero di transistor e l'area dei chip GP104 e GM204: hanno un'area simile (il cristallo del nuovo prodotto è anche leggermente più piccolo fisicamente), ma il chip con architettura Pascal ha un numero notevolmente maggiore di transistor e , di conseguenza, unità di esecuzione, comprese quelle che forniscono nuove funzionalità.

Da un punto di vista architettonico, il primo gaming Pascal è molto simile a soluzioni simili dell'architettura Maxwell, anche se ci sono alcune differenze. Come Maxwell, i processori Pascal avranno diverse configurazioni di Graphics Processing Cluster (GPC), Streaming Multiprocessor (SM) e controller di memoria. Il multiprocessore SM è un multiprocessore altamente parallelo che pianifica ed esegue warp (gruppi di 32 thread di istruzioni) sui core CUDA e altre unità di esecuzione nel multiprocessore. Puoi trovare informazioni dettagliate sulla progettazione di tutti questi blocchi nelle nostre recensioni delle precedenti soluzioni Nvidia.

Ciascuno dei multiprocessori SM è abbinato a un motore PolyMorph, che gestisce il campionamento delle texture, la tassellatura, la trasformazione, l'impostazione degli attributi dei vertici e la correzione della prospettiva. A differenza delle precedenti soluzioni dell'azienda, il PolyMorph Engine nel chip GP104 contiene anche una nuova unità di multiproiezione, Simultaneous Multi-Projection, di cui parleremo di seguito. La combinazione di un multiprocessore SM con un Polymorph Engine è tradizionalmente chiamata TPC - Texture Processor Cluster per Nvidia.

In totale, il chip GP104 della GeForce GTX 1080 contiene quattro cluster GPC e 20 multiprocessori SM, oltre a otto controller di memoria combinati con 64 unità ROP. Ogni cluster GPC ha un motore di rasterizzazione dedicato e include cinque multiprocessori SM. Ogni multiprocessore, a sua volta, è composto da 128 core CUDA, un file di registro da 256 KB, memoria condivisa da 96 KB, cache L1 da 48 KB e otto unità texture TMU. Cioè, in totale il GP104 contiene 2560 CUDA core e 160 unità TMU.

Inoltre, il processore grafico su cui si basa la GeForce GTX 1080 contiene otto controller di memoria a 32 bit (a differenza dei 64 bit utilizzati in precedenza), il che ci fornisce un bus di memoria finale a 256 bit. Ciascun controller di memoria dispone di otto blocchi ROP e 256 KB di cache L2. Cioè, in totale, il chip GP104 contiene 64 blocchi ROP e 2048 KB di cache di secondo livello.

Grazie alle ottimizzazioni dell'architettura e ad una nuova tecnologia di processo, il primo Pascal da gioco è diventato la GPU più efficiente dal punto di vista energetico di tutti i tempi. Inoltre, a questo contribuiscono sia uno dei più avanzati processi tecnologici FinFET a 16 nm, sia le ottimizzazioni dell'architettura effettuate in Pascal, rispetto a Maxwell. Nvidia è riuscita ad aumentare la frequenza clock anche più di quanto si aspettassero passando ad una nuova tecnologia di processo. Il GP104 funziona a una frequenza più alta di quella che funzionerebbe un ipotetico GM204 prodotto utilizzando il processo a 16 nm. Per fare questo, gli ingegneri di Nvidia hanno dovuto controllare attentamente e ottimizzare tutti i colli di bottiglia delle soluzioni precedenti che impedivano un'accelerazione oltre una certa soglia. Di conseguenza, il nuovo modello GeForce GTX 1080 funziona a una frequenza superiore di oltre il 40% rispetto alla GeForce GTX 980. Ma questi non sono tutti i cambiamenti associati alla frequenza operativa della GPU.

Tecnologia GPU Boost 3.0

Come ben sappiamo dalle precedenti schede video Nvidia, nei loro processori grafici utilizzano la tecnologia hardware GPU Boost, progettata per aumentare la velocità di clock operativa della GPU nelle modalità in cui non ha ancora raggiunto i limiti di consumo energetico e dissipazione del calore. Nel corso degli anni, questo algoritmo ha subito molti cambiamenti e il chip video con architettura Pascal utilizza già la terza generazione di questa tecnologia: GPU Boost 3.0, la cui innovazione principale è un'impostazione più precisa delle frequenze turbo, a seconda della tensione.

Se ricordi il principio di funzionamento delle versioni precedenti della tecnologia, la differenza tra la frequenza di base (il valore di frequenza minimo garantito al di sotto del quale la GPU non scende, almeno nei giochi) e la frequenza turbo è stata fissata. Cioè, la frequenza turbo era sempre un certo numero di megahertz superiore a quella base. In GPU Boost 3.0 è diventato possibile impostare separatamente gli offset della frequenza turbo per ciascuna tensione. Il modo più semplice per capirlo è tramite l'illustrazione:

A sinistra c'è la seconda versione di GPU Boost, a destra la terza versione, apparsa in Pascal. La differenza fissa tra la frequenza di base e quella turbo non consentiva di rivelare tutte le capacità della GPU; in alcuni casi, le GPU delle generazioni precedenti potevano funzionare più velocemente alla tensione impostata, ma un eccesso fisso della frequenza turbo non lo consentiva da fare. In GPU Boost 3.0 è apparsa questa funzionalità e la frequenza turbo può essere impostata per ciascuno dei singoli valori di tensione, spremendo completamente tutto il succo dalla GPU.

Sono necessarie utili utilità per controllare l'overclocking e impostare la curva di frequenza turbo. La stessa Nvidia non lo fa, ma aiuta i suoi partner a creare utility simili per facilitare l'overclocking (entro limiti ragionevoli, ovviamente). Ad esempio, la nuova funzionalità di GPU Boost 3.0 è già stata rivelata in EVGA Precision XOC, che include uno scanner di overclock dedicato che trova e imposta automaticamente la differenza non lineare tra la frequenza di base e la frequenza turbo per diverse tensioni eseguendo un programma integrato test di prestazione e stabilità. Di conseguenza, l'utente ottiene una curva di frequenza turbo che corrisponde perfettamente alle capacità di un particolare chip. Che, peraltro, può essere modificato in qualsiasi modo manualmente.

Come puoi vedere nello screenshot dell'utility, oltre alle informazioni sulla GPU e sul sistema, ci sono anche le impostazioni per l'overclocking: Power Target (definisce il consumo energetico tipico durante l'overclocking, come percentuale dello standard), GPU Temp Target (temperatura interna massima consentita), Offset orologio GPU (superamento della frequenza base per tutti i valori di tensione), Offset memoria (superamento della frequenza della memoria video al di sopra del valore predefinito), Sovratensione (capacità aggiuntiva di aumentare la tensione).

L'utilità Precision XOC include tre modalità di overclocking: Base, Lineare e Manuale. Nella modalità principale è possibile impostare un singolo valore per la frequenza in eccesso (frequenza turbo fissa) sopra quella di base, come avveniva per le GPU precedenti. La modalità lineare consente di impostare una variazione di frequenza lineare dai valori di tensione minimo a massimo per la GPU. Bene, in modalità manuale puoi impostare valori di frequenza GPU univoci per ciascun punto di tensione sul grafico.

L'utilità include anche uno scanner speciale per l'overclocking automatico. Puoi impostare i tuoi livelli di frequenza o lasciare che Precision XOC esegua la scansione della GPU a tutte le tensioni e trovi le frequenze più stabili per ciascun punto sulla curva di tensione e frequenza in modo completamente automatico. Durante il processo di scansione, Precision XOC aumenta gradualmente la frequenza della GPU e ne verifica la stabilità o gli artefatti, costruendo una curva di frequenza e tensione ideale che sarà unica per ogni chip specifico.

Questo scanner può essere personalizzato in base alle proprie esigenze impostando il periodo di tempo per testare ciascun valore di tensione, la frequenza minima e massima da testare e il relativo passo. È chiaro che per ottenere risultati stabili sarebbe meglio fissare un piccolo passo e una durata di prova dignitosa. Durante il processo di test, è possibile osservare un funzionamento instabile del driver video e del sistema, ma se lo scanner non si blocca, ripristinerà il funzionamento e continuerà a trovare le frequenze ottimali.

Nuovo tipo di memoria video GDDR5X e compressione migliorata

Quindi, la potenza della GPU è aumentata in modo significativo, ma il bus di memoria rimane solo a 256 bit: la larghezza di banda della memoria limiterà le prestazioni complessive e cosa si può fare al riguardo? Sembra che la promettente memoria HBM di seconda generazione sia ancora troppo costosa da produrre, quindi abbiamo dovuto cercare altre opzioni. Sin dall'introduzione della memoria GDDR5 nel 2009, gli ingegneri di Nvidia hanno esplorato le possibilità di utilizzare nuovi tipi di memoria. Di conseguenza, gli sviluppi hanno portato all'introduzione di un nuovo standard di memoria, GDDR5X, lo standard più complesso e avanzato fino ad oggi, che fornisce una velocità di trasferimento di 10 Gbps.

Nvidia fornisce un esempio interessante di quanto sia veloce. Tra i bit trasmessi passano solo 100 picosecondi: durante questo tempo un raggio di luce percorrerà una distanza di solo un pollice (circa 2,5 cm). E quando si utilizza la memoria GDDR5X, i circuiti di trasmissione e ricezione dei dati devono selezionare il valore del bit trasmesso in meno della metà di questo tempo, prima che venga inviato quello successivo: questo è solo per capire a cosa è arrivata la tecnologia moderna.

Per raggiungere tale velocità è stato necessario sviluppare una nuova architettura per il sistema di input/output dei dati, che ha richiesto diversi anni di sviluppo congiunto con i produttori di chip di memoria. Oltre alla maggiore velocità di trasferimento dei dati, è aumentata anche l'efficienza energetica: i chip di memoria GDDR5X utilizzano una tensione inferiore di 1,35 V e sono prodotti utilizzando nuove tecnologie, che forniscono lo stesso consumo di energia a una frequenza più alta del 43%.

Gli ingegneri dell'azienda hanno dovuto rielaborare le linee dati tra il core della GPU e i chip di memoria, prestando maggiore attenzione a prevenire la perdita e il degrado del segnale lungo l'intero percorso dalla memoria alla GPU e ritorno. Pertanto, l'illustrazione sopra mostra il segnale catturato sotto forma di un grande "occhio" simmetrico, che indica una buona ottimizzazione dell'intero circuito e la relativa facilità di acquisizione dei dati dal segnale. Inoltre, i cambiamenti sopra descritti non solo hanno portato alla possibilità di utilizzare GDDR5X a 10 GHz, ma dovrebbero anche aiutare a ottenere un'elevata larghezza di banda di memoria sui futuri prodotti che utilizzano la memoria GDDR5 più convenzionale.

Bene, abbiamo ottenuto un aumento di oltre il 40% nella larghezza di banda utilizzando la nuova memoria. Ma questo non basta? Per aumentare ulteriormente l'efficienza della larghezza di banda della memoria, Nvidia ha continuato a migliorare la compressione avanzata dei dati introdotta nelle architetture precedenti. Il sottosistema di memoria della GeForce GTX 1080 utilizza diverse nuove tecniche di compressione dei dati senza perdita di dati migliorate progettate per ridurre i requisiti di larghezza di banda: questa è la quarta generazione di compressione su chip.

Gli algoritmi di compressione dei dati in memoria apportano diversi aspetti positivi. La compressione riduce la quantità di dati scritti in memoria, lo stesso vale per i dati inviati dalla memoria video alla cache di secondo livello, il che migliora l'efficienza dell'utilizzo della cache L2, poiché una tessera compressa (un blocco di diversi pixel del framebuffer) è più piccola di uno non compresso. Riduce inoltre la quantità di dati inviati tra diversi punti, come TMU e framebuffer.

La pipeline di compressione dei dati nella GPU utilizza diversi algoritmi, che vengono determinati in base alla "comprimibilità" dei dati: per loro viene selezionato il miglior algoritmo disponibile. Uno dei più importanti è l'algoritmo di compressione del colore delta. Questa tecnica di compressione codifica i dati come differenza tra valori successivi anziché come dati stessi. La GPU calcola la differenza nei valori di colore tra i pixel in un blocco (tile) e memorizza il blocco come colore medio per l'intero blocco più i dati sulla differenza di valori per ciascun pixel. Per i dati grafici, questo metodo è generalmente adatto, poiché il colore all'interno di piccoli riquadri per tutti i pixel spesso non differisce troppo.

Il processore grafico GP104 della GeForce GTX 1080 supporta più algoritmi di compressione rispetto ai precedenti chip con architettura Maxwell. Pertanto, l'algoritmo di compressione 2:1 è diventato più efficiente e, oltre a questo, sono comparsi due nuovi algoritmi: una modalità di compressione 4:1, adatta ai casi in cui la differenza nel valore di colore dei pixel del blocco è molto piccola, e una modalità 8:1, che combina una compressione algoritmo costante 4:1 di blocchi di 2x2 pixel con una compressione delta 2x tra i blocchi. Quando la compressione è completamente impossibile, non viene utilizzata.

Tuttavia, in realtà quest’ultimo accade molto raramente. Questo può essere visto negli esempi di screenshot del gioco Project CARS forniti da Nvidia per illustrare l'aumento del rapporto di compressione in Pascal. Nelle illustrazioni, i riquadri frame buffer che possono essere compressi dalla GPU sono dipinti in viola, mentre quelli che non possono essere compressi senza perdite rimangono con il colore originale (in alto - Maxwell, in basso - Pascal).

Come puoi vedere, i nuovi algoritmi di compressione in GP104 funzionano davvero molto meglio che in Maxwell. Sebbene la vecchia architettura fosse in grado di comprimere la maggior parte delle tessere nella scena, grandi quantità di erba e alberi attorno ai bordi, così come parti di veicoli, non sono soggette agli algoritmi di compressione legacy. Ma quando abbiamo messo in pratica nuove tecniche in Pascal, pochissime aree dell'immagine sono rimaste non compresse: il miglioramento dell'efficienza è evidente.

Come risultato dei miglioramenti nella compressione dei dati, la GeForce GTX 1080 è in grado di ridurre significativamente la quantità di dati inviati per frame. In termini numerici, la compressione migliorata consente di risparmiare un ulteriore 20% della larghezza di banda effettiva della memoria. Oltre all'aumento di oltre il 40% della larghezza di banda della memoria della GeForce GTX 1080 rispetto alla GTX 980 dovuto all'uso della memoria GDDR5X, tutto insieme dà un aumento di circa il 70% della larghezza di banda effettiva rispetto al modello della generazione precedente.

Supporto per il calcolo asincrono Async Compute

La maggior parte dei giochi moderni utilizza calcoli complessi oltre alla grafica. Ad esempio, i calcoli durante il calcolo del comportamento dei corpi fisici possono essere eseguiti non prima o dopo i calcoli grafici, ma contemporaneamente ad essi, poiché non sono correlati tra loro e non dipendono l'uno dall'altro all'interno di un fotogramma. Un altro esempio è la post-elaborazione di fotogrammi già renderizzati e l'elaborazione di dati audio, che può essere eseguita anche parallelamente al rendering.

Un altro esempio importante dell'uso della funzionalità è la tecnica del time warp asincrono (Asynchronous Time Warp), utilizzata nei sistemi di realtà virtuale per modificare il fotogramma di output in base al movimento della testa del giocatore immediatamente prima del suo output, interrompendo il rendering di quello successivo. Tale caricamento asincrono della potenza della GPU consente di aumentare l'efficienza dell'utilizzo delle sue unità di esecuzione.

Tali carichi di lavoro creano due nuovi scenari per l'utilizzo delle GPU. Il primo di questi comporta la sovrapposizione dei carichi, poiché molti tipi di attività non utilizzano appieno le capacità delle GPU e alcune risorse sono inattive. In questi casi, puoi semplicemente eseguire due attività diverse sulla stessa GPU, separando le sue unità di esecuzione per un uso più efficiente, ad esempio gli effetti PhysX eseguiti insieme al rendering dei fotogrammi 3D.

Per migliorare questo scenario, l'architettura Pascal ha introdotto il bilanciamento dinamico del carico. Nella precedente architettura Maxwell, i carichi di lavoro sovrapposti venivano implementati distribuendo staticamente le risorse GPU tra grafica ed elaborazione. Questo approccio è efficace a condizione che l'equilibrio tra i due carichi di lavoro corrisponda approssimativamente alla divisione delle risorse e che le attività vengano completate nello stesso lasso di tempo. Se i calcoli non grafici richiedono più tempo di quelli grafici ed entrambi attendono il completamento del lavoro complessivo, parte della GPU rimarrà inattiva per il tempo rimanente, il che causerà una diminuzione delle prestazioni complessive e ridurrà a zero tutti i vantaggi. Il bilanciamento del carico dinamico dell'hardware consente di utilizzare le risorse GPU liberate non appena diventano disponibili: forniremo un'illustrazione per comprendere.

Esistono anche attività critiche per il tempo di esecuzione e questo è il secondo scenario del calcolo asincrono. Ad esempio, l'algoritmo di distorsione temporale asincrona in VR deve essere completato prima della scansione altrimenti il fotogramma verrà scartato. In questo caso, la GPU deve supportare un'interruzione molto rapida delle attività e il passaggio a un'altra per rimuovere un'attività meno critica dall'esecuzione sulla GPU, liberando le sue risorse per attività critiche: questo si chiama prelazione.

Un singolo comando di rendering da un motore di gioco può contenere centinaia di chiamate di disegno, ciascuna chiamata di disegno a sua volta contenente centinaia di triangoli da elaborare, ciascuno contenente centinaia di pixel che devono essere calcolati e disegnati. L'approccio tradizionale della GPU interrompe solo le attività ad alto livello e la pipeline grafica è costretta ad attendere il completamento di tutto il lavoro prima di cambiare attività, con conseguenti latenze molto elevate.

Per correggere questo problema, l'architettura Pascal ha introdotto per la prima volta la possibilità di interrompere un'attività a livello di pixel: Pixel Level Preemption. Le unità di esecuzione GPU Pascal possono monitorare continuamente l'avanzamento delle attività di rendering e, quando viene richiesta un'interruzione, possono interrompere l'esecuzione, preservando il contesto per un ulteriore completamento, passando rapidamente a un'altra attività.

L'interruzione e il passaggio a livello di thread per le operazioni di elaborazione funzionano in modo simile all'interruzione a livello di pixel per l'elaborazione grafica. I carichi di lavoro di calcolo sono costituiti da più griglie, ciascuna contenente più thread. Quando viene ricevuta una richiesta di interruzione, i thread in esecuzione sul multiprocessore terminano l'esecuzione. Altri blocchi salvano il proprio stato per continuare dallo stesso punto in futuro e la GPU passa a un'altra attività. L'intero processo di cambio attività richiede meno di 100 microsecondi dopo l'uscita dei thread in esecuzione.

Per i carichi di lavoro di gioco, la combinazione di interruzioni a livello di pixel per carichi di lavoro grafici e interruzioni a livello di thread per carichi di lavoro di elaborazione offre alle GPU Pascal la possibilità di passare rapidamente da un'attività all'altra con tempi di inattività minimi. E per le attività di elaborazione su CUDA, è possibile anche un'interruzione con granularità minima, a livello di istruzioni. In questa modalità, tutti i thread interrompono l'esecuzione contemporaneamente, passando immediatamente a un'altra attività. Questo approccio richiede la memorizzazione di più informazioni sullo stato di tutti i registri di ciascun thread, ma in alcuni casi di elaborazione non grafica è abbastanza giustificato.

L'uso dell'interruzione rapida e del cambio di attività nei carichi di lavoro grafici e di calcolo è stato aggiunto all'architettura Pascal in modo che le attività grafiche e non grafiche potessero essere interrotte a livello di singole istruzioni, piuttosto che di interi thread, come nel caso di Maxwell e Kepler. . Queste tecnologie possono migliorare l'esecuzione asincrona di vari carichi di lavoro della GPU e migliorare la reattività durante l'esecuzione di più attività contemporaneamente. All'evento Nvidia, hanno mostrato una dimostrazione del calcolo asincrono usando l'esempio del calcolo degli effetti fisici. Se senza calcolo asincrono le prestazioni erano al livello di 77-79 FPS, con l'inclusione di queste funzionalità il frame rate aumentava a 93-94 FPS.

Abbiamo già fornito un esempio di una delle possibilità di utilizzo di questa funzionalità nei giochi sotto forma di distorsione temporale asincrona in VR. L'illustrazione mostra il funzionamento di questa tecnologia sia con interruzione tradizionale (prelazione) che con interruzione veloce. Nel primo caso, cercano di eseguire il processo di distorsione temporale asincrona il più tardi possibile, ma prima dell'inizio dell'aggiornamento dell'immagine sul display. Ma il lavoro dell'algoritmo deve essere inviato alla GPU per l'esecuzione qualche millisecondo prima, poiché senza un'interruzione rapida non è possibile eseguire con precisione il lavoro al momento giusto e la GPU rimane inattiva per un po'.

Nel caso dell'interruzione precisa in pixel e thread (mostrata a destra), questa funzionalità consente una maggiore precisione nel determinare quando si verifica l'interruzione e la distorsione temporale asincrona può essere avviata molto più tardi con la sicurezza di completare il lavoro prima dell'avvio della visualizzazione. in aggiornamento. E la GPU, che nel primo caso è inattiva per un po', può essere caricata con qualche lavoro grafico aggiuntivo.

Tecnologia di multiproiezione simultanea

La nuova GPU GP104 ora supporta la nuova tecnologia Simultaneous Multi-Projection (SMP), consentendo alla GPU di eseguire il rendering dei dati sui moderni sistemi di visualizzazione in modo più efficiente. SMP consente al chip video di emettere simultaneamente i dati in diverse proiezioni, il che ha richiesto l'introduzione di un nuovo blocco hardware nella GPU come parte del motore PolyMorph alla fine della pipeline della geometria prima dell'unità di rasterizzazione. Questo blocco è responsabile dell'utilizzo di più proiezioni per un singolo flusso di geometria.

Il motore multi-proiezione elabora simultaneamente i dati geometrici per 16 proiezioni preconfigurate combinando il punto di proiezione (telecamera), queste proiezioni possono essere ruotate o inclinate in modo indipendente. Poiché ciascuna geometria primitiva può apparire in più viste contemporaneamente, il motore SMP fornisce questa funzionalità consentendo all'applicazione di istruire la GPU a replicare la geometria fino a 32 volte (16 viste su due centri di proiezione) senza ulteriore elaborazione.

L'intero processo di elaborazione è accelerato via hardware e, poiché la multiproiezione funziona dopo il motore geometrico, non è necessario ripetere più volte tutte le fasi di elaborazione della geometria. Il risparmio di risorse è importante quando la velocità di rendering è limitata dalle prestazioni di elaborazione della geometria, come la tassellatura, dove lo stesso lavoro geometrico viene eseguito più volte per ciascuna proiezione. Di conseguenza, nel caso di picco, la multiproiezione può ridurre la necessità di elaborazione della geometria fino a 32 volte.

Ma perché è necessario tutto questo? Ci sono alcuni buoni esempi in cui la tecnologia multiproiezione può essere utile. Ad esempio, un sistema multi-monitor di tre display installati ad angolo l'uno rispetto all'altro abbastanza vicino all'utente (configurazione surround). In una situazione tipica, la scena viene renderizzata in una proiezione, il che porta a distorsioni geometriche e a un rendering della geometria errato. Il modo corretto è avere tre proiezioni diverse per ciascuno dei monitor, a seconda dell'angolazione in cui sono posizionati.

Utilizzando una scheda video su un chip con architettura Pascal, questo può essere fatto in un unico passaggio geometrico, specificando tre diverse proiezioni, ciascuna per il proprio monitor. E l'utente potrà così modificare l'angolo con cui i monitor si trovano tra loro non solo fisicamente, ma anche virtualmente, ruotando le proiezioni per i monitor laterali per ottenere la prospettiva corretta nella scena 3D con un angolo di visione notevolmente più ampio (FOV). Tuttavia, qui c'è una limitazione: per tale supporto, l'applicazione deve essere in grado di eseguire il rendering della scena con un ampio FOV e utilizzare speciali chiamate API SMP per impostarla. Cioè, non puoi farlo in ogni gioco; hai bisogno di un supporto speciale.

In ogni caso, i giorni di una singola proiezione su un singolo monitor a schermo piatto sono finiti, con molte configurazioni multi-monitor e display curvi ora disponibili che possono utilizzare anche questa tecnologia. Per non parlare dei sistemi di realtà virtuale che utilizzano lenti speciali tra gli schermi e gli occhi dell'utente, che richiedono nuove tecniche per proiettare un'immagine 3D in un'immagine 2D. Molte di queste tecnologie e tecniche sono ancora nelle prime fasi di sviluppo, la cosa principale è che le GPU più vecchie non possono utilizzare efficacemente più di una vista piana. Richiedono diversi passaggi di rendering, elaborazione ripetuta della stessa geometria, ecc.

I chip dell'architettura Maxwell avevano un supporto limitato per la multi-risoluzione per contribuire a migliorare l'efficienza, ma l'SMP di Pascal può fare molto di più. Maxwell poteva ruotare la proiezione di 90 gradi per la mappatura del cubo o diverse risoluzioni di proiezione, ma ciò era utile solo in applicazioni limitate come VXGI.

Altre possibilità per l'utilizzo di SMP includono il rendering multi-risoluzione e il rendering stereo a passaggio singolo. Ad esempio, Multi-Res Shading può essere utilizzato nei giochi per ottimizzare le prestazioni. Quando applicata, viene utilizzata una risoluzione più elevata al centro del fotogramma, mentre alla periferia viene ridotta per ottenere una velocità di rendering più elevata.

Il rendering stereo a passaggio singolo viene utilizzato in VR, già aggiunto al pacchetto VRWorks, e utilizza funzionalità di multiproiezione per ridurre la quantità di lavoro geometrico richiesto nel rendering VR. Quando viene utilizzata questa funzionalità, la GPU GeForce GTX 1080 elabora la geometria della scena solo una volta, generando due proiezioni per ciascun occhio contemporaneamente, il che dimezza il carico geometrico sulla GPU e riduce anche le perdite derivanti dal funzionamento del driver e del sistema operativo.

Un metodo ancora più avanzato per aumentare l'efficienza del rendering VR è Lens Matched Shading, che utilizza più proiezioni per simulare le distorsioni geometriche richieste nel rendering VR. Questo metodo utilizza la multiproiezione per eseguire il rendering di una scena 3D su una superficie che si avvicina al rendering corretto dall'obiettivo per il rendering del visore VR, evitando di disegnare molti pixel extra sulla periferia che verranno scartati. Il modo più semplice per comprendere l'essenza del metodo è dall'illustrazione: vengono utilizzate quattro proiezioni leggermente espanse davanti a ciascun occhio (su Pascal è possibile utilizzare 16 proiezioni per ciascun occhio - per un'imitazione più accurata di una lente curva) invece di uno:

Questo approccio può far risparmiare notevolmente sulle prestazioni. Pertanto, una tipica immagine di Oculus Rift per ciascun occhio è di 1,1 megapixel. Ma a causa della differenza nelle proiezioni, per renderla viene utilizzata un'immagine sorgente da 2,1 megapixel: 86% più grande del necessario! L'uso della multiproiezione, implementato nell'architettura Pascal, consente di ridurre la risoluzione dell'immagine renderizzata a 1,4 megapixel, ottenendo un risparmio di una volta e mezza nella velocità di elaborazione dei pixel, oltre a risparmiare larghezza di banda della memoria.

E insieme al doppio risparmio nella velocità di elaborazione della geometria grazie al rendering stereo a passaggio singolo, la scheda grafica GeForce GTX 1080 è in grado di fornire un aumento significativo delle prestazioni di rendering VR, che è molto impegnativo sia in termini di velocità di elaborazione della geometria, sia in termini di velocità di elaborazione della geometria. ancora di più nell'elaborazione dei pixel.

Miglioramenti nell'uscita video e nelle unità di elaborazione

Oltre alle prestazioni e alle nuove funzionalità associate al rendering 3D, è necessario mantenere un buon livello di capacità di output delle immagini, nonché di decodifica e codifica video. E la prima GPU con architettura Pascal non ha deluso: supporta tutti gli standard moderni in questo senso, inclusa la decodifica hardware del formato HEVC, necessaria per guardare video 4K su un PC. Inoltre, i futuri possessori delle schede video GeForce GTX 1080 potranno presto godersi la riproduzione di video in streaming 4K da Netflix e altri provider sui propri sistemi.

In termini di output video, la GeForce GTX 1080 supporta HDMI 2.0b con HDCP 2.2, oltre a DisplayPort. Finora la versione DP 1.2 è stata certificata, ma la GPU è pronta per la certificazione per le versioni più recenti dello standard: DP 1.3 Ready e DP 1.4 Ready. Quest'ultimo consente ai display 4K di essere trasmessi con una frequenza di aggiornamento di 120 Hz e ai display 5K e 8K di funzionare a 60 Hz utilizzando una coppia di cavi DisplayPort 1.3. Se per la GTX 980 la risoluzione massima supportata era 5120x3200 a 60 Hz, per il nuovo modello GTX 1080 è aumentata a 7680x4320 agli stessi 60 Hz. La GeForce GTX 1080 di riferimento ha tre uscite DisplayPort, una HDMI 2.0be una digitale Dual-Link DVI.

Il nuovo modello di scheda video Nvidia ha ricevuto anche un'unità di decodifica e codifica dei dati video migliorata. Pertanto, il chip GP104 soddisfa gli elevati standard di PlayReady 3.0 (SL3000) per la riproduzione in streaming video, permettendoti di essere sicuro che la riproduzione di contenuti di alta qualità da fornitori affidabili come Netflix sarà la più alta qualità ed efficiente dal punto di vista energetico possibile. I dettagli sul supporto per vari formati video durante la codifica e la decodifica sono riportati nella tabella; il nuovo prodotto differisce chiaramente in meglio dalle soluzioni precedenti:

Ma una novità ancora più interessante è il supporto per i cosiddetti display High Dynamic Range (HDR), che stanno per diffondersi sul mercato. I televisori sono già in vendita nel 2016 (e si prevede che saranno venduti quattro milioni di televisori HDR in un solo anno) e i monitor l’anno prossimo. L'HDR rappresenta il più grande progresso nella tecnologia dei display degli ultimi anni, il formato fornisce il doppio delle tonalità di colore (75% dello spettro visibile, contro il 33% dell'RGB), display più luminosi (1.000 nit) con maggiore contrasto (10.000:1) e colori ricchi.

L'emergere della capacità di riprodurre contenuti con una maggiore differenza di luminosità e colori più ricchi e saturi avvicinerà l'immagine sullo schermo alla realtà, i neri diventeranno più profondi e la luce intensa sarà accecante, come nel mondo reale. Di conseguenza, gli utenti vedranno più dettagli nelle aree chiare e scure delle immagini rispetto ai monitor e ai televisori standard.

Per supportare i display HDR, la GeForce GTX 1080 ha tutto ciò di cui hai bisogno: la capacità di riprodurre colori a 12 bit, supporto per gli standard BT.2020 e SMPTE 2084, nonché un'uscita conforme allo standard HDMI 2.0b 10/12 bit standard per HDR con risoluzione 4K, come nel caso di Maxwell. Oltre a ciò, Pascal ora supporta la decodifica del formato HEVC con risoluzione 4K a 60 Hz e colore a 10 o 12 bit, utilizzato per i video HDR, nonché la codifica dello stesso formato con gli stessi parametri, ma solo in 10 -bit per la registrazione o lo streaming di video HDR. Il nuovo prodotto è anche pronto per standardizzare DisplayPort 1.4 per la trasmissione di dati HDR tramite questo connettore.

A proposito, in futuro potrebbe essere necessaria la codifica video HDR per trasferire tali dati da un PC di casa a una console di gioco SHIELD in grado di riprodurre HEVC a 10 bit. Cioè, l'utente potrà trasmettere il gioco da un PC in formato HDR. Aspetta, dove posso trovare giochi con tale supporto? Nvidia lavora continuamente con gli sviluppatori di giochi per implementare questo supporto, fornendo loro tutto ciò di cui hanno bisogno (supporto driver, esempi di codice, ecc.) per rendere correttamente le immagini HDR compatibili con i display esistenti.

Al momento del rilascio della scheda video GeForce GTX 1080, giochi come Obduction, The Witness, Lawbreakers, Rise of the Tomb Raider, Paragon, The Talos Principle e Shadow Warrior 2 supportano l'output HDR. Ma nel prossimo futuro questo elenco è previsto il rifornimento.

Modifiche al rendering multi-chip SLI

Ci sono stati anche alcuni cambiamenti legati alla tecnologia proprietaria di rendering multi-chip SLI, anche se nessuno se lo aspettava. La tecnologia SLI viene utilizzata dagli appassionati di giochi per PC per spingere le prestazioni a livelli estremi accoppiando potenti schede video a chip singolo in tandem o per ottenere frame rate molto elevati limitandosi a un paio di soluzioni di fascia media che a volte sono più economiche di una top di gamma. -end (La decisione è controversa, ma lo fanno in questo modo). Con i monitor 4K, i giocatori non hanno quasi altra opzione se non l'installazione di un paio di schede video, poiché anche i modelli di punta spesso non sono in grado di fornire un gioco confortevole con le impostazioni massime in tali condizioni.

Uno dei componenti importanti di Nvidia SLI sono i bridge che collegano le schede video in un sottosistema video comune e servono a organizzare un canale digitale per il trasferimento dei dati tra di loro. Le schede video GeForce tradizionalmente presentavano doppi connettori SLI, che servivano a collegare due o quattro schede video in configurazioni SLI a 3 e 4 vie. Ciascuna scheda video doveva connettersi a ciascuna di esse, poiché tutte le GPU inviavano i fotogrammi renderizzati alla GPU principale, motivo per cui erano necessarie due interfacce su ciascuna scheda.

A partire dalla GeForce GTX 1080, tutte le schede grafiche Nvidia basate sull'architettura Pascal collegano insieme due interfacce SLI per migliorare le prestazioni di trasferimento tra GPU e questa nuova modalità SLI dual-link migliora le prestazioni e l'esperienza visiva su display ad altissima risoluzione. sistemi multimonitor.

Questa modalità richiedeva anche nuovi bridge, chiamati SLI HB. Combinano una coppia di schede video GeForce GTX 1080 su due canali SLI contemporaneamente, sebbene le nuove schede video siano compatibili anche con i bridge più vecchi. Per risoluzioni di 1920×1080 e 2560×1440 pixel con una frequenza di aggiornamento di 60 Hz, è possibile utilizzare bridge standard, ma nelle modalità più impegnative (sistemi 4K, 5K e multi-monitor), solo i nuovi bridge forniranno i migliori risultati in in termini di morbidezza del telaio, anche se quelli vecchi funzioneranno, ma un po' peggio.

Inoltre, quando si utilizzano bridge SLI HB, l'interfaccia di trasferimento dati della GeForce GTX 1080 funziona a 650 MHz, rispetto ai 400 MHz dei bridge SLI convenzionali sulle GPU più vecchie. Inoltre per alcuni dei vecchi ponti rigidi è disponibile anche una frequenza di trasmissione dati più elevata con chip video con architettura Pascal. Con un aumento della velocità di trasferimento dati tra GPU tramite una doppia interfaccia SLI con una maggiore frequenza operativa, è garantita una resa dei fotogrammi sullo schermo più fluida rispetto alle soluzioni precedenti:

Va anche notato che il supporto per il rendering multi-chip in DirectX 12 è leggermente diverso da quello abituale prima. Nell'ultima versione dell'API grafica, Microsoft ha apportato numerose modifiche relative al funzionamento di tali sistemi video. Per gli sviluppatori di software, DX12 offre due opzioni per l'utilizzo di più GPU: modalità Multi Display Adapter (MDA) e Linked Display Adapter (LDA).

Inoltre, la modalità LDA ha due forme: LDA implicita (che Nvidia utilizza per SLI) e LDA esplicita (quando lo sviluppatore del gioco si assume il compito di gestire il rendering multi-chip. Le modalità MDA e LDA esplicita sono state introdotte in DirectX 12 in ordine per dare agli sviluppatori di giochi maggiore libertà e opportunità quando utilizzano sistemi video multi-chip. La differenza tra le modalità è chiaramente visibile nella tabella seguente:

In modalità LDA, la memoria di ciascuna GPU può essere collegata alla memoria di un'altra e visualizzata come un grande volume totale, ovviamente con tutte le limitazioni prestazionali quando i dati vengono presi da una memoria "estranea". In modalità MDA, la memoria di ciascuna GPU funziona separatamente e GPU diverse non possono accedere direttamente ai dati dalla memoria di un'altra GPU. La modalità LDA è progettata per sistemi multi-chip con prestazioni simili, mentre la modalità MDA presenta meno restrizioni e può funzionare insieme tra GPU discrete e integrate o soluzioni discrete con chip di produttori diversi. Ma questa modalità richiede anche più riflessione e lavoro da parte degli sviluppatori durante la programmazione per lavorare insieme in modo che le GPU possano comunicare tra loro.

Per impostazione predefinita, un sistema SLI basato sulle schede GeForce GTX 1080 supporta solo due GPU e le configurazioni a tre e quattro chip non sono ufficialmente consigliate per l'uso, poiché nei giochi moderni sta diventando sempre più difficile fornire miglioramenti in termini di prestazioni aggiungendo un terzo e quarta GPU. Ad esempio, molti giochi si affidano alle capacità del processore centrale del sistema quando utilizzano sistemi video multi-chip; i nuovi giochi utilizzano sempre più spesso anche tecniche temporali che utilizzano dati di fotogrammi precedenti, in cui il funzionamento efficace di più GPU contemporaneamente è semplicemente impossibile.

Tuttavia, rimane possibile il funzionamento di sistemi in altri sistemi multi-chip (non SLI), come le modalità MDA o LDA Explicit in DirectX 12 o un sistema SLI dual-chip con una terza GPU dedicata per effetti fisici PhysX. Che dire dei record nei benchmark? Davvero Nvidia li sta abbandonando del tutto? No, certo, ma poiché tali sistemi sono richiesti nel mondo da quasi pochi utenti, per questi ultra-appassionati hanno creato una speciale Enthusiast Key, che può essere scaricata sul sito Web di Nvidia e sbloccare questa funzionalità. Per fare ciò è necessario prima ottenere un identificatore GPU univoco eseguendo un'apposita applicazione, quindi richiedere la Enthusiast Key sul sito e, dopo averla scaricata, installare la chiave nel sistema, sbloccando così le configurazioni SLI a 3 e 4 vie .

Tecnologia di sincronizzazione veloce

Si sono verificati alcuni cambiamenti nelle tecnologie di sincronizzazione durante la visualizzazione delle informazioni. Guardando al futuro, non è apparso nulla di nuovo in G-Sync, né è supportata la tecnologia Adaptive Sync. Ma Nvidia ha deciso di migliorare la fluidità dell'output e della sincronizzazione per i giochi che mostrano prestazioni molto elevate quando il frame rate è notevolmente superiore alla frequenza di aggiornamento del monitor. Ciò è particolarmente importante per i giochi che richiedono una latenza minima e una risposta rapida e che ospitano battaglie e competizioni multiplayer.

La sincronizzazione rapida è una nuova alternativa alla sincronizzazione verticale che non presenta artefatti visivi come lo strappo dell'immagine e non è legata a una frequenza di aggiornamento fissa, che aumenta la latenza. Qual è il problema con Vsync in giochi come Counter-Strike: Global Offensive? Questo gioco funziona a diverse centinaia di fotogrammi al secondo su potenti GPU moderne e il giocatore può scegliere se abilitare o meno la sincronizzazione verticale.

Nei giochi multiplayer, gli utenti spesso cercano una latenza minima e disabilitano VSync, con conseguente lacerazione chiaramente visibile dell'immagine, il che è estremamente spiacevole anche a frame rate elevati. Se abiliti la sincronizzazione verticale, il giocatore sperimenterà un aumento significativo dei ritardi tra le sue azioni e l'immagine sullo schermo quando la pipeline grafica rallenta alla frequenza di aggiornamento del monitor.

Ecco come funziona un trasportatore tradizionale. Ma Nvidia ha deciso di separare il processo di rendering e di visualizzazione delle immagini sullo schermo utilizzando la tecnologia Fast Sync. Ciò consente alla parte della GPU che esegue il rendering dei frame di continuare a funzionare nel modo più efficiente possibile alla massima velocità, archiviando tali frame in uno speciale buffer temporaneo, il Last Rendered Buffer.

Questo metodo ti consente di modificare il modo in cui visualizzi lo schermo e sfruttare al meglio le modalità VSync On e VSync Off, ottenendo una bassa latenza ma senza artefatti dell'immagine. Con Fast Sync non c'è controllo del flusso dei frame, il motore di gioco funziona in modalità di sincronizzazione disabilitata e non gli viene detto di aspettare per eseguire il rendering di quello successivo, quindi le latenze sono quasi basse quanto con la modalità VSync Off. Ma poiché Fast Sync seleziona in modo indipendente un buffer per l'output sullo schermo e visualizza l'intero fotogramma, non si verificano interruzioni dell'immagine.

Fast Sync utilizza tre diversi buffer, i primi due dei quali funzionano in modo simile al doppio buffering in una pipeline classica. Il buffer primario (Front Buffer - FB) è il buffer da cui vengono visualizzate le informazioni sul display, un frame completamente renderizzato. Il buffer secondario (Back Buffer - BB) è un buffer che riceve informazioni durante il rendering.

Quando si utilizza la sincronizzazione verticale a frame rate elevati, il gioco attende fino al raggiungimento dell'intervallo di aggiornamento per scambiare il buffer primario con il buffer secondario per visualizzare l'intero fotogramma sullo schermo. Ciò rallenta il processo e l'aggiunta di buffer aggiuntivi come il triplo buffering tradizionale non farà altro che aumentare il ritardo.

Con Fast Sync viene aggiunto un terzo buffer, il Last Rendered Buffer (LRB), che viene utilizzato per archiviare tutti i fotogrammi appena renderizzati nel buffer secondario. Il nome del buffer parla da solo; contiene una copia dell'ultimo fotogramma completamente renderizzato. E quando arriva il momento di aggiornare il buffer primario, questo buffer LRB viene copiato sul primario nel suo insieme e non in parti, come dal secondario quando la sincronizzazione verticale è disabilitata. Poiché la copia delle informazioni dai buffer è inefficace, queste vengono semplicemente scambiate (o rinominate, come sarà più comodo da capire) e la nuova logica per lo scambio dei buffer, apparsa in GP104, gestisce questo processo.

In pratica, abilitare il nuovo metodo di sincronizzazione Fast Sync garantisce comunque un ritardo leggermente superiore rispetto alla disattivazione totale della sincronizzazione verticale - in media 8 ms in più, ma visualizza i fotogrammi sul monitor nella loro interezza, senza spiacevoli artefatti sullo schermo che strappano la vista. Immagine. Il nuovo metodo può essere abilitato dalle impostazioni grafiche del pannello di controllo di Nvidia nella sezione Controllo Vsync. Tuttavia, il valore predefinito rimane il controllo dell'applicazione e semplicemente non è necessario abilitare la sincronizzazione rapida in tutte le applicazioni 3D; è meglio scegliere questo metodo appositamente per i giochi FPS elevati.

Tecnologie di realtà virtuale Nvidia VRWorks

Abbiamo toccato il tema caldo della realtà virtuale più di una volta nell'articolo, ma abbiamo parlato principalmente di aumentare il frame rate e garantire una bassa latenza, che sono molto importanti per la realtà virtuale. Tutto questo è molto importante e si stanno effettivamente facendo progressi, ma finora i giochi VR non sembrano così impressionanti come i migliori giochi 3D moderni “normali”. Ciò accade non solo perché i principali sviluppatori di giochi non sono ancora particolarmente coinvolti nelle applicazioni VR, ma anche perché la realtà virtuale è più esigente in termini di frame rate, il che impedisce l'uso di molte delle tecniche abituali in tali giochi a causa delle loro elevate esigenze.

Per ridurre la differenza di qualità tra i giochi VR e quelli normali, Nvidia ha deciso di rilasciare un intero pacchetto di tecnologie VRWorks rilevanti, che includeva un gran numero di API, librerie, motori e tecnologie in grado di migliorare significativamente sia la qualità che le prestazioni dei giochi VR. Giochi VR, applicazioni. Come si collega tutto questo all'annuncio della prima soluzione di gioco basata su Pascal? È molto semplice: sono state introdotte alcune tecnologie per aumentare la produttività e migliorare la qualità, e ne abbiamo già scritto.

E sebbene la questione non riguardi solo la grafica, prima ne parleremo un po’. L'insieme delle tecnologie VRWorks Graphics include le tecnologie precedentemente menzionate, come Lens Matched Shading, che utilizza la funzionalità multiproiezione apparsa nella GeForce GTX 1080. Il nuovo prodotto consente di ottenere un aumento delle prestazioni di 1,5-2 volte rispetto alle soluzioni che non hanno tale supporto. Abbiamo menzionato anche altre tecnologie, come MultiRes Shading, pensata per il rendering con diverse risoluzioni al centro e alla periferia dell'inquadratura.

Ma molto più inaspettato è stato l'annuncio della tecnologia VRWorks Audio, progettata per l'elaborazione di alta qualità dei dati audio nelle scene 3D, che è particolarmente importante nei sistemi di realtà virtuale. Nei motori convenzionali, il posizionamento delle sorgenti sonore nell'ambiente virtuale viene calcolato in modo abbastanza corretto; se il nemico spara da destra, il suono è più forte da quel lato del sistema audio e tale calcolo non richiede troppo potenza di calcolo .

Ma in realtà, i suoni non arrivano solo al giocatore, ma in tutte le direzioni e vengono riflessi da vari materiali, in modo simile a come vengono riflessi i raggi luminosi. E in realtà sentiamo queste riflessioni, anche se non così chiaramente come le onde sonore dirette. Queste riflessioni indirette del suono vengono solitamente simulate da speciali effetti di riverbero, ma questo è un approccio molto primitivo al compito.

VRWorks Audio utilizza il rendering delle onde sonore simile al ray tracing nel rendering, in cui il percorso dei raggi luminosi viene tracciato in base alle riflessioni multiple degli oggetti in una scena virtuale. VRWorks Audio simula inoltre la propagazione delle onde sonore nell'ambiente tracciando le onde dirette e riflesse a seconda del loro angolo di incidenza e delle proprietà dei materiali riflettenti. Nel suo lavoro, VRWorks Audio utilizza il motore Nvidia OptiX ad alte prestazioni, noto per attività grafiche, progettato per il ray tracing. OptiX può essere utilizzato per una varietà di attività, come il calcolo dell'illuminazione indiretta e la preparazione di mappe luminose, e ora per il tracciamento delle onde sonore in VRWorks Audio.

Nvidia ha integrato calcoli precisi delle onde sonore nella sua demo VR Funhouse, che utilizza diverse migliaia di raggi e calcola fino a 12 riflessioni dagli oggetti. E per comprendere i vantaggi della tecnologia utilizzando un chiaro esempio, ti invitiamo a guardare un video sul funzionamento della tecnologia in russo:

È importante che l'approccio di Nvidia differisca dai tradizionali motori audio, inclusa l'accelerazione hardware utilizzando un blocco speciale nel metodo GPU del suo principale concorrente. Tutti questi metodi forniscono solo il posizionamento preciso delle sorgenti sonore, ma non calcolano la riflessione delle onde sonore degli oggetti in una scena 3D, sebbene possano simularla utilizzando l'effetto riverbero. Tuttavia, l’uso della tecnologia ray tracing può essere molto più realistico, poiché solo questo approccio fornirà una simulazione accurata di vari suoni, tenendo conto delle dimensioni, della forma e dei materiali degli oggetti nella scena. È difficile dire se una tale precisione di calcolo sia necessaria per un giocatore tipico, ma una cosa è certa: in VR può aggiungere agli utenti quel realismo che ancora manca nei giochi normali.

Bene, tutto ciò di cui ci resta da parlare è la tecnologia VR SLI, che funziona sia in OpenGL che in DirectX. Il suo principio è estremamente semplice: un sistema video a doppio processore in un'applicazione VR funzionerà in modo tale che a ciascun occhio venga assegnata una GPU separata, a differenza del rendering AFR, comune nelle configurazioni SLI. Ciò migliora significativamente le prestazioni complessive, che sono così importanti per i sistemi di realtà virtuale. In teoria è possibile utilizzare più GPU, ma il loro numero deve essere pari.

Questo approccio era necessario perché l'AFR non è adatto alla realtà virtuale, poiché con il suo aiuto la prima GPU disegnerà un fotogramma uniforme per entrambi gli occhi e la seconda uno strano, che non riduce la latenza, che è fondamentale per i sistemi di realtà virtuale . Anche se il frame rate sarà piuttosto alto. Quindi, con VR SLI, il lavoro su ciascun fotogramma è diviso in due GPU: una lavora su una parte del fotogramma per l'occhio sinistro, la seconda per quello destro, e quindi queste metà del fotogramma vengono combinate in un tutto.

Questa divisione del lavoro tra una coppia di GPU si traduce in miglioramenti prestazionali quasi doppi, consentendo frame rate più elevati e una latenza inferiore rispetto ai sistemi a GPU singola. Tuttavia, l'utilizzo di VR SLI richiede un supporto speciale da parte dell'applicazione per utilizzare questo metodo di ridimensionamento. Ma la tecnologia VR SLI è già integrata in applicazioni demo VR come The Lab di Valve e Trials on Tatooine di ILMxLAB, e questo è solo l'inizio: Nvidia promette che presto appariranno altre applicazioni, così come l'implementazione della tecnologia nei motori di gioco Unreal Engine 4 , Unità e MaxPlay.

Piattaforma di screenshot dei giochi Ansel

Uno degli annunci più interessanti relativi al software è stato il rilascio della tecnologia per acquisire screenshot di alta qualità nelle applicazioni di gioco, dal nome di un famoso fotografo: Ansel. I giochi sono diventati da tempo non solo giochi, ma anche un luogo di utilizzo delle mani giocose per vari individui creativi. Alcune persone modificano gli script per i giochi, alcuni rilasciano set di trame di alta qualità per i giochi e alcuni acquisiscono bellissimi screenshot.

Nvidia ha deciso di aiutare quest'ultimo introducendo una nuova piattaforma per creare (e creare, perché non è un processo così semplice) immagini di alta qualità dai giochi. Credono che Ansel possa contribuire a creare un nuovo tipo di arte contemporanea. Dopotutto, ci sono già molti artisti che trascorrono gran parte della loro vita su un PC, creando bellissimi screenshot dai giochi, e non avevano ancora uno strumento conveniente per questo.

Ansel ti consente non solo di catturare un'immagine in un gioco, ma di modificarla secondo le esigenze del creatore. Utilizzando questa tecnologia è possibile spostare la fotocamera sulla scena, ruotarla e inclinarla in qualsiasi direzione per ottenere la composizione desiderata dell'inquadratura. Ad esempio, in giochi come gli sparatutto in prima persona, puoi solo spostare il giocatore, non puoi cambiare nient'altro, quindi tutti gli screenshot risultano piuttosto monotoni. Con una fotocamera gratuita ad Ansel, puoi andare ben oltre i limiti della fotocamera da gioco, scegliendo l'angolazione necessaria per un'immagine di successo o persino catturare un'immagine stereo completa a 360 gradi dal punto desiderato e in alta risoluzione per visione successiva con un casco VR.

Ansel funziona in modo abbastanza semplice: utilizzando una libreria speciale di Nvidia, questa piattaforma viene implementata nel codice del gioco. Per fare ciò, il suo sviluppatore deve solo aggiungere una piccola porzione di codice al suo progetto per consentire al driver video Nvidia di intercettare i dati del buffer e dello shader. Il lavoro richiesto è minimo: l'implementazione di Ansel nel gioco richiede meno di un giorno. Pertanto, abilitare questa funzionalità in The Witness ha richiesto circa 40 righe di codice e in The Witcher 3 circa 150 righe di codice.

Ansel verrà fornito con un SDK open source. La cosa principale è che l'utente riceve con esso un set standard di impostazioni che gli consentono di modificare la posizione e l'angolazione della telecamera, aggiungere effetti, ecc. La piattaforma Ansel funziona così: mette in pausa il gioco, accende la telecamera gratuita e ti consente di modificare la cornice nella vista desiderata, registrando il risultato sotto forma di uno screenshot normale, un'immagine a 360 gradi, una coppia stereo o semplicemente un panorama ad alta risoluzione.

L'unico avvertimento è che non tutti i giochi supporteranno tutte le funzionalità della piattaforma di screenshot del gioco Ansel. Alcuni sviluppatori di giochi, per un motivo o per l'altro, non vogliono abilitare una fotocamera completamente gratuita nei loro giochi, ad esempio a causa della possibilità che gli imbroglioni utilizzino questa funzionalità. Oppure vogliono limitare la variazione dell'angolo di visione per lo stesso motivo, in modo che nessuno tragga un vantaggio ingiusto. Bene, o almeno così che gli utenti non vedano i poveri folletti sullo sfondo. Tutti questi sono desideri del tutto normali dei creatori di giochi.

Una delle caratteristiche più interessanti di Ansel è la creazione di screenshot con una risoluzione semplicemente enorme. Non importa che il gioco supporti risoluzioni fino a 4K, ad esempio, e che il monitor dell'utente sia Full HD. Utilizzando la piattaforma screenshot è possibile acquisire un'immagine di qualità molto più elevata, che è limitata piuttosto dalla capacità e dalle prestazioni dell'unità. La piattaforma cattura facilmente screenshot con una risoluzione fino a 4,5 gigapixel, unendoli insieme da 3600 pezzi!

È chiaro che in tali immagini è possibile vedere tutti i dettagli, fino al testo sui giornali in lontananza, se tale livello di dettaglio è in linea di principio previsto nel gioco - Ansel può anche controllare il livello di dettaglio, impostando il livello massimo per ottenere la migliore qualità dell'immagine. Ma puoi anche abilitare il supersampling. Tutto ciò ti consente di creare immagini dai giochi che puoi stampare in sicurezza su banner di grandi dimensioni ed essere sicuro della loro qualità.

È interessante notare che per unire immagini di grandi dimensioni viene utilizzato uno speciale codice con accelerazione hardware basato su CUDA. Dopotutto, nessuna scheda video può riprodurre un'immagine multi-gigapixel nel suo insieme, ma può farlo in pezzi, che devono semplicemente essere combinati in seguito, tenendo conto delle possibili differenze di illuminazione, colore, ecc.

Dopo aver cucito tali panorami, viene utilizzata una post-elaborazione speciale per l'intero fotogramma, anch'essa accelerata sulla GPU. E per acquisire immagini con una gamma dinamica maggiore, è possibile utilizzare un formato immagine speciale: EXR, uno standard aperto di Industrial Light and Magic, i cui valori di colore sono registrati in formato a virgola mobile a 16 bit (FP16) in ciascun canale.

Questo formato consente di modificare la luminosità e la gamma dinamica dell'immagine mediante post-elaborazione, portandola al livello desiderato per ogni specifico display, allo stesso modo in cui si fa con i formati RAW delle fotocamere. E per il successivo utilizzo di filtri di post-elaborazione nei programmi di elaborazione immagini, questo formato è molto utile poiché contiene molti più dati rispetto ai formati immagine convenzionali.

Ma la stessa piattaforma Ansel contiene molti filtri di post-elaborazione, il che è particolarmente importante perché ha accesso non solo all'immagine finale, ma anche a tutti i buffer utilizzati dal gioco durante il rendering, che possono essere utilizzati per effetti molto interessanti , come la profondità di campo. Ansel dispone di una speciale API di post-elaborazione per questo e qualsiasi effetto può essere incluso in un gioco che supporta questa piattaforma.

I filtri post Ansel includono i seguenti filtri: curve di colore, spazio colore, trasformazione, desaturazione, luminosità/contrasto, grana della pellicola, fioritura, riflesso lente, abbagliamento anamorfico, distorsione, foschia, fisheye, aberrazione cromatica, mappatura dei toni, sporco sull'obiettivo, fasci di luce, vignettatura, correzione gamma, convoluzione, nitidezza, rilevamento dei bordi, sfocatura, seppia, riduzione del rumore, FXAA e altri.

Per quanto riguarda la comparsa del supporto Ansel nei giochi, bisognerà aspettare un po' finché gli sviluppatori non lo implementeranno e lo testeranno. Ma Nvidia promette l'imminente comparsa di tale supporto in giochi famosi come The Division, The Witness, Lawbreakers, The Witcher 3, Paragon, Fortnite, Obduction, No Man's Sky, Unreal Tournament e altri.

Il nuovo processo tecnologico FinFET da 16 nm e l'ottimizzazione dell'architettura hanno consentito alla scheda video GeForce GTX 1080, basata sul processore grafico GP104, di raggiungere un'elevata frequenza di clock di 1,6-1,7 GHz anche nella forma di riferimento, e la nuova generazione garantisce il funzionamento a frequenze più alte possibili nei giochi Tecnologia GPU Boost. Insieme all'aumento del numero di unità di esecuzione, questi miglioramenti hanno reso il nuovo prodotto non solo la scheda video a chip singolo con le prestazioni più elevate di tutti i tempi, ma anche la soluzione più efficiente dal punto di vista energetico sul mercato.

Il modello GeForce GTX 1080 è diventata la prima scheda video a portare un nuovo tipo di memoria grafica GDDR5X, una nuova generazione di chip ad alta velocità che ha permesso di raggiungere velocità di trasferimento dati molto elevate. Nel caso della modifica GeForce GTX 1080, questo tipo di memoria funziona a una frequenza effettiva di 10 GHz. In combinazione con gli algoritmi migliorati di compressione delle informazioni nel framebuffer, ciò ha portato ad un aumento della larghezza di banda di memoria effettiva per questo processore grafico di 1,7 volte rispetto al suo diretto predecessore, la GeForce GTX 980.

Nvidia ha saggiamente deciso di non rilasciare un'architettura radicalmente nuova su un processo tecnologico completamente nuovo, in modo da non incontrare problemi inutili durante lo sviluppo e la produzione. Invece, hanno migliorato seriamente la già buona e molto efficiente architettura Maxwell, aggiungendo alcune funzionalità. Di conseguenza, tutto va bene con la produzione di nuove GPU e, nel caso del modello GeForce GTX 1080, gli ingegneri hanno raggiunto un potenziale di frequenza molto elevato: nelle versioni overclockate dei partner, sono previste frequenze GPU fino a 2 GHz! Una frequenza così impressionante è diventata possibile grazie al perfetto processo tecnico e al lavoro scrupoloso degli ingegneri Nvidia durante lo sviluppo della GPU Pascal.

E sebbene Pascal sia diventato un successore diretto di Maxwell, e queste architetture grafiche non siano fondamentalmente molto diverse l'una dall'altra, Nvidia ha introdotto molti cambiamenti e miglioramenti, inclusa la capacità di visualizzare immagini sui display, il motore di codifica e decodifica video e una migliore interfaccia asincrona esecuzione di vari tipi di calcoli sulla GPU, apportato modifiche al rendering multi-chip e introdotto un nuovo metodo di sincronizzazione, Fast Sync.

È impossibile non evidenziare la tecnologia di multiproiezione Simultaneous Multi-Projection, che aiuta a migliorare le prestazioni nei sistemi di realtà virtuale, ottenere una visualizzazione più corretta delle scene su sistemi multi-monitor e introdurre nuove tecniche di ottimizzazione delle prestazioni. Ma le applicazioni VR riceveranno il maggiore aumento di velocità quando supporteranno la tecnologia multi-proiezione, che aiuta a risparmiare la metà delle risorse della GPU durante l'elaborazione dei dati geometrici e di una volta e mezza quando si eseguono calcoli pixel per pixel.

Tra le modifiche puramente software, spicca la piattaforma per la creazione di screenshot nei giochi chiamata Ansel: sarà interessante provarla non solo per chi gioca molto, ma anche per chi è semplicemente interessato alla grafica 3D di alta qualità. Il nuovo prodotto ti consente di portare l'arte di creare e ritoccare screenshot a un nuovo livello. Ebbene, Nvidia continua semplicemente a migliorare passo dopo passo i suoi pacchetti per sviluppatori di giochi, come GameWorks e VRWorks: ad esempio, quest'ultimo ha una caratteristica interessante per l'elaborazione del suono di alta qualità, tenendo conto delle numerose riflessioni delle onde sonore utilizzando i raggi hardware tracciamento.

In generale, un vero leader è entrato nel mercato sotto forma della scheda video Nvidia GeForce GTX 1080, dotata di tutte le qualità necessarie per questo: prestazioni elevate e ampia funzionalità, nonché supporto per nuove funzionalità e algoritmi. I primi acquirenti di questa scheda video potranno apprezzare immediatamente molti dei vantaggi menzionati, e altre possibilità della soluzione verranno rivelate un po' più tardi, quando apparirà un ampio supporto software. La cosa principale è che la GeForce GTX 1080 si è rivelata molto veloce ed efficiente e speriamo davvero che gli ingegneri Nvidia siano riusciti a risolvere alcune aree problematiche (gli stessi calcoli asincroni).

Acceleratore grafico GeForce GTX 1070

| Parametro | Senso |

|---|---|

| Nome del codice del chip | GP104 |

| Tecnologia di produzione | FinFET da 16 nm |

| Numero di transistor | 7,2 miliardi |

| Area centrale | 314 mm² |

| Architettura | Unificato, con una serie di processori comuni per l'elaborazione del flusso di numerosi tipi di dati: vertici, pixel, ecc. |

| Supporto hardware DirectX | DirectX 12, con supporto per Feature Level 12_1 |

| Bus della memoria | 256 bit: otto controller di memoria indipendenti a 32 bit che supportano la memoria GDDR5 e GDDR5X |

| Frequenza della GPU | 1506 (1683) MHz |

| Blocchi di calcolo | 15 multiprocessori streaming attivi (su 20 nel chip), di cui 1920 (su 2560) ALU scalari per calcoli in virgola mobile nell'ambito dello standard IEEE 754-2008; |

| Blocchi testurizzati | 120 unità attive di indirizzamento e filtraggio delle texture (su 160 sul chip) con supporto per i componenti FP16 e FP32 nelle texture e supporto per il filtraggio trilineare e anisotropico per tutti i formati di texture |

| Blocchi operativi raster (ROP) | 8 blocchi ROP larghi (64 pixel) con supporto per varie modalità anti-aliasing, incluso programmabile e con formato frame buffer FP16 o FP32. I blocchi sono costituiti da una serie di ALU configurabili e sono responsabili della generazione e del confronto della profondità, del multisampling e del blending |

| Monitorare il supporto | Supporto integrato per un massimo di quattro monitor collegati tramite interfacce Dual Link DVI, HDMI 2.0b e DisplayPort 1.2 (1.3/1.4 Ready) |

| Specifiche della scheda video di riferimento GeForce GTX 1070 | |

|---|---|

| Parametro | Senso |

| Frequenza centrale | 1506 (1683) MHz |

| Numero di processori universali | 1920 |

| Numero di blocchi di trama | 120 |

| Numero di blocchi di fusione | 64 |

| Frequenza di memoria effettiva | 8000 (4×2000) MHz |

| Tipo di memoria | GDDR5 |

| Bus della memoria | 256 bit |

| Memoria | 8GB |

| Banda di memoria | 256GB/s |

| Prestazioni di calcolo (FP32) | circa 6,5 teraflop |

| Tasso di riempimento massimo teorico | 96 gigapixel/s |

| Frequenza di campionamento teorica della trama | 181 gigatexel/s |

| Pneumatico | PCI Express 3.0 |

| Connettori | Un Dual Link DVI, un HDMI e tre DisplayPort |

| Consumo di energia | fino a 150 W |

| Cibo aggiuntivo | Un connettore a 8 pin |

| Numero di slot occupati nel case del sistema | 2 |

| Prezzo consigliato | $ 379-449 (Stati Uniti), 34.990 (Russia) |

Anche la scheda video GeForce GTX 1070 ha ricevuto un nome logico, simile alla stessa soluzione della precedente serie GeForce. Si differenzia dal suo diretto predecessore GeForce GTX 970 solo per il numero di generazione modificato. Il nuovo prodotto nell'attuale linea dell'azienda è un gradino inferiore rispetto all'attuale soluzione di fascia alta GeForce GTX 1080, che è diventata il fiore all'occhiello temporaneo della nuova serie fino al rilascio di soluzioni su GPU di potenza ancora maggiore.

I prezzi consigliati per la nuova scheda grafica di fascia alta di Nvidia sono $ 379 e $ 449 rispettivamente per le versioni regolari dei partner Nvidia e la speciale Founders Edition. Rispetto al modello di punta, si tratta di un prezzo molto buono considerando che la GTX 1070 è indietro di circa il 25% nel peggiore dei casi. E al momento dell'annuncio e del rilascio, la GTX 1070 diventa la migliore soluzione prestazionale della sua categoria. Come la GeForce GTX 1080, la GTX 1070 non ha concorrenti diretti di AMD, e può essere paragonata solo alla Radeon R9 390X e al Fury.

Il processore grafico GP104 nella modifica GeForce GTX 1070 ha deciso di lasciare un bus di memoria completo a 256 bit, sebbene non abbia utilizzato il nuovo tipo di memoria GDDR5X, ma la velocissima GDDR5, che funziona ad un'elevata frequenza effettiva di 8 GHz. La quantità di memoria installata su una scheda video con tale bus può essere di 4 o 8 GB e per garantire le massime prestazioni della nuova soluzione con impostazioni e risoluzioni di rendering elevate, il modello di scheda video GeForce GTX 1070 era dotato anche di 8 GB di memoria memoria video, come la sua sorella maggiore. Questo volume è sufficiente per eseguire qualsiasi applicazione 3D con impostazioni di massima qualità per diversi anni.

Edizione speciale GeForce GTX 1070 Founders Edition

Quando all'inizio di maggio è stata annunciata la GeForce GTX 1080, è stata annunciata un'edizione speciale della scheda video chiamata Founders Edition, che aveva un prezzo più alto rispetto alle normali schede video dei partner dell'azienda. Lo stesso vale per il nuovo prodotto. In questo articolo parleremo ancora di un'edizione speciale della scheda video GeForce GTX 1070 chiamata Founders Edition. Come per il modello precedente, Nvidia ha deciso di rilasciare questa versione della scheda video di riferimento del produttore ad un prezzo più alto. Sostengono che molti giocatori e appassionati che acquistano schede grafiche costose e di fascia alta desiderano un prodotto con un aspetto e una sensazione adeguatamente "premium".

Di conseguenza, è per tali utenti che verrà lanciata sul mercato la scheda video GeForce GTX 1070 Founders Edition, progettata e realizzata dagli ingegneri Nvidia con materiali e componenti di prima qualità, come anche la copertura in alluminio della GeForce GTX 1070 Founders Edition. come piastra posteriore a basso profilo che copre il retro del circuito stampato ed è molto popolare tra gli appassionati.