Ethernet nonostante

nonostante tutto il suo successo, non è mai stato elegante.

Le schede di rete hanno solo rudimentali

il concetto di intelligenza. Loro davvero

il pacchetto viene inviato per primo, e solo dopo

vedere se qualcun altro ha trasmesso i dati

allo stesso tempo con loro. Qualcuno ha paragonato Ethernet a

una società in cui le persone possono comunicare

l'uno con l'altro solo quando tutti urlano

contemporaneamente.

Come lui

predecessore, Fast Ethernet utilizza il metodo

CSMACD (Carrier Sense Multiple Access con

Rilevamento delle collisioni - Ambiente ad accesso multiplo con

rilevamento della portante e rilevamento delle collisioni).

Dietro questo lungo e oscuro acronimo

nasconde una tecnologia molto semplice. quando

la scheda Ethernet dovrebbe inviare un messaggio, quindi

prima aspetta il silenzio, poi

invia un pacchetto e ascolta allo stesso tempo, no

qualcuno ha mandato un messaggio

contemporaneamente a lui. Se questo è successo, allora

entrambi i pacchetti non raggiungono la destinazione. Se una

non c'è stata alcuna collisione e il tabellone dovrebbe continuare

trasmettere i dati, attende ancora

qualche microsecondo prima ancora

proverà a inviare una nuova porzione. esso

fatto in modo che anche altre schede

potrebbe funzionare e nessuno potrebbe catturare

monopolio del canale. In caso di collisione, entrambi

i dispositivi restano silenziosi per un breve periodo

intervallo di tempo generato

a caso e poi prendere

un nuovo tentativo di trasferire i dati.

A causa di collisioni

Ethernet né Fast Ethernet possono mai raggiungere

la sua massima resa 10

o 100 Mbps. Non appena inizia

aumentare il traffico di rete, temporaneo

ritardi tra l'invio di singoli pacchetti

sono ridotti e il numero di collisioni

aumenta. Vero

Le prestazioni Ethernet non possono superare

70% del suo potenziale rendimento

capacità, e può essere anche inferiore se la linea

gravemente sovraccarico.

Utilizza Ethernet

la dimensione del pacchetto è di 1516 byte, il che va bene

adatto quando è stato creato.

Oggi è considerato uno svantaggio quando

Ethernet viene utilizzata per la comunicazione

server, poiché server e linee di comunicazione

tendono a scambiare

il numero di piccoli pacchetti che

sovraccarica la rete. Inoltre, Fast Ethernet

impone un limite alla distanza tra

dispositivi collegati - non più di 100

metri e ti fa vedere

attenzione extra quando

progettare tali reti.

All'inizio, Ethernet lo era

progettato sulla base della topologia del bus,

quando tutti i dispositivi sono collegati a un comune

cavo, sottile o spesso. Applicazione

il doppino intrecciato ha modificato solo in parte il protocollo.

Quando si utilizza un cavo coassiale

la collisione è stata determinata immediatamente da tutti

stazioni. Nel caso di doppino

usa il segnale "jam" non appena

la stazione rileva una collisione, quindi

invia un segnale all'hub, quest'ultimo in

a sua volta invia "jam" a tutti

dispositivi ad esso collegati.

Per

ridurre la congestione, reti Ethernet

suddiviso in segmenti che

collegato con ponti e

router. Questo ti permette di trasferire

solo il traffico necessario tra i segmenti.

Un messaggio inviato tra due

le stazioni nello stesso segmento non lo faranno

trasferito a un altro e non sarà in grado di chiamarlo

sovraccarico.

Oggi alle

costruzione dell'autostrada centrale,

utilizzo dei server di pooling

Ethernet commutata. Gli switch Ethernet possono

considerarsi ad alta velocità

bridge multiporta in grado di farlo

determinare autonomamente quale

porte a cui è indirizzato il pacchetto. Interruttore

esamina le intestazioni dei pacchetti e

compila una tabella che definisce

dov'è questo o quell'abbonato con tale

indirizzo fisico. Questo permette

limitare la portata di un pacchetto

e ridurre la possibilità di overflow,

inviandolo solo alla porta giusta. Solo

i pacchetti di trasmissione vengono inviati

tutti i porti.

100BaseT

- fratello maggiore 10BaseT

idea tecnologica

Fast Ethernet nasce nel 1992. in agosto

gruppo di produttori del prossimo anno

fusa nella Fast Ethernet Alliance (FEA).

L'obiettivo della FEA era quello di ottenere

approvazione formale di Fast Ethernet da parte del comitato

802.3 Istituto di Ingegneri Elettrici e

radioelettronica (Istituto di Elettricità ed Elettronica

Ingegneri, IEEE), poiché questo particolare comitato

si occupa di standard per Ethernet. Fortuna

accompagnato da nuove tecnologie e

alleanza di supporto: nel giugno 1995

tutte le procedure formali sono state completate e

Le tecnologie Fast Ethernet sono state nominate

802.3u.

Con una mano leggera IEEE

Fast Ethernet si chiama 100BaseT. Questo è spiegato

semplice: 100BaseT è un'estensione

Standard 10BaseT con larghezza di banda da

Da 10 Mbps a 100 Mbps. Lo standard 100BaseT include

include un protocollo per la gestione di più

accesso di rilevamento del vettore e

Rilevamento di conflitti CSMA/CD (Carrier Sense Multiple).

Access with Collision Detection), utilizzato anche in

10BaseT. Inoltre, Fast Ethernet può funzionare

cavi di vario tipo, compresi

doppino. Entrambe queste proprietà del nuovo

gli standard sono molto importanti per il potenziale

clienti, ed è grazie a loro che 100BaseT

risulta essere un modo efficace per migrare le reti

basato su 10BaseT.

capo

business case per 100BaseT

è su cui si basa Fast Ethernet

tecnologia legacy. Dal momento che in Fast Ethernet

viene utilizzato lo stesso protocollo di trasferimento

messaggi, come nelle versioni precedenti di Ethernet, e

sistemi di cavi di questi standard

compatibile, per il passaggio a 100BaseT da 10BaseT

necessario

più piccola

investimento di capitale che per l'installazione

altri tipi di reti ad alta velocità. Tranne

Inoltre, poiché 100BaseT è

continuazione del vecchio standard Ethernet, all

strumenti e procedure

analisi delle prestazioni della rete, così come tutto

software in esecuzione

le vecchie reti Ethernet dovrebbero rientrare in questo standard

continuare a lavorare.

Quindi l'ambiente 100BaseT sarà familiare

amministratori di rete con esperienza

con Ethernet. Ciò significa che sarà necessaria la formazione del personale

meno tempo e costi in modo significativo

più economico.

PRESERVAZIONE

PROTOCOLLO

Forse,

il più grande vantaggio pratico del nuovo

la tecnologia ha portato la decisione di andarsene

protocollo di passaggio messaggi invariato.

Protocollo di passaggio messaggi, nel nostro caso

CSMA/CD definisce il modo in cui i dati

trasmesso in rete da un nodo all'altro

attraverso il sistema di cavi. Nel modello ISO/OSI

il protocollo CSMA/CD fa parte del livello

controllo dell'accesso ai media (MAC).

Questo livello definisce il formato

quali informazioni vengono trasmesse sulla rete e

il modo in cui un dispositivo di rete riceve

accesso alla rete (o gestione della rete) per

trasmissione dati.

Nome CSMA/CD

può essere diviso in due parti: Carrier Sense Multiple Access

e rilevamento delle collisioni. Dalla prima parte del nome

concludere come un nodo con una rete

adattatore determina il momento in cui esso

dovrebbe essere inviato un messaggio. Secondo

Protocollo CSMA, il nodo di rete per primo "ascolta"

rete per determinare se viene trasmessa

attualmente qualsiasi altro messaggio.

Se si sente un tono di portante (tono di portante),

significa che la rete è occupata al momento

messaggio - il nodo di rete passa alla modalità

in attesa e rimane in esso fino alla rete

sarà rilasciato. Quando arriva la rete

silenzio, il nodo inizia a trasmettere.

Infatti, i dati vengono inviati a tutti i nodi

rete o segmento, ma sono accettati solo da quelli

nodo a cui sono indirizzati.

Rilevamento collisione-

la seconda parte del nome serve per risolvere

situazioni in cui due o più nodi tentano di farlo

inviare messaggi contemporaneamente.

Secondo il protocollo CSMA, ognuno pronto per

trasmissione, il nodo deve prima ascoltare la rete,

per determinare se è libera. Tuttavia,

se due nodi sono in ascolto contemporaneamente,

entrambi decideranno che la rete è libera e si avvierà

inviare i loro pacchetti allo stesso tempo. In questo

situazioni dati trasmessi

sovrapposti (rete

gli ingegneri chiamano questo conflitto) e nessuno

dai messaggi non arriva al punto

destinazione. Il rilevamento delle collisioni richiede che il nodo

ascoltato la rete anche dopo la trasmissione

pacchetto. Se viene trovato un conflitto, allora

il nodo ripete la trasmissione in modo casuale

un periodo di tempo prescelto e

controlla di nuovo per vedere se si è verificato un conflitto.

TRE TIPI DI ETHERNET VELOCE

Insieme a

conservazione del protocollo CSMA/CD, altro importante

la soluzione era progettare 100BaseT in questo modo

in modo tale da poter essere applicato

cavi di diversi tipi - come quelli

utilizzato nelle versioni precedenti di Ethernet e

modelli più recenti. La norma ne definisce tre

modifiche per garantire il lavoro con

diversi tipi di cavi Fast Ethernet: 100BaseTX, 100BaseT4

e 100BaseFX. Vengono calcolate le modifiche 100BaseTX e 100BaseT4

su doppino intrecciato, mentre 100BaseFX è stato progettato per

cavo ottico.

Standard 100BaseTX

richiede l'uso di due coppie di UTP o STP. Uno

una coppia viene utilizzata per la trasmissione, l'altra per

ricezione. Questi requisiti sono soddisfatti da due

standard del cavo principale: EIA/TIA-568 UTP

Categoria 5 e Tipo 1 STP di IBM. A 100BaseTX

disposizione attraente

modalità full duplex quando si lavora con

server di rete, nonché l'utilizzo

solo due delle quattro coppie di otto core

cavi - rimangono le altre due coppie

gratuito e può essere utilizzato in

ulteriormente per ampliare le possibilità

reti.

Tuttavia, se tu

funzioneranno con 100BaseTX utilizzando

questo cablaggio di categoria 5, dovresti

essere consapevoli dei suoi difetti. Questo cavo

più costoso di altri cavi a otto conduttori (ad es

Categorie 3). Inoltre, con cui lavorare

richiede l'uso di blocchi punchdown (punchdown

blocchi), connettori e patch panel,

soddisfare i requisiti della categoria 5.

Va aggiunto che per supportare

dovrebbe essere la modalità full duplex

installare switch full duplex.

Standard 100BaseT4

ha requisiti più clementi per

il cavo utilizzato. Il motivo è

il fatto che utilizza 100BaseT4

tutte e quattro le coppie di cavi a otto conduttori: uno

per trasmettere, l'altro per ricevere, e

i restanti due funzionano come una trasmissione,

così come per l'accoglienza. Quindi in 100BaseT4 e ricevi,

e la trasmissione dei dati può essere effettuata da

tre coppie. Espandendo 100 Mbps in tre coppie,

100BaseT4 riduce la frequenza del segnale, quindi

perché la sua trasmissione è abbastanza e meno

cavo di alta qualità. Per l'attuazione

Reti 100BaseT4, UTP Categoria 3 e

5, nonché UTP Categoria 5 e STP Tipo 1.

Vantaggio

100BaseT4 è meno rigido

requisiti di cablaggio. Categoria 3 e

4 sono più comuni e, inoltre, loro

Significativamente più economico dei cavi

Categorie 5 cose da tenere a mente prima

inizio lavori di installazione. Svantaggi

sono che 100BaseT4 ha bisogno di tutti e quattro

coppie e cos'è la modalità full duplex da questo

il protocollo non è supportato.

Fast Ethernet include

standard anche per il funzionamento multimodale

fibra ottica con anima da 62,5 micron e 125 micron

guscio. Lo standard 100BaseFX è focalizzato

principalmente in autostrada - per collegamento

Ripetitori Fast Ethernet all'interno di uno

costruzione. Benefici tradizionali

i cavi ottici sono intrinseci e standard

100BaseFX: immunità elettromagnetica

rumore, protezione dei dati migliorata e di grandi dimensioni

distanze tra i dispositivi di rete.

CORRIDORE

A BREVE DISTANZA

Sebbene Fast Ethernet e

è una continuazione dello standard Ethernet,

il passaggio da una rete 10BaseT a una rete 100BaseT non è possibile

essere considerato un sostituto meccanico

attrezzatura - per questo possono

sono necessarie modifiche alla topologia di rete.

Teorico

Limite del diametro del segmento Fast Ethernet

è di 250 metri; sono solo 10

percentuale del limite di dimensione teorica

Reti Ethernet (2500 metri). Questa restrizione

deriva dalla natura del protocollo CSMA/CD e

velocità di trasmissione di 100Mbps.

Cosa già

notato in precedenza, trasmissione di dati

workstation dovrebbe essere in ascolto sulla rete in

periodo di tempo per essere sicuri

che i dati hanno raggiunto la stazione di destinazione.

Su una rete Ethernet con una larghezza di banda di 10

intervallo di tempo Mbps (ad esempio 10Base5),

postazione di lavoro necessaria per

ascoltando la rete per un conflitto,

determinato dalla distanza di 512 bit

frame (dimensione del frame specificata nello standard Ethernet)

passerà durante l'elaborazione di questo frame

postazione di lavoro. Per una rete Ethernet con larghezza di banda

con una capacità di 10 Mbps, questa distanza è uguale a

2500 metri.

D'altro canto,

lo stesso frame a 512 bit (standard 802.3u

specifica un frame della stessa dimensione di 802.3, quindi

è a 512 bit) trasmessa dalla lavorazione

stazione in rete Fast Ethernet, a soli 250 m,

prima che la workstation lo completi

in lavorazione. Se la stazione ricevente fosse

lontano dalla stazione trasmittente di

distanza superiore a 250 m, quindi il telaio potrebbe

entrare in conflitto con un altro fotogramma acceso

linee da qualche parte più lontano e la trasmissione

stazione, terminata la trasmissione, non c'è più

accetta questo conflitto. Ecco perchè

il diametro massimo di una rete 100BaseT è

250 metri.

Per

utilizzare la distanza consentita,

sono necessari due ripetitori per la connessione

tutti i nodi. Secondo la norma,

distanza massima tra nodo e

il ripetitore è di 100 metri; in ethernet veloce,

come in 10BaseT, la distanza tra

hub e workstation

deve superare i 100 metri. Perché il

dispositivi di connessione (ripetitori)

introdurre ulteriori ritardi, il reale

distanza di lavoro tra i nodi

essere ancora più piccolo. Ecco perchè

sembra ragionevole prendere tutto

distanze con un certo margine.

Lavorare su

le lunghe distanze dovranno acquistare

cavo ottico. Ad esempio, l'attrezzatura

Consente 100BaseFX in modalità half duplex

collegare un interruttore a un altro interruttore

o stazione terminale situata su

fino a 450 metri di distanza.

Installando 100BaseFX full duplex, è possibile

collegare due dispositivi di rete

distanza fino a due chilometri.

COME

INSTALLA 100BASET

Oltre ai cavi,

di cui abbiamo già parlato, per installare Fast

Ethernet richiede adattatori di rete per

workstation e server, hub

100BaseT e forse alcuni

Switch 100BaseT.

adattatori,

necessario per organizzare una rete 100BaseT,

sono chiamati adattatori Ethernet 10/100 Mbps.

Questi adattatori sono in grado (questo è un requisito

100BaseT standard) distinguono indipendentemente 10

Mbps da 100 Mbps. Per servire un gruppo

server e workstation trasferiti

100BaseT, avrai anche bisogno di un hub 100BaseT.

Quando acceso

server o personal computer Insieme a

adattatore 10/100 quest'ultimo dà un segnale,

annunciando che può fornire

larghezza di banda 100Mbps. Se una

stazione ricevente (molto probabilmente

sarà un hub) è anche progettato per

funziona con 100BaseT, emetterà un segnale in risposta, secondo

a cui sia l'hub che il PC o il server

passa automaticamente alla modalità 100BaseT. Se una

hub funziona solo con 10BaseT, non lo fa

restituisce un segnale e il PC o il server

passerà automaticamente alla modalità 10BaseT.

quando

le configurazioni 100BaseT su piccola scala possono

applica un bridge 10/100 o cambialo

fornirà la comunicazione per la parte della rete con cui lavora

100BaseT, con rete esistente

10BaseT.

ingannevole

RAPIDITÀ

Riassumendo tutto

sopra, notiamo che, come ci sembra,

Fast Ethernet è il migliore per la risoluzione dei problemi

carichi di punta elevati. Ad esempio, se

uno degli utenti lavora con CAD o

programmi di elaborazione delle immagini e

ha bisogno di aumentare la produttività

capacità, Fast Ethernet potrebbe essere

buona via d'uscita. Tuttavia, se

i problemi sono causati dall'eccesso

utenti sulla rete, quindi viene avviato 100BaseT

rallentare lo scambio di informazioni di circa il 50 per cento

carico di rete - in altre parole, sullo stesso

livello come 10BaseT. Ma alla fine lo è

non è altro che un'estensione.

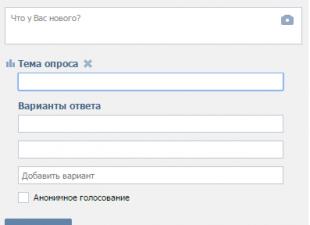

Oggi è quasi impossibile trovare un laptop o una scheda madre in vendita senza una scheda di rete integrata, o anche due. Tutti hanno un connettore: RJ45 (più precisamente, 8P8C), ma la velocità del controller può differire di un ordine di grandezza. Nei modelli economici, questo è 100 megabit al secondo (Fast Ethernet), in quelli più costosi - 1000 (Gigabit Ethernet).

Se il tuo computer non ha un controller LAN integrato, molto probabilmente è già un "vecchio" basato su un processore Intel Pentium 4 o AMD Athlon XP, così come i loro "antenati". Tali "dinosauri" possono essere "amici" con una rete cablata solo installando una scheda di rete discreta con un connettore PCI, poiché bus PCI Express non esisteva al momento in cui sono nati. Ma anche per il bus PCI (33 MHz), vengono prodotte “schede di rete” che supportano lo standard Gigabit Ethernet più attuale, sebbene la sua larghezza di banda potrebbe non essere sufficiente per sbloccare completamente il potenziale di velocità di un controller gigabit.

Ma anche nel caso di una scheda di rete integrata da 100 megabit, un adattatore discreto dovrà essere acquistato da chi intende "aggiornare" a 1000 megabit. L'opzione migliore sarà l'acquisto di un controller PCI Express, che fornirà la massima velocità di rete, a meno che, ovviamente, il connettore corrispondente non sia presente nel computer. È vero, molti daranno la preferenza a una scheda PCI, poiché sono molto più economiche (il costo parte da soli 200 rubli).

Quali sono i vantaggi pratici del passaggio da Fast Ethernet a Gigabit Ethernet? Quanto è diversa la velocità di trasferimento dati reale delle versioni PCI delle schede di rete e PCI Express? La velocità normale è sufficiente? disco rigido caricare completamente un canale gigabit? Troverai le risposte a queste domande in questo materiale.

Partecipanti alla prova

Tre delle schede di rete discrete più economiche (PCI - Fast Ethernet, PCI - Gigabit Ethernet, PCI Express - Gigabit Ethernet) sono state selezionate per il test, poiché sono le più richieste.

Una scheda di rete PCI da 100 megabit è rappresentata dal modello Acorp L-100S (il prezzo parte da 110 rubli), che utilizza il chipset Realtek RTL8139D, il più popolare per le schede economiche.

La scheda di rete PCI da 1000 megabit è rappresentata dal modello Acorp L-1000S (il prezzo parte da 210 rubli), che si basa sul chip Realtek RTL8169SC. Questa è l'unica scheda con un dissipatore di calore sul chipset: il resto dei partecipanti al test non ha bisogno di ulteriore raffreddamento.

La scheda di rete PCI Express da 1000 megabit è rappresentata dal modello TP-LINK TG-3468 (il prezzo parte da 340 rubli). E non ha fatto eccezione: si basa sul chipset RTL8168B, anch'esso prodotto da Realtek.

L'aspetto della scheda di rete

I chipset di queste famiglie (RTL8139, RTL816X) possono essere visti non solo su schede di rete discrete, ma anche integrati su molte schede madri.

Le caratteristiche di tutti e tre i controller sono riportate nella tabella seguente:

Mostra tabella

La larghezza di banda del bus PCI (1066 Mbps) dovrebbe in teoria essere sufficiente per potenziare le schede di rete gigabit alla massima velocità, ma in pratica potrebbe non essere ancora sufficiente. Il fatto è che questo “canale” è condiviso da tutti i dispositivi PCI; attraverso di esso vengono inoltre trasmesse informazioni di servizio sulla manutenzione del bus stesso. Vediamo se questa ipotesi è confermata da una misura di velocità reale.

Un'altra sfumatura: la stragrande maggioranza dei moderni dischi rigidi ha una velocità di lettura media non superiore a 100 megabyte al secondo, e spesso anche inferiore. Di conseguenza, non saranno in grado di caricare completamente il canale gigabit della scheda di rete, la cui velocità è di 125 megabyte al secondo (1000: 8 = 125). Ci sono due modi per aggirare questa limitazione. Il primo consiste nel combinare una coppia di tali dischi rigidi in un array RAID (RAID 0, striping), mentre la velocità può quasi raddoppiare. Il secondo è utilizzare unità SSD, i cui parametri di velocità sono notevolmente superiori a quelli dei dischi rigidi.

Test

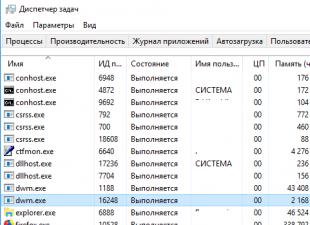

Come server è stato utilizzato il computer con la seguente configurazione:

- processore: AMD Phenom II X4 955 3200 MHz (quad-core);

- scheda madre: ASRock A770DE AM2+ ( Chipset AMD 770 + AMD SB700);

- RAM: Hynix DDR2 4 x 2048 GB PC2 8500 1066 MHz (doppio canale);

- scheda video: AMD Radeon HD 4890 1024 MB DDR5 PCI Express 2.0;

- scheda di rete: Realtek RTL8111DL 1000 Mbps (integrata sulla scheda madre);

- sistema operativo: Microsoft Windows 7 Home Premium SP1 (versione a 64 bit).

Come client, in cui sono state installate le schede di rete testate, è stato utilizzato un computer con la seguente configurazione:

- processore: AMD Athlon 7850 2800 MHz (dual-core);

- scheda madre: MSI K9A2GM V2 (MS-7302, AMD RS780 + AMD SB700 chipset);

- RAM: Hynix DDR2 2 x 2048 GB PC2 8500 1066 MHz (doppio canale);

- scheda video: AMD Radeon HD 3100 256 MB (integrata nel chipset);

- disco rigido: Seagate 7200.10 160 GB SATA2;

- sistema operativo: Microsoft Windows XP Home SP3 (versione a 32 bit).

Il test è stato effettuato in due modalità: lettura e scrittura tramite una connessione di rete da dischi rigidi (questo dovrebbe mostrare che possono essere un "collo di bottiglia"), nonché da dischi RAM nella RAM di computer che simulano unità SSD veloci. Le schede di rete sono state collegate direttamente utilizzando un cavo patch di tre metri (doppino intrecciato a otto core, categoria 5e).

Velocità di trasferimento dati (disco rigido - disco rigido, Mbps)

La velocità reale di trasferimento dei dati attraverso la scheda di rete Acorp L-100S da 100 megabit non ha raggiunto il massimo teorico. Ma entrambe le gigabit, sebbene abbiano superato la prima di circa sei volte, non sono riuscite a mostrare la massima velocità possibile. È perfettamente chiaro che la velocità "poggiava" sulle prestazioni dei dischi rigidi Seagate 7200.10, che, se testati direttamente su un computer, raggiungono una media di 79 megabyte al secondo (632 Mbps).

Non vi è alcuna differenza fondamentale di velocità tra le schede di rete per il bus PCI (Acorp L-1000S) e PCI Express (TP-LINK) in questo caso, il leggero vantaggio di quest'ultime può essere spiegato dall'errore di misura. Entrambi i controller funzionavano a circa il sessanta percento della loro capacità.

Velocità di trasferimento dati (disco RAM - disco RAM, Mbps)

Acorp L-100S, come previsto, ha mostrato la stessa bassa velocità durante la copia di dati da dischi RAM ad alta velocità. È comprensibile: lo standard Fast Ethernet ha smesso da tempo di corrispondere alle realtà moderne. Rispetto alla modalità di test "disco rigido - disco rigido", la scheda PCI Gigabit Acorp L-1000S ha notevolmente aumentato le prestazioni: il vantaggio è stato di circa il 36%. Un vantaggio ancora più impressionante è stato dimostrato dalla scheda di rete TP-LINK TG-3468: l'aumento è stato di circa il 55%.

È qui che è emersa la maggiore larghezza di banda del bus PCI Express: ha superato del 14% le prestazioni dell'Acorp L-1000S, il che non può più essere attribuito a un errore. Il vincitore è un po' al di sotto del massimo teorico, ma la velocità di 916 megabit al secondo (114,5 Mb / s) sembra comunque impressionante - questo significa che dovrai aspettare quasi un ordine di grandezza in meno per la fine della copia (rispetto a Fast Ethernet). Ad esempio, il tempo per copiare un file da 25 GB (un tipico rip HD con una buona qualità) da un computer all'altro sarà inferiore a quattro minuti e con l'adattatore di generazione precedente più di mezz'ora.

I test hanno dimostrato che le schede di rete Gigabit Ethernet hanno un enorme vantaggio (fino a dieci volte) rispetto ai controller Fast Ethernet. Se i tuoi computer hanno solo dischi rigidi che non sono combinati in un array con striping (RAID 0), non ci saranno differenze fondamentali di velocità tra le schede PCI e PCI Express. In caso contrario, e anche quando si utilizzano SSD ad alte prestazioni, è opportuno privilegiare le schede con interfaccia PCI Express, che forniranno la massima velocità di trasferimento dati possibile.

Naturalmente va tenuto presente che gli altri dispositivi presenti nel “percorso” di rete (switch, router...) devono supportare lo standard Gigabit Ethernet, e la categoria del doppino intrecciato (patch cord) deve essere almeno 5e. In caso contrario, la velocità reale rimarrà al livello di 100 megabit al secondo. A proposito, rimane la retrocompatibilità con lo standard Fast Ethernet: puoi collegare, ad esempio, un laptop con una scheda di rete da 100 megabit a una rete gigabit, ciò non influirà sulla velocità degli altri computer della rete.

La rete Ethernet è la più diffusa tra le reti standard. È apparso per la prima volta nel 1972 (lo sviluppatore era la nota azienda Xerox). La rete si è rivelata un discreto successo e, di conseguenza, grandi aziende come DEC e Intel l'hanno supportata nel 1980 (l'associazione di queste società si chiamava DIX dopo le prime lettere dei loro nomi). Grazie ai loro sforzi, nel 1985, la rete Ethernet è diventata uno standard internazionale, è stata accettata dalle più grandi organizzazioni internazionali di standardizzazione: il comitato 802 dell'IEEE (Institute of Electrical and Electronic Engineers) e ECMA (European Computer Manufacturers Association).

Lo standard si chiama IEEE 802.3 (letto in inglese come otto o due punti tre). Definisce l'accesso monocanale multiplo di tipo bus con rilevamento delle collisioni e controllo della trasmissione, ovvero con il già citato metodo di accesso CSMA/CD. Anche alcune altre reti hanno soddisfatto questo standard, poiché il livello di dettaglio non è elevato. Di conseguenza, le reti IEEE 802.3 erano spesso incompatibili tra loro sia in termini di design che di caratteristiche elettriche. Recentemente, tuttavia, lo standard IEEE 802.3 è stato considerato lo standard di rete Ethernet.

Caratteristiche principali dello standard IEEE 802.3 originale:

- topologia - autobus;

- mezzo di trasmissione - cavo coassiale;

- velocità di trasmissione - 10 Mbps;

- la lunghezza massima della rete è di 5 km;

- numero massimo di iscritti - fino a 1024;

- lunghezza del segmento di rete - fino a 500 m;

- il numero di abbonati su un segmento - fino a 100;

- metodo di accesso - CSMA/CD;

- la trasmissione è a banda stretta, cioè senza modulazione (monocanale).

A rigor di termini, ci sono piccole differenze tra gli standard IEEE 802.3 ed Ethernet, ma di solito vengono ignorate.

La rete Ethernet è oggi la più diffusa al mondo (oltre il 90% del mercato), presumibilmente lo resterà nei prossimi anni. Ciò è stato in gran parte facilitato dal fatto che fin dall'inizio le caratteristiche, i parametri, i protocolli della rete erano aperti, per cui un numero enorme di produttori in tutto il mondo ha iniziato a produrre apparecchiature Ethernet completamente compatibili tra loro .

In una classica rete Ethernet è stato utilizzato un cavo coassiale da 50 ohm di due tipi (spesso e sottile). Tuttavia, recentemente (dall'inizio degli anni '90), la versione più utilizzata di Ethernet, che utilizza doppini intrecciati come mezzo di trasmissione. È stato inoltre definito uno standard da utilizzare in una rete di cavi in fibra ottica. Sono state apportate le aggiunte appropriate allo standard IEEE 802.3 originale per accogliere queste modifiche. Nel 1995, è apparso uno standard aggiuntivo per una versione più veloce di Ethernet funzionante a una velocità di 100 Mbps (il cosiddetto Fast Ethernet, standard IEEE 802.3u), utilizzando doppino intrecciato o cavo in fibra ottica come mezzo di trasmissione. Nel 1997 è apparsa una versione per una velocità di 1000 Mbit / s (Gigabit Ethernet, standard IEEE 802.3z).

Oltre alla topologia bus standard, vengono sempre più utilizzate topologie passive a stella e ad albero passive. Ciò presuppone l'uso di ripetitori e hub ripetitori che collegano diverse parti (segmenti) della rete. Di conseguenza, una struttura ad albero può essere formata su segmenti di diverso tipo (Fig. 7.1).

Riso. 7.1. Topologia di rete Ethernet classica

Un bus classico o un singolo abbonato può fungere da segmento (parte della rete). Per i segmenti di bus viene utilizzato un cavo coassiale e per i raggi stellari passivi (per il collegamento a un unico hub di computer), vengono utilizzati doppini intrecciati e cavo in fibra ottica. Il requisito principale per la topologia risultante è che non ci siano percorsi chiusi (loop) al suo interno. In effetti, si scopre che tutti gli abbonati sono collegati a un bus fisico, poiché il segnale di ciascuno di essi si propaga in tutte le direzioni contemporaneamente e non torna indietro (come in un anello).

La lunghezza massima del cavo della rete nel suo insieme (il percorso massimo del segnale) può teoricamente raggiungere i 6,5 chilometri, ma praticamente non supera i 3,5 chilometri.

La rete Fast Ethernet non fornisce una topologia bus fisica, viene utilizzata solo una stella passiva o un albero passivo. Inoltre, Fast Ethernet ha requisiti molto più severi per la lunghezza massima della rete. Dopotutto, se la velocità di trasmissione viene aumentata di 10 volte e il formato del pacchetto viene preservato, la sua lunghezza minima diventa dieci volte inferiore. Pertanto, il valore consentito del tempo di transito del doppio segnale attraverso la rete viene ridotto di un fattore 10 (5,12 µs contro 51,2 µs in Ethernet).

Il codice Manchester standard viene utilizzato per trasmettere informazioni su una rete Ethernet.

L'accesso alla rete Ethernet avviene secondo il metodo random CSMA/CD, che garantisce l'uguaglianza degli abbonati. La rete utilizza pacchetti di lunghezza variabile con la struttura mostrata in Fig. 7.2. (i numeri mostrano il numero di byte)

Riso. 7.2. Struttura del pacchetto Ethernet

La lunghezza di un frame Ethernet (cioè un pacchetto senza preambolo) deve essere almeno a intervalli di 512 bit o 51,2 µs (questo è il doppio limite di tempo di transito nella rete). Fornisce indirizzamento individuale, di gruppo e broadcast.

Il pacchetto Ethernet contiene i seguenti campi:

- Il preambolo è composto da 8 byte, i primi sette sono il codice 10101010 e l'ultimo byte è il codice 10101011. Nello standard IEEE 802.3, l'ottavo byte è chiamato Start of Frame Delimiter (SFD) e forma un campo separato del pacchetto.

- Gli indirizzi del destinatario (ricevente) e del mittente (trasmettitore) includono 6 byte ciascuno e sono costruiti secondo lo standard descritto nella sezione Indirizzamento dei pacchetti della Lezione 4. Questi campi di indirizzi vengono elaborati dall'apparecchiatura dell'abbonato.

- Il campo di controllo (L/T - Lunghezza/Tipo) contiene informazioni sulla lunghezza del campo dati. Può anche specificare il tipo di protocollo utilizzato. È generalmente accettato che se il valore di questo campo non è maggiore di 1500, indica la lunghezza del campo dati. Se il suo valore è maggiore di 1500, determina il tipo di frame. Il campo di controllo viene elaborato a livello di codice.

- Il campo dati deve includere da 46 a 1500 byte di dati. Se il pacchetto deve contenere meno di 46 byte di dati, il campo dati viene riempito con byte di riempimento. Secondo lo standard IEEE 802.3, nella struttura del pacchetto viene allocato uno speciale campo di riempimento (dati pad), che può avere lunghezza zero quando ci sono dati sufficienti (più di 46 byte).

- Il campo checksum (FCS - Frame Check Sequence) contiene un checksum ciclico a 32 bit del pacchetto (CRC) e serve a verificare la corretta trasmissione del pacchetto.

Pertanto, la lunghezza minima del frame (pacchetto senza preambolo) è di 64 byte (512 bit). È questo valore che determina il ritardo di propagazione della doppia rete massimo consentito di intervalli di 512 bit (51,2 µs per Ethernet o 5,12 µs per Fast Ethernet). Lo standard presuppone che il preambolo possa diminuire quando il pacchetto passa attraverso vari dispositivi di rete, quindi non viene preso in considerazione. La lunghezza massima del frame è 1518 byte (12144 bit, ovvero 1214,4 µs per Ethernet, 121,44 µs per Fast Ethernet). Questo è importante per il dimensionamento. memoria tampone apparecchiature di rete e per valutare il carico complessivo della rete.

La scelta del formato del preambolo non è casuale. Il fatto è che la sequenza di uno e zero alternati (101010…10) nel codice Manchester è caratterizzata dal fatto che ha transizioni solo a metà di intervalli di bit (vedi Sezione 2.6.3), cioè solo transizioni informative . Naturalmente, è facile per il ricevitore sintonizzarsi (sincronizzarsi) con una tale sequenza, anche se per qualche motivo viene accorciata di pochi bit. Gli ultimi due singoli bit del preambolo (11) differiscono significativamente dalla sequenza 101010…10 (ci sono anche transizioni al confine degli intervalli di bit). Pertanto, un ricevitore già sintonizzato può selezionarli facilmente e quindi rilevare l'inizio di informazioni utili (inizio di un frame).

Per una rete Ethernet operante ad una velocità di 10 Mbit/s, lo standard definisce quattro tipologie principali di segmenti di rete orientati a vari mezzi di trasmissione delle informazioni:

- 10BASE5 (cavo coassiale spesso);

- 10BASE2 (cavo coassiale sottile);

- 10BASE-T (doppino);

- 10BASE-FL (cavo in fibra ottica).

Il nome del segmento comprende tre elementi: il numero 10 indica una velocità di trasmissione di 10 Mbit/s, la parola BASE - trasmissione nella banda di frequenza base (cioè senza modulazione del segnale ad alta frequenza), e l'ultimo elemento - il lunghezza del segmento consentita: 5 - 500 metri, 2 - 200 metri (più precisamente, 185 metri) o tipo di linea di comunicazione: T - twisted pair (dall'inglese twisted pair), F - cavo in fibra ottica (dall'inglese fiber optic ).

Allo stesso modo, per una rete Ethernet operante alla velocità di 100 Mbps (Fast Ethernet), lo standard definisce tre tipi di segmenti, che si differenziano per i tipi di mezzi di trasmissione:

- 100BASE-T4 (quadro doppino);

- 100BASE-TX (doppio doppino);

- 100BASE-FX (cavo in fibra ottica).

Qui, il numero 100 indica una velocità di trasmissione di 100 Mbps, la lettera T - doppino intrecciato, la lettera F - cavo in fibra ottica. I tipi 100BASE-TX e 100BASE-FX sono talvolta raggruppati insieme con il nome 100BASE-X e 100BASE-T4 e 100BASE-TX con il nome 100BASE-T.

Maggiori dettagli sulle caratteristiche dell'apparecchiatura Ethernet, nonché sull'algoritmo di controllo dello scambio CSMA/CD e sull'algoritmo per il calcolo del checksum ciclico (CRC) verranno ulteriormente approfonditi in apposite sezioni del corso. Qui va notato solo che la rete Ethernet non differisce né per le caratteristiche del record né per gli algoritmi ottimali, è inferiore in un numero di parametri ad altre reti standard. Ma grazie a un forte supporto, al più alto livello di standardizzazione, enormi volumi di produzione mezzi tecnici, Ethernet si distingue dalle altre reti standard, quindi è consuetudine confrontare qualsiasi altra tecnologia di rete con Ethernet.

Lo sviluppo della tecnologia Ethernet si sta allontanando sempre più dallo standard originale. L'uso di nuovi mezzi di trasmissione e switch può aumentare notevolmente le dimensioni della rete. L'eliminazione del codice Manchester (in Fast Ethernet e Gigabit Ethernet) offre velocità di trasferimento dati maggiori e requisiti di cavo ridotti. Il rifiuto del metodo di gestione CSMA/CD (con modalità di scambio full duplex) consente di aumentare notevolmente l'efficienza del lavoro e rimuovere le restrizioni sulla lunghezza della rete. Tuttavia, tutte le nuove varietà di rete vengono anche chiamate reti Ethernet.

Rete Token Ring

La rete Token-Ring (marker ring) è stata proposta da IBM nel 1985 (la prima versione è apparsa nel 1980). Aveva lo scopo di collegare in rete tutti i tipi di computer prodotti da IBM. Il fatto stesso che sia supportato da IBM, il più grande informatica, suggerisce che necessita di un'attenzione speciale. Ma altrettanto importante, Token-Ring è attualmente lo standard internazionale IEEE 802.5 (sebbene ci siano piccole differenze tra Token-Ring e IEEE 802.5). Si mette questa rete un livello per stato con Ethernet.

Token-Ring è stato sviluppato come alternativa affidabile a Ethernet. E sebbene Ethernet stia ora sostituendo tutte le altre reti, Token-Ring non può essere considerato irrimediabilmente obsoleto. Più di 10 milioni di computer in tutto il mondo sono collegati da questa rete.

IBM ha fatto di tutto per diffondere il più possibile la propria rete: è stata rilasciata una documentazione dettagliata fino ai diagrammi schematici degli adattatori. Di conseguenza, molte aziende, come 3COM, Novell, Western Digital, Proteon e altre, hanno iniziato a produrre adattatori. A proposito, il concetto di NetBIOS è stato sviluppato appositamente per questa rete, così come per un'altra rete di PC IBM. Se nella rete di PC creata in precedenza, i programmi NetBIOS erano archiviati nella memoria permanente incorporata nell'adattatore, nella rete Token-Ring era già utilizzato un programma di emulazione NetBIOS. Ciò ha consentito di rispondere in modo più flessibile alle funzionalità hardware e di mantenere la compatibilità con i programmi di livello superiore.

La rete Token-Ring ha una topologia ad anello, sebbene esternamente assomigli più a una stella. Ciò è dovuto al fatto che i singoli abbonati (computer) sono collegati alla rete non direttamente, ma tramite appositi hub o dispositivi di accesso multiplo (MSAU o MAU - Multistation Access Unit). Fisicamente, la rete forma una topologia ad anello a stella (Figura 7.3). In realtà, gli abbonati sono ancora uniti in un anello, ovvero ciascuno di essi trasmette informazioni a un abbonato vicino e riceve informazioni da un altro.

Riso. 7.3. Topologia di rete Star-Ring Token-Ring

Il concentratore (MAU) consente contemporaneamente di centralizzare la configurazione, la disconnessione degli abbonati difettosi, il controllo della rete, ecc. (Fig. 7.4). Non esegue alcun trattamento delle informazioni.

Riso. 7.4. Collegamento degli abbonati della rete Token-Ring in un anello tramite un concentratore (MAU)

Per ogni abbonato, come parte del concentratore, viene utilizzata una speciale Trunk Coupling Unit (TCU), che fornisce accensione automatica abbonato nell'anello, se è collegato all'hub e funziona. Se l'abbonato è disconnesso dall'hub o è difettoso, l'unità TCU ripristina automaticamente l'integrità dell'anello senza la partecipazione di questo abbonato. La TCU viene attivata da un segnale CC (la cosiddetta corrente phantom) che proviene da un abbonato che vuole unirsi all'anello. L'abbonato può anche disconnettersi dall'anello ed eseguire una procedura di autotest (l'abbonato più a destra in Fig. 7.4). La corrente fantasma non influisce in alcun modo sul segnale informativo, poiché il segnale nell'anello non ha una componente costante.

Strutturalmente, l'hub è un'unità autonoma con dieci connettori sul pannello frontale (Fig. 7.5).

Riso. 7.5. Hub Token Ring (8228 MAU)

Otto connettori centrali (1…8) sono destinati al collegamento di abbonati (computer) utilizzando cavi adattatori o cavi radiali. Due connettori estremi: l'ingresso RI (Ring In) e l'uscita RO (Ring Out) vengono utilizzati per il collegamento ad altri hub utilizzando speciali cavi trunk (Path cable). Sono disponibili versioni a parete e desktop dell'hub.

Esistono hub MAU sia passivi che attivi. L'hub attivo ripristina il segnale proveniente dall'abbonato (ovvero funziona come un hub Ethernet). Un hub passivo non ripristina il segnale, ma ricommuta solo le linee di comunicazione.

L'hub nella rete può essere l'unico (come in Fig. 7.4), in questo caso solo gli abbonati ad esso collegati sono chiusi nell'anello. Esternamente, una tale topologia sembra una stella. Se è necessario connettere più di otto abbonati alla rete, diversi hub sono collegati tramite cavi backbone e formano una topologia ad anello a stella.

Come già notato, la topologia ad anello è molto sensibile alle rotture dei cavi ad anello. Per aumentare la sopravvivenza della rete, Token-Ring prevede una modalità di cosiddetto ring folding, che consente di aggirare il luogo dell'interruzione.

In modalità normale, gli hub sono collegati ad anello da due cavi paralleli, ma le informazioni vengono trasmesse solo attraverso uno di essi (Fig. 7.6).

Riso. 7.6. Unione di hub MAU in modalità normale

In caso di rottura (rottura) di un solo cavo la rete trasmette su entrambi i cavi, bypassando così la sezione danneggiata. Allo stesso tempo, viene addirittura preservato l'ordine di bypass degli abbonati collegati ai concentratori (Fig. 7.7). È vero, la lunghezza totale dell'anello aumenta.

In caso di danneggiamento di più cavi, la rete si scompone in più parti (segmenti) che non sono interconnesse, ma rimangono perfettamente funzionanti (Fig. 7.8). La parte massima della rete rimane connessa, come prima. Naturalmente ciò non salva più la rete nel suo insieme, ma consente, con la corretta distribuzione degli abbonati agli hub, di preservare una parte significativa delle funzioni della rete danneggiata.

Più hub possono essere strutturalmente combinati in un gruppo, un cluster (cluster), all'interno del quale anche gli abbonati sono collegati ad anello. L'utilizzo dei cluster consente di aumentare il numero di abbonati collegati a un centro, ad esempio fino a 16 (se il cluster include due hub).

Riso. 7.7. Piegare l'anello quando il cavo è danneggiato

Riso. 7.8. Disintegrazione dell'anello in caso di danneggiamento multiplo del cavo

Come mezzo di trasmissione nella rete IBM Token-Ring, è stato inizialmente utilizzato il doppino intrecciato, sia non schermato (UTP) che schermato (STP), ma poi sono apparse opzioni di equipaggiamento per il cavo coassiale e per il cavo in fibra ottica nello standard FDDI.

Principale specifiche versione classica della rete Token-Ring:

- il numero massimo di hub tipo IBM 8228 MAU - 12;

- il numero massimo di abbonati nella rete è 96;

- la lunghezza massima del cavo tra l'abbonato e l'hub è di 45 metri;

- lunghezza massima del cavo tra gli hub - 45 metri;

- la lunghezza massima del cavo che collega tutti gli hub è di 120 metri;

- velocità di trasferimento dati - 4 Mbps e 16 Mbps.

Tutte le specifiche fornite si applicano all'uso di doppini intrecciati non schermati. Se viene utilizzato un mezzo di trasmissione diverso, le caratteristiche della rete possono differire. Ad esempio, quando si utilizza il doppino intrecciato schermato (STP), il numero di abbonati può essere aumentato a 260 (invece di 96), la lunghezza del cavo - fino a 100 metri (invece di 45), il numero di hub - fino a 33, e la lunghezza totale dell'anello che collega i mozzi - fino a 200 metri. Il cavo in fibra ottica consente di aumentare la lunghezza del cavo fino a due chilometri.

Per trasferire le informazioni in Token-Ring, viene utilizzato un codice bifase (più precisamente, la sua variante con una transizione obbligatoria al centro dell'intervallo di bit). Come con qualsiasi topologia a stella, non è richiesta alcuna terminazione elettrica aggiuntiva o messa a terra esterna. La negoziazione viene eseguita dall'hardware e dagli hub della scheda di rete.

I connettori RJ-45 (per doppino intrecciato non schermato), nonché i connettori MIC e DB9P vengono utilizzati per collegare i cavi in Token-Ring. I fili nel cavo collegano i pin dei connettori con lo stesso nome (ovvero vengono utilizzati i cosiddetti cavi dritti).

La classica rete Token-Ring è inferiore alla rete Ethernet sia in termini di dimensioni consentite che di numero massimo di abbonati. In termini di velocità di trasmissione, attualmente esistono versioni di Token-Ring a 100 Mbps (Token-Ring ad alta velocità, HSTR) e 1000 Mbps (Token-Ring Gigabit). Le aziende che supportano Token-Ring (tra cui IBM, Olicom, Madge) non intendono abbandonare la propria rete, considerandola un degno concorrente di Ethernet.

Rispetto alle apparecchiature Ethernet, le apparecchiature Token-Ring sono notevolmente più costose, poiché utilizzano un metodo di controllo dello scambio più complesso, quindi la rete Token-Ring non è diventata così diffusa.

Tuttavia, a differenza di Ethernet, la rete Token-Ring è molto migliore nel mantenere un livello di carico elevato (oltre il 30-40%) e fornisce tempi di accesso garantiti. Ciò è necessario, ad esempio, nelle reti industriali, in cui può comportare un ritardo nella reazione a un evento esterno gravi incidenti.

La rete Token-Ring utilizza il classico metodo di accesso a token, ovvero un token circola costantemente intorno all'anello, al quale gli abbonati possono allegare i propri pacchetti di dati (vedi Fig. 7.8). Ciò implica un vantaggio così importante di questa rete come l'assenza di conflitti, ma ci sono anche degli svantaggi, in particolare la necessità di controllare l'integrità del marcatore e la dipendenza della rete da ciascun abbonato (in caso di malfunzionamento, l'abbonato deve essere escluso dal ring).

Il limite di tempo per la trasmissione di un pacchetto in Token-Ring è di 10 ms. Con un numero massimo di abbonati di 260, il ciclo completo dell'anello sarà di 260 x 10 ms = 2,6 s. Durante questo periodo, tutti i 260 abbonati potranno trasferire i loro pacchetti (se, ovviamente, hanno qualcosa da trasferire). Allo stesso tempo, un token gratuito raggiungerà sicuramente ogni abbonato. Lo stesso intervallo è il limite superiore del tempo di accesso Token-Ring.

Ciascun abbonato di rete (la sua scheda di rete) deve svolgere le seguenti funzioni:

- rilevamento di errori di trasmissione;

- controllo della configurazione della rete (ripristino della rete in caso di guasto dell'abbonato che lo precede sul ring);

- controllo delle molteplici tempistiche adottate nella rete.

Un gran numero di funzioni, ovviamente, complica e aumenta il costo delle apparecchiature dell'adattatore di rete.

Per controllare l'integrità del token nella rete, viene utilizzato uno degli abbonati (il cosiddetto monitor attivo). Allo stesso tempo, la sua attrezzatura non è diversa dalle altre, ma i suoi strumenti software monitorano le relazioni temporali nella rete e formano un nuovo marker, se necessario.

Il monitor attivo svolge le seguenti funzioni:

- lancia un pennarello sul ring all'inizio del lavoro e quando scompare;

- regolarmente (una volta ogni 7 secondi) segnala la sua presenza con apposito pacchetto di controllo (AMP - Active Monitor Present);

- rimuove dall'anello un pacchetto che non è stato cancellato dall'abbonato che lo ha inviato;

- tiene traccia del tempo di trasmissione del pacchetto consentito.

Il monitor attivo viene selezionato all'inizializzazione della rete; può essere qualsiasi computer della rete, ma, di norma, diventa il primo abbonato connesso alla rete. Un abbonato che è diventato un monitor attivo include il proprio buffer (registro a scorrimento) nella rete, che garantisce che il marker si adatti all'anello anche con la lunghezza minima dell'anello. La dimensione di questo buffer è 24 bit per 4 Mbps e 32 bit per 16 Mbps.

Ogni abbonato controlla costantemente come il monitor attivo svolge le sue funzioni. Se il monitor attivo si guasta per qualche motivo, viene attivato un meccanismo speciale mediante il quale tutti gli altri abbonati (riserva, monitor di backup) decidono la nomina di un nuovo monitor attivo. Per fare ciò, l'abbonato che ha rilevato un errore di monitoraggio attivo invia un pacchetto di controllo (pacchetto di richiesta token) sull'anello con il suo indirizzo MAC. Ogni abbonato successivo confronta l'indirizzo MAC del pacchetto con il proprio. Se il proprio indirizzo è inferiore, passa il pacchetto invariato. Se più, allora imposta il suo indirizzo MAC nel pacchetto. Il monitor attivo sarà l'abbonato il cui indirizzo MAC è maggiore degli altri (deve ricevere tre volte un pacchetto con il suo indirizzo MAC). Un segno di guasto del monitor attivo è la mancata esecuzione di una delle funzioni elencate.

Il token di rete Token-Ring è un pacchetto di controllo contenente solo tre byte (Fig. 7.9): il byte delimitatore di inizio (SD - Start Delimiter), il byte di controllo accessi (AC - Controllo Accessi) e il byte delimitatore di fine (ED - End delimitatore). Tutti e tre questi byte fanno anche parte del pacchetto di informazioni, tuttavia le loro funzioni nel marker e nel pacchetto sono leggermente diverse.

I delimitatori di inizio e fine non sono solo una sequenza di zeri e uno, ma contengono segnali di un tipo speciale. Ciò è stato fatto in modo che i delimitatori non potessero essere confusi con nessun altro byte nei pacchetti.

Riso. 7.9. Formato token di rete Token Ring

Il delimitatore iniziale SD contiene quattro intervalli di bit non standard (Figura 7.10). Due di loro, indicati con J, sono basso livello segnale durante l'intero intervallo di bit. Gli altri due bit, indicati con K, rappresentano un livello di segnale alto durante l'intero intervallo di bit. Resta inteso che tali errori di sincronizzazione sono facilmente rilevati dal ricevitore. I bit J e K non possono mai verificarsi tra i bit del carico utile.

Riso. 7.10. Formati delimitatori iniziali (SD) e finali (ED).

Il delimitatore finale ED contiene anche quattro bit speciali (due bit J e due bit K) e due bit 1. Ma, in aggiunta, include anche due bit di informazione che hanno senso solo come parte di un pacchetto di informazioni:

- Il bit I (Intermedio) è un segno di un pacchetto intermedio (1 corrisponde al primo nella catena o al pacchetto intermedio, 0 - l'ultimo nella catena o l'unico pacchetto).

- Bit E (Error) è un segno di un errore rilevato (0 corrisponde all'assenza di errori, 1 alla loro presenza).

Il byte di controllo accessi (AC - Access Control) è suddiviso in quattro campi (Fig. 7.11): un campo di priorità (tre bit), un bit marker, un bit di monitoraggio e un campo di prenotazione (tre bit).

Riso. 7.11. Formato byte di controllo accessi

I bit di priorità (campo) consentono all'abbonato di assegnare priorità ai propri pacchetti o token (la priorità può essere da 0 a 7, con 7 corrispondente alla priorità più alta e 0 alla più bassa). Un abbonato può allegare il proprio pacchetto al token solo quando la propria priorità (la priorità dei suoi pacchetti) è uguale o superiore alla priorità del token.

Il bit marker determina se un pacchetto è collegato o meno al marker (uno corrisponde a un marker senza pacchetto, zero corrisponde a un marker con un pacchetto). Un bit di monitoraggio impostato su uno indica che il token è stato inviato dal monitor attivo.

I bit di prenotazione (campo) consentono all'abbonato di riservarsi il diritto di acquisire ulteriormente la rete, ovvero di prendere una coda per il servizio. Se la priorità dell'abbonato (la priorità dei suoi pacchetti) è maggiore del valore corrente del campo di prenotazione, allora può scrivere lì la propria priorità invece della precedente. Dopo aver fatto il giro del ring, la priorità più alta di tutti gli abbonati verrà registrata nel campo di prenotazione. Il contenuto del campo di prenotazione è simile al contenuto del campo di priorità, ma indica una priorità futura.

Grazie all'utilizzo dei campi di priorità e prenotazione, è possibile accedere alla rete solo agli abbonati che dispongono di pacchetti per la trasmissione con priorità più alta. I pacchetti con priorità inferiore verranno serviti solo quando i pacchetti con priorità più alta sono esauriti.

Il formato del pacchetto informativo (frame) Token-Ring è mostrato in fig. 7.12. Oltre ai delimitatori di inizio e fine e al byte di controllo dell'accesso, questo pacchetto include anche il byte di controllo del pacchetto, gli indirizzi di rete del ricevitore e del trasmettitore, i dati, il checksum e il byte di stato del pacchetto.

Riso. 7.12. Formato a pacchetto (frame) della rete Token-Ring (la lunghezza dei campi è espressa in byte)

Scopo dei campi di un pacchetto (frame).

- Il separatore di inizio (SD) è un segno dell'inizio del pacchetto, il formato è lo stesso del marcatore.

- Il byte di controllo di accesso (AC) ha lo stesso formato del token.

- Il byte Frame Control (FC) definisce il tipo di pacchetto (frame).

- Gli indirizzi MAC a sei byte dell'origine e della destinazione di un pacchetto seguono il formato standard descritto nel Capitolo 4.

- Il campo dati (Dati) comprende i dati da trasmettere (nel pacchetto di informazioni) o le informazioni di controllo dello scambio (nel pacchetto di controllo).

- Il campo Frame Check Sequence (FCS) è un checksum ciclico a 32 bit del pacchetto (CRC).

- Il delimitatore finale (ED), come nel token, indica la fine del pacchetto. Inoltre, determina se il dato pacchetto è intermedio o finale nella sequenza dei pacchetti trasmessi e contiene anche un segno di errore di pacchetto (vedi Figura 7.10).

- Il byte di stato del pacchetto (FS - Frame Status) indica cosa è successo a questo pacchetto: se è stato visto dal ricevitore (cioè se esiste un ricevitore con un determinato indirizzo) e copiato nella memoria del ricevitore. Da esso, il mittente del pacchetto saprà se il pacchetto è arrivato a destinazione e senza errori o se deve essere ritrasmesso.

Va notato che la maggiore dimensione consentita dei dati trasmessi in un pacchetto rispetto alla rete Ethernet può essere un fattore decisivo per aumentare le prestazioni della rete. In teoria, per velocità di trasmissione di 16 Mbps e 100 Mbps, la lunghezza del campo dati può raggiungere anche 18 KB, il che è importante quando si trasferiscono grandi quantità di dati. Ma anche a 4 Mbps, grazie al metodo di accesso a token, una rete Token-Ring fornisce spesso una velocità di trasferimento effettiva maggiore rispetto a una rete Ethernet (10 Mbps). Il vantaggio del Token-Ring è particolarmente evidente a carichi elevati (oltre il 30-40%), poiché in questo caso il metodo CSMA/CD richiede molto tempo per risolvere conflitti ripetuti.

Un abbonato che desidera trasmettere un pacchetto attende l'arrivo di un token gratuito e lo cattura. Il token acquisito si trasforma in un frame di pacchetto di informazioni. Quindi l'abbonato invia un pacchetto informativo all'anello e attende il suo ritorno. Dopodiché, rilascia il token e lo rimanda alla rete.

Oltre al token e al pacchetto regolare, nella rete Token-Ring può essere trasmesso uno speciale pacchetto di controllo, che serve ad interrompere la trasmissione (Abort). Può essere inviato in qualsiasi momento e ovunque nel flusso di dati. Questo pacchetto è costituito da due campi da un byte: i delimitatori iniziali (SD) e finali (ED) del formato descritto.

È interessante notare che la versione più veloce di Token-Ring (16 Mbps e superiore) utilizza il cosiddetto metodo ETR (Early Token Release). Consente di evitare un uso improduttivo della rete mentre il pacchetto di dati non ritorna attraverso l'anello al suo mittente.

Il metodo ETR si riduce al fatto che immediatamente dopo la trasmissione del proprio pacchetto allegato al token, qualsiasi abbonato emette un nuovo token gratuito alla rete. Altri abbonati possono iniziare a trasmettere i loro pacchetti subito dopo la fine del pacchetto dell'abbonato precedente, senza attendere che completi il bypass dell'intero anello di rete. Di conseguenza, nella rete possono trovarsi più pacchetti contemporaneamente, ma non ci sarà sempre più di un token gratuito. Questa pipeline è particolarmente efficace su reti lunghe con un ritardo di propagazione significativo.

Quando l'abbonato è collegato all'hub, esegue la procedura di autotest autonomo e di test dei cavi (non è ancora compreso nell'anello, poiché non è presente il segnale di corrente phantom). L'abbonato invia a se stesso una serie di pacchetti e ne verifica la correttezza del passaggio (il suo ingresso è direttamente collegato alla sua uscita dalla TCU, come mostrato in Fig. 7.4). Successivamente, l'abbonato si include nell'anello, inviando una corrente fantasma. Al momento dell'inclusione, il pacchetto trasmesso sull'anello potrebbe essere danneggiato. Successivamente, l'abbonato imposta la sincronizzazione e verifica la presenza di un monitor attivo sulla rete. Se non c'è un monitor attivo, l'abbonato avvia un concorso per il diritto a diventarlo. Quindi l'abbonato controlla l'unicità del proprio indirizzo sul ring e raccoglie informazioni sugli altri abbonati. Successivamente, diventa un partecipante a pieno titolo allo scambio sulla rete.

Durante lo scambio, ogni abbonato controlla lo stato dell'abbonato precedente (lungo il ciclo). Se sospetta il fallimento dell'abbonato precedente, avvia la procedura recupero automatico anelli. Uno speciale pacchetto di controllo (beacon) informa l'abbonato precedente della necessità di eseguire un autotest e, eventualmente, di disconnettersi dall'anello.

La rete Token-Ring prevede anche l'utilizzo di bridge e switch. Sono utilizzati per dividere un anello di grandi dimensioni in più segmenti di anello che possono scambiare pacchetti tra loro. Ciò consente di ridurre il carico su ciascun segmento e aumentare la quota di tempo fornita a ciascun abbonato.

Di conseguenza, è possibile formare un anello distribuito, ovvero la combinazione di più segmenti dell'anello con un grande anello di dorsale (Fig. 7.13) o una struttura ad anello a stella con un interruttore centrale a cui sono collegati i segmenti dell'anello ( Fig. 7.14).

Riso. 7.13. Combinazione di segmenti con un anello principale utilizzando i ponti

Riso. 7.14. Combinazione di segmenti con un interruttore centrale

La rete Arcnet (o ARCnet dall'inglese Attached Resource Computer Net, una rete di computer di risorse connesse) è una delle reti più antiche. È stato sviluppato da Datapoint Corporation nel 1977. Non esistono standard internazionali per questa rete, sebbene sia considerata l'antenata del metodo di accesso tramite token. Nonostante la mancanza di standard, la rete Arcnet fino a poco tempo (nel 1980 - 1990) era popolare, anche seriamente in competizione con Ethernet. Un gran numero di aziende (ad esempio Datapoint, Standard Microsystems, Xircom, ecc.) ha prodotto apparecchiature per questo tipo di rete. Ma ora la produzione di apparecchiature Arcnet è praticamente interrotta.

Tra i principali vantaggi della rete Arcnet rispetto a Ethernet vi sono il tempo di accesso limitato, l'elevata affidabilità della comunicazione, la facilità di diagnostica e il costo relativamente basso degli adattatori. Gli svantaggi più significativi della rete includono la bassa velocità di trasferimento delle informazioni (2,5 Mbps), il sistema di indirizzamento e il formato del pacchetto.

Per trasmettere informazioni nella rete Arcnet, viene utilizzato un codice piuttosto raro, in cui due impulsi corrispondono a un'unità logica durante un intervallo di bit e un impulso corrisponde a uno zero logico. Ovviamente, questo è un codice auto-sincronizzante che richiede una larghezza di banda del cavo ancora maggiore di quella di Manchester.

Come mezzo di trasmissione nella rete viene utilizzato un cavo coassiale con un'impedenza caratteristica di 93 ohm, ad esempio marca RG-62A/U. Le versioni a doppino intrecciato (schermato e non schermato) non sono ampiamente utilizzate. Sono state proposte anche opzioni in fibra ottica, ma non hanno nemmeno salvato Arcnet.

La rete Arcnet utilizza un bus classico (Arcnet-BUS) e una stella passiva (Arcnet-STAR) come topologia. Gli hub sono usati nella stella. È possibile combinare segmenti bus e segmenti a stella in una topologia ad albero utilizzando hub (come in Ethernet). Il limite principale è che non ci dovrebbero essere percorsi chiusi (loop) nella topologia. Un'altra limitazione: il numero di segmenti collegati in daisy chain tramite hub non deve superare tre.

Gli hub sono di due tipi:

- Concentratori attivi (ripristinano la forma dei segnali in ingresso e li amplificano). Il numero di porte è compreso tra 4 e 64. Gli hub attivi possono essere interconnessi (in cascata).

- Hub passivi (mescola semplicemente i segnali in entrata senza amplificazione). Il numero di porte è 4. Gli hub passivi non possono essere interconnessi. Possono associare solo hub attivi e/o schede di rete.

I segmenti di bus possono essere collegati solo agli hub attivi.

Anche le schede di rete sono di due tipi:

- Alta impedenza (Bus) progettato per l'uso in segmenti di bus:

- Bassa impedenza (Star) progettata per l'uso in una stella passiva.

Gli adattatori a bassa impedenza differiscono dagli adattatori ad alta impedenza in quanto contengono terminatori corrispondenti da 93 ohm. Quando si utilizzano, non è richiesta l'approvazione esterna. Nei segmenti di bus, gli adattatori a bassa impedenza possono essere utilizzati come terminatori per la terminazione del bus. Gli adattatori ad alta impedenza richiedono l'uso di terminatori esterni da 93 ohm. Alcuni adattatori di rete hanno la capacità di passare da uno stato ad alta impedenza a uno stato a bassa impedenza, possono funzionare in un bus o in una stella.

Pertanto, la topologia della rete Arcnet è la seguente (Fig. 7.15).

Riso. 7.15. Topologia bus Arcnet (B - adattatori bus, S - adattatori a stella)

Le principali caratteristiche tecniche della rete Arcnet sono le seguenti.

- Mezzo di trasmissione - cavo coassiale, doppino intrecciato.

- La lunghezza massima della rete è di 6 chilometri.

- La lunghezza massima del cavo dall'abbonato all'hub passivo è di 30 metri.

- La lunghezza massima del cavo dall'abbonato all'hub attivo è di 600 metri.

- La lunghezza massima del cavo tra hub attivi e passivi è di 30 metri.

- La lunghezza massima del cavo tra gli hub attivi è di 600 metri.

- Il numero massimo di abbonati nella rete è 255.

- Il numero massimo di abbonati sul segmento bus è 8.

- La distanza minima tra gli abbonati nell'autobus è di 1 metro.

- La lunghezza massima di un segmento di pneumatico è di 300 metri.

- La velocità di trasferimento dati è di 2,5 Mbps.

Quando si creano topologie complesse, è necessario assicurarsi che il ritardo di propagazione del segnale nella rete tra gli abbonati non superi i 30 μs. L'attenuazione massima del segnale nel cavo a una frequenza di 5 MHz non deve superare 11 dB.

La rete Arcnet utilizza un metodo di accesso tramite token (trasferimento dei diritti), ma è leggermente diverso da quello della rete Token-Ring. Questo metodo è il più vicino a quello fornito nello standard IEEE 802.4. La sequenza di azioni degli abbonati con questo metodo:

1. L'abbonato che vuole inviare attende l'arrivo del token.

2. Ricevuto il token, invia una richiesta di trasmissione delle informazioni al destinatario-abbonato (chiede se il destinatario è pronto ad accettare il suo pacchetto).

3. Il destinatario, ricevuta la richiesta, invia una risposta (ne conferma la prontezza).

4. Ricevuta la conferma di disponibilità, l'abbonato-trasmettitore invia il proprio pacchetto.

5. Ricevuto il pacco, il destinatario invia un avviso di ricevimento del pacco.

6. Il trasmettitore, ricevuta conferma di ricezione del pacco, conclude la propria sessione di comunicazione. Successivamente, il token viene passato all'abbonato successivo in ordine decrescente di indirizzi di rete.

Pertanto, in questo caso, il pacchetto viene trasmesso solo quando si ha la certezza che il destinatario sia pronto a riceverlo. Ciò aumenta notevolmente l'affidabilità della trasmissione.

Proprio come nel caso di Token-Ring, i conflitti in Arcnet sono completamente esclusi. Come qualsiasi rete a token, Arcnet mantiene bene il carico e garantisce la quantità di tempo di accesso alla rete (a differenza di Ethernet). Il tempo totale per il marcatore per ignorare tutti gli abbonati è 840 ms. Di conseguenza, lo stesso intervallo determina il limite superiore del tempo di accesso alla rete.

Il marcatore è formato da un abbonato speciale: il controller di rete. È l'abbonato con l'indirizzo minimo (zero).

Se l'abbonato non riceve un token gratuito entro 840 ms, invia una lunga sequenza di bit alla rete (per garantire la distruzione del vecchio token danneggiato). Successivamente viene eseguita la procedura di monitoraggio della rete e di assegnazione (se necessaria) di un nuovo controllore.

La dimensione del pacchetto Arcnet è 0,5 KB. Oltre al campo dati, include anche indirizzi di ricevitore e trasmettitore a 8 bit e un checksum ciclico (CRC) a 16 bit. Una dimensione del pacchetto così piccola non è molto conveniente con un'elevata intensità di scambio sulla rete.

Le schede di rete Arcnet differiscono dalle altre schede di rete in quanto richiedono interruttori o ponticelli per impostare il proprio indirizzo di rete (possono essere 255 in totale, poiché l'ultimo, 256esimo indirizzo viene utilizzato nella rete per la modalità broadcast). Il controllo dell'unicità di ciascun indirizzo di rete è interamente responsabilità degli utenti della rete. Connettere nuovi abbonati diventa piuttosto complicato, poiché è necessario impostare l'indirizzo che non è stato ancora utilizzato. La scelta di un formato di indirizzo a 8 bit limita il numero consentito di abbonati nella rete a 255, il che potrebbe non essere sufficiente per le grandi aziende.

Di conseguenza, tutto ciò ha portato al quasi completo abbandono della rete Arcnet. C'erano versioni della rete Arcnet progettate per una velocità di trasferimento di 20 Mbps, ma non erano ampiamente utilizzate.

Articoli da leggere:

Lezione 6: Segmenti di rete Ethernet standard/Fast Ethernet

Fast Ethernet - la specifica IEEE 802.3 u, adottata ufficialmente il 26 ottobre 1995, definisce lo standard di protocollo del livello di collegamento per le reti che operano utilizzando sia cavo in rame che fibra ottica alla velocità di 100 Mb/s. La nuova specifica è un successore dello standard Ethernet IEEE 802.3, utilizzando lo stesso formato frame, meccanismo di accesso ai supporti CSMA/CD e topologia a stella. L'evoluzione ha interessato diversi elementi della configurazione delle strutture del livello fisico, che ha aumentato il throughput, inclusi i tipi di cavo utilizzati, la lunghezza dei segmenti e il numero di hub.

Strato fisico

Lo standard Fast Ethernet definisce tre tipi di supporti di segnalazione Ethernet a 100 Mbps.

· 100Base-TX - due doppini intrecciati. La trasmissione avviene secondo lo standard per la trasmissione di dati in un supporto fisico twistato, sviluppato dall'ANSI (American National Standards Institute - American National Standards Institute). Il cavo dati twistato può essere schermato o non schermato. Utilizza l'algoritmo di codifica dei dati 4V/5V e il metodo di codifica fisica MLT-3.

· 100Base-FX - cavo a due fili in fibra ottica. La trasmissione avviene anche secondo lo standard per la trasmissione di dati su supporti in fibra ottica, sviluppato dall'ANSI. Utilizza l'algoritmo di codifica dei dati 4V/5V e il metodo di codifica fisica NRZI.

· 100Base-T4 è una specifica specifica sviluppata dal comitato IEEE 802.3u. Secondo questa specifica, la trasmissione dei dati viene eseguita su quattro doppini intrecciati di cavo telefonico, chiamato cavo UTP di categoria 3. Utilizza l'algoritmo di codifica dei dati 8V/6T e il metodo di codifica fisica NRZI.

Cavo multimodale

Questo tipo di cavo in fibra ottica utilizza una fibra con un diametro del nucleo di 50 o 62,5 micrometri e una guaina esterna di 125 micrometri di spessore. Tale cavo è chiamato cavo ottico multimodale con fibre da 50/125 (62,5/125) micrometriche. Per trasmettere un segnale luminoso su un cavo multimodale, viene utilizzato un ricetrasmettitore LED con una lunghezza d'onda di 850 (820) nanometri. Se un cavo multimodale collega due porte di switch operanti in modalità full duplex, può essere lungo fino a 2000 metri.

Cavo monomodale

Il cavo in fibra ottica monomodale ha un diametro del nucleo più piccolo di 10 micrometri rispetto alla fibra multimodale e un ricetrasmettitore laser viene utilizzato per la trasmissione su cavo monomodale, che insieme garantisce una trasmissione efficiente su lunghe distanze. La lunghezza d'onda del segnale luminoso trasmesso è vicina al diametro del nucleo, che è di 1300 nanometri. Questo numero è noto come lunghezza d'onda di dispersione zero. In un cavo monomodale, la dispersione e la perdita di segnale sono molto ridotte, il che consente la trasmissione di segnali luminosi su distanze maggiori rispetto al caso di utilizzo di fibra multimodale.

38. Tecnologia Gigabit Ethernet, caratteristiche generali, specificazione dell'ambiente fisico, concetti di base.

3.7.1. Caratteristiche generali della norma

Abbastanza rapidamente dopo la comparsa dei prodotti Fast Ethernet sul mercato, gli integratori di rete e gli amministratori hanno sentito alcuni limiti nella costruzione reti aziendali. In molti casi, i server collegati su un collegamento a 100 Mbps hanno sovraccaricato le dorsali di rete che operano anche a 100 Mbps, le dorsali FDDI e Fast Ethernet. C'era bisogno di un livello successivo nella gerarchia delle velocità. Nel 1995, solo gli switch ATM potevano fornire un livello di velocità più elevato e, in assenza di mezzi convenienti per migrare questa tecnologia alle reti locali in quel momento (sebbene la specifica LAN Emulation - LANE fosse stata adottata all'inizio del 1995, la sua implementazione pratica era in anticipo ) per introdurli in Quasi nessuno ha osato la rete locale. Inoltre, la tecnologia ATM era molto costosa.

Pertanto, il passo successivo compiuto dall'IEEE sembrava logico: 5 mesi dopo l'adozione finale dello standard Fast Ethernet nel giugno 1995, l'IEEE High-Speed Research Group è stato incaricato di considerare la possibilità di sviluppare uno standard Ethernet con bit rate.

Nell'estate del 1996, il gruppo 802.3z è stato annunciato per sviluppare un protocollo il più vicino possibile a Ethernet, ma con un bit rate di 1000 Mbps. Come per Fast Ethernet, il messaggio è stato accolto con grande entusiasmo dai sostenitori di Ethernet.

Il motivo principale dell'entusiasmo era la prospettiva della stessa transizione graduale delle dorsali di rete a Gigabit Ethernet, in modo simile a come i segmenti Ethernet sovraccarichi situati ai livelli inferiori della gerarchia di rete venivano trasferiti a Fast Ethernet. Inoltre, c'era già esperienza nella trasmissione di dati a velocità gigabit, sia nelle reti territoriali (tecnologia SDH) che nelle reti locali - tecnologia Fibre Channel, che viene utilizzata principalmente per collegare periferiche ad alta velocità a grandi computer e trasmette i dati su fibra cavo ottico da Near Gigabit tramite codice di ridondanza 8V/10V.

La prima versione dello standard è stata presa in considerazione nel gennaio 1997 e lo standard 802.3z finale è stato adottato il 29 giugno 1998 in una riunione del comitato IEEE 802.3. Il lavoro sull'implementazione di Gigabit Ethernet su doppino intrecciato di categoria 5 è stato trasferito a un comitato speciale 802.3ab, che ha già preso in considerazione diverse opzioni per la bozza di questo standard, e dal luglio 1998 il progetto è diventato abbastanza stabile. L'adozione definitiva dello standard 802.3ab è prevista per settembre 1999.

Senza attendere l'adozione dello standard, alcune aziende hanno rilasciato le prime apparecchiature Gigabit Ethernet su cavo in fibra ottica entro l'estate del 1997.

L'idea principale degli sviluppatori dello standard Gigabit Ethernet è quella di preservare al massimo le idee della classica tecnologia Ethernet raggiungendo un bit rate di 1000 Mbps.

Poiché quando si sviluppa una nuova tecnologia, è naturale aspettarsi alcune innovazioni tecniche che vanno nella direzione generale dello sviluppo tecnologie di rete, è importante notare che Gigabit Ethernet, così come le sue controparti più lente, a livello di protocollo non lo farà sostegno:

- qualità del servizio;

- collegamenti ridondanti;

- testare l'operabilità di nodi e apparecchiature (in quest'ultimo caso, ad eccezione del test della comunicazione porta a porta, come avviene per Ethernet 10Base-T e 10Base-F e Fast Ethernet).

Tutte e tre queste proprietà sono considerate molto promettenti e utili reti moderne, e soprattutto nelle reti del prossimo futuro. Perché gli autori di Gigabit Ethernet li rifiutano?

L'idea principale degli sviluppatori della tecnologia Gigabit Ethernet è che ci sono e ci saranno molte reti in cui l'elevata velocità della dorsale e la capacità di assegnare priorità ai pacchetti negli switch saranno abbastanza sufficienti per garantire la qualità di servizio di trasporto per tutti i client della rete. E solo in quei rari casi in cui la dorsale è piuttosto occupata e i requisiti di qualità del servizio sono molto severi, è necessario utilizzare la tecnologia ATM, che proprio per la sua elevata complessità tecnica garantisce la qualità del servizio per tutte le principali tipologie di traffico.

39. Sistema di cablaggio strutturale utilizzato nelle tecnologie di rete.

Un sistema di cablaggio strutturato (SCS) è un insieme di elementi di commutazione (cavi, connettori, connettori, pannelli trasversali e armadi), nonché una tecnica per il loro uso congiunto, che consente di creare strutture di comunicazione regolari e facilmente espandibili nelle reti di computer .

Un sistema di cablaggio strutturato è una sorta di "costruttore", con l'aiuto del quale il progettista di rete costruisce la configurazione di cui ha bisogno da cavi standard collegati da connettori standard e pannelli trasversali standard accesi. Se necessario, la configurazione della connessione può essere facilmente modificata: aggiungere un computer, segmentare, cambiare, rimuovere le apparecchiature non necessarie e anche modificare le connessioni tra computer e hub.

Quando si costruisce un sistema di cablaggio strutturato, è chiaro che ogni luogo di lavoro dell'azienda deve essere dotato di prese per il collegamento di un telefono e di un computer, anche se attualmente non è necessario. Cioè, un buon sistema di cablaggio strutturato è ridondante. Ciò può far risparmiare denaro in futuro, poiché è possibile apportare modifiche alla connessione di nuovi dispositivi ricollegando i cavi già posati.

Una tipica struttura gerarchica di un sistema di cablaggio strutturato comprende:

- sottosistemi orizzontali (all'interno del pavimento);

- sottosistemi verticali (all'interno dell'edificio);

- sottosistema campus (all'interno dello stesso territorio con più edifici).

Sottosistema orizzontale collega la traversa del pavimento alle prese utente. I sottosistemi di questo tipo corrispondono ai piani dell'edificio. Sottosistema verticale collega gli armadi trasversali di ogni piano con la sala di controllo centrale dell'edificio. Il prossimo passo nella gerarchia è sottosistema campus, che collega diversi edifici all'hardware principale dell'intero campus. Questa parte del sistema di cavi viene comunemente chiamata backbone.

L'utilizzo di un sistema di cablaggio strutturato anziché di un cablaggio caotico offre molti vantaggi a un'azienda.

· Versatilità. Un sistema di cablaggio strutturato ben congegnato può diventare un unico ambiente per la trasmissione di dati informatici in una rete locale, l'organizzazione di una rete telefonica locale, la trasmissione di informazioni video e persino la trasmissione di segnali da sensori di sicurezza antincendio o sistemi di sicurezza. Ciò consente di automatizzare molti processi di controllo, monitoraggio e gestione dei servizi aziendali e dei sistemi di supporto vitale dell'impresa.

· Vita utile estesa. Il periodo di obsolescenza di un sistema di cablaggio ben strutturato può essere di 10-15 anni.

· Riduci il costo dell'aggiunta di nuovi utenti e della modifica dei loro posizionamenti.È noto che il costo di un impianto in cavo è rilevante ed è determinato principalmente non dal costo del cavo, ma dal costo della sua posa. Pertanto, è più vantaggioso eseguire un unico lavoro di posa del cavo, possibilmente con un ampio margine di lunghezza, che eseguire più volte la posa, aumentando la lunghezza del cavo. Con questo approccio, tutto il lavoro sull'aggiunta o lo spostamento di un utente si riduce al collegamento del computer a una presa esistente.