Weboldal indexelés a keresőmotorokban – hogyan történik és hogyan gyorsíthatjuk fel - 5,0 az 5-ből 1 szavazat alapján

A saját webhely létrehozása után sok webmester megnyugszik, és azt gondolja, hogy a legnehezebb része már elmúlt. Valójában ez nem igaz. Először is, az oldal a látogatók számára készült.

Végül is a látogatók olvassák el a cikkeket tartalmazó oldalakat, és vásárolják meg a webhelyen közzétett árukat és szolgáltatásokat. Minél több látogató, annál nagyobb a profit. A keresőkből érkező forgalom pedig mindennek az alapja, ezért nagyon fontos, hogy az oldal gyorsan indexelve legyen, és az oldalak stabilan maradjanak az indexben.

Ha nincs forgalom, akkor kevesen fognak tudni az oldalról, ez a helyzet különösen fontos a fiatal internetes források számára. A jó indexelés elősegíti, hogy oldala a lehető leghamarabb a keresők élére kerüljön, és ennek eredményeként nagyszámú megcélzott látogatót vonz.

Mi az indexelés és hogyan működik?

Először is meg kell értened, mi az. A webhely indexelése az a folyamat, amikor információkat gyűjtenek a webhelyek oldalairól, majd beírják azokat a keresőmotor adatbázisába. Ezt követően a kapott adatok feldolgozása megtörténik. Ezután egy idő után az oldal megjelenik a keresőmotor találatai között, és az emberek megtalálhatják ezt a keresőt használva.

Az információkat gyűjtő és elemző programokat keresőrobotoknak vagy botoknak nevezzük. Minden keresőmotornak megvannak a saját robotjai. Mindegyiknek megvan a maga neve és célja.

Például a Yandex keresőrobotjainak 4 fő típusa van:

1. Weboldalakat indexelő robot. Feladata a talált tartalommal rendelkező oldalak felderítése és az adatbázisba való bevitele.

2. Robot, amely indexeli a képeket. Feladata mindent felderíteni és a kereső adatbázisába bevinni grafikus fájlok a webhely oldalairól. Ezeket a képeket ezután a felhasználók megtalálhatják a Google képkeresőjében vagy a Yandex.Images szolgáltatásban.

3. Robot, amely indexeli a webhelytükröket. Néha a webhelyeknek több tükre is van. Ennek a robotnak az a feladata, hogy azonosítsa ezeket a tükröket a robots.txt fájlból származó információk alapján, majd a keresés során csak a fő tükröt biztosítsa a felhasználóknak.

4. Robot, amely ellenőrzi a webhely elérhetőségét. Feladata az, hogy rendszeresen ellenőrizze a Yandex.Webmasteren keresztül hozzáadott webhely elérhetőségét.

A fentieken kívül vannak más típusú robotok is. Például olyan robotok, amelyek videófájlokat és kedvenc ikonokat indexelnek a webhelyek oldalain, olyan robotok, amelyek „gyors” tartalmat indexelnek, valamint olyan robotok, amelyek ellenőrzik a Yandex.Catalogue-ban található internetes erőforrások teljesítményét.

A weboldalak keresőmotorok általi indexelésének megvannak a maga sajátosságai. Ha a robot észleli a helyszínen új oldal, akkor bekerül az adatbázisába. Ha a robot változásokat rögzít a régi oldalakon, akkor azok korábban az adatbázisba felvett verzióit törli, és újakkal helyettesíti. És mindez egy bizonyos időtartam alatt, általában 1-2 hét alatt történik. Az ilyen hosszú időszakokat az magyarázza, hogy a keresőrobotoknak nagy mennyiségű információval kell dolgozniuk (új nagyszámúúj oldalak, és a régiek is frissülnek).

Most azokról a fájlokról, amelyeket a keresőrobotok képesek indexelni.

A keresőmotorok a weboldalak mellett néhány zárt formátumú fájlt is indexelnek, de bizonyos korlátozásokkal. A PDF-ben tehát csak szöveges tartalmat olvasnak a robotok. A Flash-fájlok gyakran egyáltalán nincsenek indexelve (vagy csak a speciális blokkokban található szövegeket indexeli). Ezenkívül a robotok nem indexelnek 10 megabájtnál nagyobb fájlokat. A legjobb dolog kereső motorok megtanult szöveget indexelni. Indexelésekor minimális számú hiba megengedett, a tartalom teljes egészében bekerül az adatbázisba.

Összefoglalva, sok keresőmotor jelenleg képes olyan formátumokat indexelni, mint a TXT, PDF, DOC és DOCX, Flash, XLS és XLSX, PPT és PPTX, ODP, ODT, RTF.

Hogyan lehet felgyorsítani a webhely indexelési folyamatát a keresőmotorokban

Sok webmester gondolkodik azon, hogyan lehetne felgyorsítani az indexelést. Először is meg kell értenie, hogy mik az indexelési időszakok. Ez az idő a keresőrobot webhelylátogatásai között. És ez az idő több perctől is változhat (nagyon információs portálok) akár több hétig vagy akár hónapig (elfelejtett és elhagyott kis vagy új oldalakon).

A tartalomlopás nem ritka. Valaki egyszerűen lemásolhatja a cikket, és felteheti a webhelyére. Ha egy keresőmotor indexeli ezt a cikket, mielőtt az megtörténne az Ön webhelyén, akkor a keresőmotorok ezt a webhelyet tekintik a szerzőnek, és nem a tiédnek. És bár ma megjelentek olyan eszközök, amelyek lehetővé teszik a tartalom szerzőségének jelzését, a webhelyoldalak indexelésének sebessége nem veszíti el relevanciáját.

Ezért az alábbiakban tanácsokat adunk, hogyan kerülheti el mindezt, és hogyan gyorsíthatja fel erőforrása indexelését.

1. Használja az "URL hozzáadása" funkciót (URL hozzáadása)- ezek az úgynevezett addurilki-k, amelyek olyan űrlapok, amelyekbe beírhatja és hozzáadhatja a webhely bármely oldalának címét. Az oldal ebben az esetben bekerül az indexelési sorba.

Számos nagy keresőben elérhető. Annak érdekében, hogy ne kelljen a webhelyoldalak hozzáadásához szükséges űrlapok összes címét megkeresnie, ezeket egy külön cikkben gyűjtöttük össze: " ". Ez a módszer nem nevezhető 100%-os védelemnek a plágium ellen, de az jó út tájékoztatja a keresőt az új oldalakról.

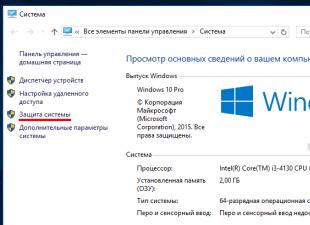

2. Regisztrálja webhelyét a Google Webmestereszközökben és a Yandex.Webmaster szolgáltatásban. Itt láthatja, hogy a webhely hány oldala van már indexelve, és hány nem indexelve. Hozzáadhat oldalakat az indexelési sorhoz, és sokkal többet tehet az ott rendelkezésre álló eszközök segítségével.

3. Hozzon létre egy webhelytérképet két formátumban - HTML és XML. Az első a webhelyen való elhelyezéshez és a könnyű navigációhoz szükséges. A második térkép a keresőmotorokhoz szükséges. Szöveges hivatkozásokat tartalmaz webhelye összes oldalára. Ezért az indexelés során a robot egyiket sem hagyja ki. Webhelytérkép készíthető CMS-bővítmények vagy számos online szolgáltatás használatával.

Néhány kiváló megoldás létrehozására a következők:

- Mert CMS Joomla Xmap komponens;

- WordPresshez Google plugin XML oldaltérképek;

- CMS Drupal modulhoz SitemapXML;

- A webhelytérkép univerzális eszköze a www.mysitemapgenerator.com szolgáltatás lehet.

4. Cikkek bejelentése a közösségi hálózatokon - Google +1, Twitter, Facebook, Vkontakte. Közvetlenül azután, hogy új cikket ad hozzá az oldalhoz, jelentse be a Google+-oldalán, a Twitter hírfolyamán, valamint a Facebook és a Vkontakte oldalain. A legjobb, ha közösségi hálózat gombjait helyezi el a webhelyen, és egyszerűen a gombokra kattintva hirdetményeket ad hozzá. Beállíthat automatikus bejelentéseket a Twitteren és a Facebookon.

5. Keresztbejegyzések különböző blogplatformokon. Létrehozhat magának blogokat olyan szolgáltatásokon, mint például: Li.ru, Livejournal.com, wordpress.ru, blogspot.com, és ott közzéteheti cikkeinek rövid közleményeit a rájuk mutató hivatkozásokkal. teljes verziók a webhelyén.

6. Készítsen RSS-hírcsatornát a webhelyhez, és regisztrálja azt különböző RSS-könyvtárakba. Címüket a következő cikkben találja meg: "".

7. A webhely frissítéseinek gyakorisága. Minél gyakrabban jelennek meg új anyagok a webhelyén, annál gyakrabban keresik fel a keresőrobotok. Új webhely esetén a legjobb, ha ezt minden nap, de legalább minden második nap megteszi.

9. Csak egyedi tartalmat tegyen közzé webhelyén. Ez egyetemes szabály, ami nemcsak az indexelési folyamatot javítja. Minél egyedibb az anyag, a keresőmotorok annál jobban kezelik webhelyét. Minél gyakrabban keresik fel Önt a keresőrobotok.

Ezek a módszerek az indexelés felgyorsítására elégségesek lesznek egy fiatal vagy középkorú webhely számára. Nem fognak sok időt igénybe venni, és jó hatást fejtenek ki.

Az oldalindexelés tilalma

Bizonyos esetekben a webmesternek be kell zárnia a webhelyet az indexelésből, vagy be kell zárnia annak egyes oldalait és szakaszait. Miért lehet erre szükség? Például webhelyének egyes oldalai nem tartalmaznak hasznos információ, ezek különféle technikai oldalak lehetnek. Vagy le kell tiltani az indexelést a felesleges külső linkek, bannerek stb.

1. Robots.txt.

A robots.txt fájl segítségével letilthatja az egyes oldalak és erőforrásrészek indexelését. A gyökérkönyvtárba kerül. Szabályokat határoz meg a keresőrobotok számára az egyes oldalak, szakaszok, sőt az egyes keresőmotorok indexelésére vonatkozóan.

A fájl speciális direktíváival nagyon rugalmasan szabályozhatja az indexelést.

Íme néhány példa:

A következő direktíva használatával megakadályozhatja, hogy az összes keresőmotor indexelje a teljes webhelyet:

User-agent: * Disallow: /

Egy adott könyvtár indexelésének megakadályozása:

User-Agent: * Disallow: /files/

Indexelés letiltása oldal URL-jeit ami tartalmaz "?":

User-agent: * Disallow: /*?

Stb. A robots.txt fájl számos direktívával és képességgel rendelkezik, és ez egy külön cikk témája.

2. Van még egy noindex és nofollow címke és metacímke.

Ha meg szeretné akadályozni, hogy bizonyos tartalmak indexelve legyenek az oldalon, egyszerűen helyezze el a címkék közé , de ezek a címkék csak a Yandex keresőmotornál működnek.

Ha le kell tiltania egy webhely egy vagy több oldalának indexelését, használhat metacímkéket. Ehhez a webhely oldalán a címkék között

hozzá kell adnia a következőket:Ha hozzáadja:

akkor a dokumentum szintén nem lesz indexelve.

Ha hozzáadja:

akkor a keresőrobot nem követi az ezen az oldalon elhelyezett linkeket, hanem magát az oldalt indexeli.

Ebben az esetben a metacímkékben megadottak elsőbbséget élveznek a robots.txt fájl direktíváival szemben. Ezért ha megtiltja webhelye egy bizonyos könyvtárának indexelését a robots.txt fájlban és magukon a webhelyoldalakon, amelyek ehhez a könyvtárhoz tartoznak, a következő metacímke jelenik meg:

Ekkor az oldaladatok továbbra is indexelve lesznek.

Ha az oldal valamilyen CMS-re épül, akkor némelyikben lehetőség van az oldal bezárására az indexelésre speciális opciókkal. Más esetekben ezeket a metacímkéket manuálisan kell beilleszteni a webhely oldalaiba.

A következő cikkekben részletesen megvizsgáljuk az indexelés tiltásának eljárását és minden ezzel kapcsolatos dolgot (a robots.txt fájl, valamint a noindex címkékés nofollow).

Problémák az indexeléssel és az oldalak kiesése az indexből

Számos oka lehet annak, hogy egy internetes erőforrás nem indexelhető. Az alábbiakban felsoroljuk a leggyakoribbakat.

1. A Robots.txt fájl nincs megfelelően konfigurálva, vagy a .

2. Az Ön webhelyének domainjét már használták egy bizonyos webhelyhez, és rossz előzményei vannak, valószínűleg korábban valamilyen szűrőt alkalmaztak rá. Az ilyen jellegű problémák leggyakrabban a Yandex indexeléséhez kapcsolódnak. Előfordulhat, hogy a webhely oldalai az indexbe kerüljenek, amikor először indexelték őket, majd teljesen összeomlanak, és már nincsenek indexelve. Amikor felveszi a kapcsolatot a Yandex ügyfélszolgálatával, valószínűleg azt fogják mondani, hogy fejlessze az oldalt, és minden rendben lesz.

De amint azt a gyakorlat mutatja, még 6 hónapig a kiváló minőségű egyedi tartalom webhelyen történő közzététele után sem fordulhat elő pozitív irányba. Ha hasonló helyzetben van, és az oldalt 1-2 hónapja nem indexelték, akkor jobb. Általános szabály, hogy ezután minden a helyére kerül, és megkezdődik a webhely oldalainak indexelése.

3. Nem egyedi tartalom. Csak egyedi anyagokat adjon hozzá az oldalhoz. Ha webhelyének oldalain nagy mennyiségű másolás-beillesztés található, akkor ne lepődjön meg, hogy idővel ezek az oldalak kieshetnek az indexből.

4. Spam jelenléte linkek formájában. Egyes webhelyeken az oldalak szó szerint túlterheltek Külső linkek. A webmester általában azért teszi közzé mindezt, hogy több pénzt keressen. A végeredmény azonban nagyon szomorú lehet – az oldal bizonyos oldalai és az egész oldal kikerülhet az indexből, vagy más szankciókat is kiszabhatnak.

5. Cikk mérete. Ha megnézed a webhelyed bármely oldalának forráskódját, láthatod, hogy maga a cikk szövege nem foglal sok helyet más elemek (fejléc, lábléc, oldalsáv, menü stb.) kódjához képest. Ha a cikk túl kicsi, akkor teljesen elveszhet a kódban. Ezért egy ilyen oldal egyediségével kapcsolatos problémák is felmerülhetnek. Ezért próbáljon meg legalább 2000 karakter hosszúságú jegyzeteket közzétenni, mert az ilyen tartalom valószínűleg nem okoz problémát.

Hogyan ellenőrizhető a webhely indexelése

Most beszéljünk arról, hogyan ellenőrizheti az internetes erőforrás indexelését, és megtudhatja, hogy pontosan hány oldal van indexelve.

1. Először is próbálja beírni a Google vagy a Yandex kifejezést egy egyszerű keresésbe. Az eredményeknek tartalmazniuk kell ezt az oldalt. Ha az oldal nem létezik, az azt jelenti, hogy nincs indexelve.

2. Az összes webhely oldalának indexelésének ellenőrzéséhez a Yandexben elegendő kereső sáv szúrja be a host:your-site.ru | host:www.your-site.ru és keressen. A Google esetében csak írja be a site:your-site.ru oldalt a keresési űrlapba

3. Webhelyét olyan szolgáltatással is ellenőrizheti, mint a pr-cy.ru. Itt minden egyszerűen és világosan van elrendezve. Csak meg kell adnia az erőforrás címét a központban található mezőben, majd kattintson az "Elemzés" gombra. Az elemzés után megkapja az ellenőrzés eredményeit, és megtudja, hogy egy adott keresőben hány oldal van indexelve (ezt megteheti a megfelelő "Webhely-mutatók" című szakaszban).

4. Ha webhelyét hozzáadták a Yandex Webmester szolgáltatáshoz, akkor ott is nyomon követheti a webhely oldalainak indexelését a keresőmotor által.

A népszerű SMF-motorra (www.simplemachines.org) épített látogatott fórumok tulajdonosai és adminisztrátorai előbb-utóbb elgondolkodnak azon, hogy a keresőmotorok indexeljék fórumukat. Azonban elég gyorsan meggyőződnek arról, hogy a „dobozból” telepített fórum nincs indexelve, vagy rosszul van indexelve. Mit kell tenni annak érdekében, hogy a fórum tartalma megfelelően legyen indexelve? Erről a Yandex példájával fogok beszélni.

Az indexelési folyamat Yandex általi nyomon követésének egyik fő eszköze a Yandex.Webmaster szolgáltatás. A szolgáltatás használatával hibákat láthatunk a fórum indexelési folyamatában. Ha egy új fórum telepítése után hozzáadjuk a Yandex.Webmasterhez, és megvárjuk az indexelést, látni fogjuk, hogy a fórum szinte minden oldala nem szerepelt az indexben. Ez azért történik, mert az SMF fejlesztői, akik láthatóan belefáradtak abba, hogy elmagyarázzák a felhasználóknak a fórum és a keresőmotorok közötti interakció bonyolultságát, egyszerűen hozzáadták a következő címkét az összes oldalhoz:

Ha egy keresőmotor ilyen címkével találkozik, nem indexeli ezt az oldalt. Javítsuk ki ezt a fájl módosításával index.template.php /Themes/default/index.template.php). Tapasztalatától függően a fenti sor a következőképpen eltávolítható vagy módosítható:

Ebben az esetben a szöveg és a hivatkozások is indexelve lesznek. A link indexelése befolyásolja az oldal súlyának átvitelét (Google PR vagy Yandex TIC) arra a webhelyre, amelyre a link található.

Most, hogy engedélyeztük a keresőmotoroknak, hogy információkat gyűjtsenek az indexhez a fórumunkból, meg kell győződnünk arról, hogy az index tartalmazza szükséges oldalakés nem kerültek bele feleslegesek. A lényeg, hogy a motor Fórum SMF, mint sok más, úgy van kialakítva, hogy ugyanaz az üzenet sokféleképpen olvasható legyen, és ezeket a módszereket ne tegye elérhetővé a keresők számára, mivel a keresők által az indexelés során létrehozott terhelés meghaladhatja a a tárhely, ahol a fórumot tárolod, arról nem is beszélve, hogy értelmetlen. Bezárni felesleges oldalakat a fórumon használjuk a fájlt robots.txt(Javaslom, nézd meg Általános leírása ezt a fájlt a robotstxt.org.ru webhelyen, valamint annak leírását, hogy a Yandex hogyan dolgozza fel ezt a fájlt: http://help.yandex.ru/webmaster/?id=996567). A webhely gyökerébe telepített fórum esetén ez a fájl így fog kinézni:

User-agent: *

Disallow: /*.msg

Disallow: /*.new

Disallow: /mellékletek/

Disallow: /avatars/

Disallow: /Csomagok/

Disallow: /Smileys/

Disallow: /források/

Disallow: /Témák/

Disallow: /Játékok/

Disallow: /*sort

Disallow: /*topicseen

Disallow: /*wap

Disallow: /*imode

Disallow: /*action

Ehhez a fájlhoz hozzáadhatja a szükséges direktívákat (a megfelelő gazdagép jelzése, más keresőmotorokra vonatkozó blokkok stb.). Annak ellenére, hogy a specifikáció szerint a „*”-hoz hasonló helyettesítő karakterek használata tilos, a keresők túlnyomó többsége helyesen értelmezi azokat, pl. Nem kell aggódni a szintaxis helyességéért.

Annak biztosítása érdekében, hogy a keresőmotorok megfelelően indexeljék a fórum minden üzenetét, a következőket tesszük:

1. Távolítsa el a témára mutató hivatkozást a témán belüli üzenetekből. Módosítania kell a fájlt

Display.template.php(az alapértelmezett témánál ez található /Themes/default/Display.template.php). A linket el kell távolítani mind a téma címéről, mind a mellette lévő képről. A módosítandó kód a következő sor után található:

// Kész a poszterrel kapcsolatos információkkal... magára a bejegyzésre.

2. Telepítsen egy modot a fórumhoz, amely lehetővé teszi az egyes üzenetek külön megtekintését: Egyetlen hozzászólás megtekintése.

Miután befejezte a fórumot a fenti módszerrel, várja meg, amíg a keresőmotorok befejezik az indexelést, és ellenőrizze, hogy nincsenek-e hibák (például a Yandex.Webmaster használatával).

Annak érdekében, hogy a fórumra mutató hivatkozások megjelenjenek a Yandex.Blog Search szolgáltatás keresési eredményei között, használjon egy speciális bővítményt ( Hivatalos oldal: http://nano.yandex.ru/project/yarss/ és az SMF 1.1.x verziója: http://www.likhachev.net/projects/yarss/), amely a szolgáltatáshoz szükséges formátumban biztosítja az RSS-t. A bővítmény telepítése után ne felejtse el hozzáadni a hírcsatornát a szolgáltatáshoz (ha még nem tette meg):

Több top oldal tartalomkezelőjével volt alkalmam kommunikálni. Nem tudtam ellenállni a kísértésnek, hogy megtudjam, milyen alapvető oldaloptimalizálási technikákat alkalmaznak a szakértők annak biztosítására, hogy a webhelyet jól indexeljék a keresők. Ezeket az ajánlásokat itt teszem közzé.

Szövegírással és oldalak összeállításával kapcsolatos szakértői tanácsok a keresőmotorok jobb indexeléséhez alapul személyes tapasztalatés a barátom által több éven át végzett kutatást, és megtanulta hatékonyan alkalmazni az ügyfelekkel való munka során.

Hangerő

Az 1000 karakternél rövidebb oldalak indexelése nagyon rossz, ezért ne legyen lusta, és írja le részletesebben termékét az oldalakon. Az ajánlott hossz szóközökkel együtt legfeljebb 1,5 ezer karakter.

Egyediség

A szövegnek egyedinek kell lennie. Az egyediség az Advego-ban vagy a content-watch.ru oldalon ellenőrizhető - 95% felett kell lennie. Ezek az eszközök nemcsak az egyediséget értékelik, hanem megjelenítik azokat a szövegrészeket is, amelyeket szerkeszteni kell, hogy az oldalak ne kerüljenek a kiegészítő listára, és ne kerüljenek vissza kérésre.

Szöveg szerkezete

- Közlemény. Egy kis bekezdés, amely leírja fő jelentését és célját. A bejelentés megvan nagyon fontos: először is, miután elolvasta, az embernek érdeklődnie kell a termék iránt, és el kell mennie Teljes leírás; másodszor, a Yandex létrehoz egy részletet a szöveg elejéről. Esetünkben ez a bejelentés.

- Alapvető leírás. Az első bekezdésnek mélyebben fel kell fednie a termék lényegét, jellemzőit és célját. Az első bekezdésnek kulcsszóval kell kezdődnie. Ezután írhat a jellemzőkről, és felsorolhatja a jellemzőket és részleteket. A második bekezdésnek tartalmaznia kell egy kulcskifejezést. Használjon magas frekvenciájú billentyűket a szöveg elején.- tovább csökkenő sorrendben.

- Rövid leírás terméklista. Legfeljebb 5 pozíció.

- A fő leírás folytatása. Célszerű nyilvánosságra hozni megkülönböztető jellegzetességek versenytársakkal és piaci pozícióval összehasonlítva.

- Következtetés- kinek és miért ajánljuk a termék használatát. Az utolsó bekezdésben, lehetőleg az utolsó mondatban, kulcsmondatot kell tartalmaznia.

A SEO leírása

Nem haladhatja meg a 140 karaktert. Fel kell fednie a termék jelentését, amely kivonatként jelenik meg a Google-ban. Ügyeljen arra, hogy egy jó kulcsot használjon.

Kulcsok

A használt kulcsok SEO egyenletesen el kell oszlani a szövegben tetszőleges sorrendben. Érdemes a kulcsszavakat félkövérrel kiemelni.

Passzusok a Yandex

A szövegeket úgy állítsa össze, hogy egy mondaton belül, amely nincs címkékkel elválasztva, ott legyenek kulcs kifejezések a Yandex lehetséges lekérdezéseiből. Maga a kifejezés más szavakkal is hígítható, ez nem károsítja a keresési eredményeket.

Példa a kifejezésre: „Szállítás Dnyipropetrovszkba”

Szöveglehetőségek: „...megszervezi a kiszállítást Dnyipropetrovszk városába...” vagy „Szállítás Ukrajna városaiba lehetséges: Dnyipropetrovszk, Harkov, Zaporozsje...”

A tulajdonosnak egyszerűen meg kell várnia azt a pillanatot, amikor a keresőrobot bejön és indexeli az oldalát.

Hogyan lehet javítani a webhelyindexelést a Yandexben és a Google-ban

Azok, akik önállóan készítenek weboldalt, egy kézenfekvőnek tűnő kérdéssel szembesülnek: hogyan adhatjuk hozzá erőforrásunkat egy adott rendszer keresési eredményeihez egy adott kérés esetén? A válasz egyszerű: a tulajdonosnak egyszerűen meg kell várnia azt a pillanatot, amikor bejön a keresőrobot, és indexeli webhelye oldalát.

Amint az erőforrás oldalai szerepelnek a keresőmotor indexében, megjelennek a keresési eredmények között.

A legtöbb webmester számára ez a probléma nem komoly. Oldalaik terjedelme nem haladja meg a több száz oldalt, és a keresőrobot gyakran helyesen indexeli a tartalmat. A SEO optimalizálás során azonban érdemes több fontos tényezőre is odafigyelni.

Általában a két indexelési módszer egyikét használják:

Az első az, hogy a tulajdonos maga adja hozzá a webhely címét egy speciális mezőhöz, amely a keresőmotor webmesteri paneljén jelenik meg. Ebben az esetben a keresőmotor értesítést kap arról, hogy egy új webhelyet még nem indexeltek. Prioritási sorrendben a robot minden ilyen erőforrást felkeres és indexeli.

A megfelelő indexeléshez elég csak a főoldalt feltüntetni, a többit az oldaltérképnek köszönhetően megtalálja a robot. Ön is feltölti az oldaltérképet. Az interneten számos webhely és program található, amelyek ingyenesen generálnak egy térképet .xml vagy .html formátumban.

A második módszer az, hogy a robot maga keresi az Ön webhelyét. Felmerülhet a kérdés: hogyan csinálja ezt? A helyzet az, hogy egy adott erőforrás indexelésekor a robot ellenőrzi a hozzájuk küldött hivatkozásokat. Ez azt jelenti, hogy ha webhelyén már van egy hivatkozás valamilyen erőforráson, amelyet például a Yandex indexelt, akkor maga a keresőrobot rövid időn belül felkeresi az erőforrást, és indexeli. A tapasztalt webmesterek úgy vélik, hogy ez a lehetőség sokkal kedvezőbb hatással van az oldal keresési eredményeire. Ehhez be kell szereznie (vagy meg kell vásárolnia) több linket, és meg kell várnia a robot érkezését.

Természetesen szeretné minél hamarabb látni az oldalát a keresőoldalakon! A robot általában két hetet meg nem haladó időtartamon belül indexeli az oldalakat. Minden attól függ, mennyire elfoglalt a kereső. Indexelés szempontjából a leggyorsabb robot a Google-tól. Néhány órával a kézi bevitel után a robot elkezdi a beolvasást.

A robot a weboldal-fejlesztőkhöz hasonlóan nem szereti a bonyolult kódokat. A legsikeresebb indexelés érdekében azt tanácsolom, hogy a lehető legnagyobb mértékben egyszerűsítse le, és tartsa be a következő szabályokat:

- Először is, az összes oldalhoz való hozzáférés legfeljebb 3 kattintás lehet, attól számítva kezdőlap. Ha ez nem lehetséges, hozzon létre egy webhelytérképet. Ez segít a robotnak eligazodni a "dzsungelben".

- Másodszor, legyen óvatos, amikor szkriptekkel dolgozik. A keresőrobotok nem tudják, hogyan ismerjék fel őket. Szkriptes navigáció használatakor ügyeljen a hivatkozások megkettőzésére!

- Harmadszor, ne hagyja figyelmen kívül azt a tényt, hogy a keresőrobotok legfeljebb 200 kb szöveget indexelnek. Ha Önnek fontos, hogy a teljes oldal indexelve legyen, ne legyen 100 kb-nál nagyobb.

A keresőrobotoknak van speciális fájl, a tárhely gyökérjében tárolva. Ez az úgynevezett robots.txt. Segítségével vezérelheti a keresőrobotot, például blokkolhatja vagy engedélyezheti a különböző oldalak indexelését.

A külföldi keresőrobotokkal ellentétben az oroszok megértik a címkét

< NOINDEX>

Ez lehetővé teszi az oldal bizonyos részei elrejtését a robot elől. Az indexelés lehetőségének teljes kizárása érdekében ezt a címkét az oldal HEAD részében kell elhelyezni.

Abból való kizárás érdekében Keresési eredmények elavult erőforrásokat frissek helyett, a keresőmotorok valósítanak meg. Az adatbázisban lévő rekordok folyamatosan frissülnek. Nem kell riadót fújni, ha az indexelt oldalak száma hirtelen megváltozik.

Gondosan válassza ki a tárhelyet. Ha webhelye gyakran összeomlik, ez akadályozza az indexelési folyamatot. A robot egyszerűen nem fér hozzá az erőforráshoz! Éppen ezért óvatosan kell megközelítenie a tárhely kiválasztását. Ne hagyja figyelmen kívül a külső hivatkozásokat. Jótékony hatással vannak webhelye újraindexelésére.

A szerver naplófájljainak elemzésével információkat kap az indexelési folyamatról.

sushiandbox.ru A számítógép elsajátítása - Internet. Skype. Közösségi média. Windows leckék.

sushiandbox.ru A számítógép elsajátítása - Internet. Skype. Közösségi média. Windows leckék.