Ha problémák vannak az indexeléssel, először is ellenőriznie kell a robots.txt és a sitemap.xml fájlt.

Bármely keresőmotor rendelkezik egy terjedelmes adatbázissal, amelybe az összes webhelyet és új oldalakat beírják. Ezt az alapot "indexnek" nevezik. Amíg a robot megkerüli a html dokumentumot, nem elemzi és nem adja hozzá az indexhez, addig nem jelenik meg a keresési eredmények között. Csak a linken keresztül érhető el.

Mit jelent az "indexelés"?

Jobban, mint a Yandex indexelő szakembere, senki sem fog erről beszélni:

Az indexelés egy olyan folyamat, amelynek során a keresőrobot megkerüli a webhely oldalait, és beilleszti (vagy nem tartalmazza) ezeket az oldalakat a keresőmotor indexébe. A keresőbot átvizsgálja az összes tartalmat, szemantikai elemzést végez a szöveges tartalomról, a hivatkozások minőségéről, az audio- és videofájlokról. Mindezek alapján a kereső következtetéseket von le, és rangsorolással teszi az oldalt.

Amíg az oldal kikerül az indexből, senki nem fog tudni róla, kivéve azok, akiknek közvetlen linkeket lehet terjeszteni. Vagyis az erőforrás megtekinthető, de nincs a keresőben.

Mire való az index?

Az oldalnak láthatóvá kell válnia a fejlődés, a növekedés és a fejlődés érdekében. Azok a webes források, amelyek egyetlen PS-ben sem jelennek meg, haszontalanok, és nem használnak sem a felhasználóknak, sem a tulajdonosának.

Általánosságban elmondható, hogy itt van a Yandex webmesterek iskolájának teljes videója, ha teljesen megnézi, gyakorlatilag az indexelés kérdésének szakértője lesz:

Mi határozza meg az indexelés sebességét

A főbb pontok, amelyek meghatározzák, hogy webhelye milyen gyorsan kerülhet a keresőrobotok figyelmébe:

- Domain életkora (az idősebb Domain név, annál több bot kedvez neki).

- Tárhely (PS egyáltalán nem szeretik, és gyakran figyelmen kívül hagyják az ingyenes tárhelyet).

- CMS, a kód tisztasága és érvényessége.

- Oldal frissítési gyakorisága.

Mi az a feltérképezési költségkeret

Minden webhelynek van egy feltérképezési költségkerete – vagyis az oldalak száma, amelynél több nem kerülhet be az indexbe. Ha az oldal KB 1000 oldal, akkor még ha tízezer oldal is van, akkor is csak ezer lesz az indexben. A költségkeret nagysága attól függ, hogy webhelye mennyire hiteles és hasznos. És ha olyan jellegű problémája van, hogy az oldalak nem kerülnek be az indexbe, akkor lehetőségként, bármilyen elcsépeltnek is hangzik, javítania kell az oldalt!

Webhelyindexelés

Új webhely létrehozásakor helyesen kell kitöltenie a robots.txt fájlt, amely megmondja a keresőmotoroknak, hogy az erőforrás indexelhető-e, mely oldalakat kell feltérképezni és melyeket nem.

A fájl txt formátumban jön létre, és a webhely gyökérmappájába kerül. A megfelelő robotok egy külön kérdés. Ez a fájl elsősorban azt határozza meg, hogy a robotok mit és hogyan fognak elemezni az Ön webhelyén.

Általában néhány héttől néhány hónapig tart, amíg a keresőmotorok kiértékelnek egy új webhelyet és beírják az adatbázisba.

A pókok gondosan átvizsgálnak minden engedélyezett html dokumentumot, és meghatározzák a megfelelő témát egy új, fiatal forrás számára. Ezt a műveletet nem egy nap alatt hajtják végre. Minden új bypass-szal a PS egyre nagyobb mértékben járul hozzá több html dokumentumokat az adatbázisába. Sőt, időről időre a tartalom újraértékelésre kerül, aminek következtében az oldalak helye a keresési eredmények között változhat.

A robots metatag és bizonyos mértékig a canonical is segít az indexelés kezelésében. A struktúra ellenőrzése és az indexelési problémák megoldása során mindig meg kell keresni a jelenlétüket.

A Google először a legfelső szintű oldalakat indexeli. Ha egy új webhelyet, meghatározott szerkezettel indexelni kell, először a főoldalt kell indexelni. Ezt követően az oldal szerkezetének ismerete nélkül a kereső azt indexeli, ami közelebb van a perjelhez. A későbbi két perjellel rendelkező könyvtárak indexelésre kerülnek. Ez azt jelenti, hogy még ha a tartalomban található linkek magasak is, nem feltétlenül indexeljük őket először. Fontos az optimális felépítés, hogy a fontos részek ne maradjanak sok perjel mögött, különben a Google alacsony szintű oldalnak fogja gondolni.

Oldalindexelés

Amikor a Yandex és a Google már megismerkedett az oldallal és "elfogadta" azt a keresőbázisába, a robotok visszatérnek az erőforráshoz, hogy új, hozzáadott anyagokat térképezzenek fel. Minél gyakrabban és rendszeresen frissítik a tartalmat, a pókok annál jobban követik azt.

Azt mondják, hogy a PDS pinger plugin a Yandex kereséshez segít az indexelésben - https://site.yandex.ru/cms-plugins/. Ehhez először telepítenie kell a Yandex keresést a webhelyére. De nem éreztem sok hasznot belőle.

Ha jól indexelt az erőforrás, már sokkal könnyebben lehet külön, új oldalakat megjeleníteni a keresésben. Ennek ellenére az elemzés nem mindig történik egyenletesen és azonos sebességgel minden egyidejűleg frissített html dokumentum esetében. Mindig a leglátogatottabb és legnépszerűbb forráskategóriák nyernek.

Milyen információforrásokkal rendelkeznek a keresőmotorok az URL-ekről?

Réges-régen egy versenytárshoz vonzottam egy gyors robotot, aki nem újította meg a domaint, hogy lejjebb kerüljön a keresési eredmények között - ez nem hozott eredményt.

Hogyan ellenőrizhető az indexelés

Láthatósági ellenőrzés html dokumentumokat másként hajtják végre a Google és a Yandex esetében. De általában semmi bonyolult. Még egy kezdő is meg tudja csinálni.

Ellenőrzés a Yandexben

A rendszer három fő operátort kínál annak ellenőrzésére, hogy hány html dokumentum van az indexben.

A "site:" operátor abszolút az erőforrás összes olyan oldalát mutatja, amely már belépett az adatbázisba.

A keresősávba így írták be: site:site

Operator "host:" - lehetővé teszi a tárhelyen belüli domainek és aldomainek indexelt oldalainak megtekintését.

A keresősávba a következőképpen írták be: host:site

Az "url:" operátor a kért oldalt mutatja.

Beírva a keresősávba a következőképpen: url:site/obo-mne

Az indexelés ellenőrzése ezekkel a parancsokkal mindig pontos eredményt ad, és ez a legtöbb egyszerű módon erőforrás láthatósági elemzés.

Google ellenőrzés

PS A Google lehetővé teszi egy webhely láthatóságának ellenőrzését a site:site űrlap egyetlen parancsával.

De a Google-nek van egy sajátossága: másképp kezeli a parancsot a www-vel és anélkül. A Yandex viszont nem tesz ekkora különbséget, és pontosan ugyanazt az eredményt adja, www-vel és anélkül is.

Az operátorok általi ellenőrzés a leginkább „régimódi” módszer, de erre a célra az RDS Bar böngésző plugint használom.

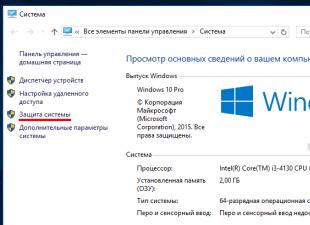

Ellenőrzés a webmesterrel

A Google Webmaster és a Yandex Webmaster szolgáltatásokban azt is megnézheti, hogy hány oldal van a PS-adatbázisban. Ehhez regisztrálnia kell ezekben a rendszerekben, és hozzá kell adnia webhelyét hozzájuk. Ezeket az alábbi linkeken érheti el:

A lényeg a következő: csak írja be az oldalak címeit, és a szolgáltatás megadja az eredményeket:

Nem ellenőrzi túl gyorsan - ott 3 percet kell várnia, de kevés panasz van az ingyenes eszközre. Csak helyezze be a háttérablakba, és folytassa a dolgát, és néhány percen belül készen lesz az eredmény.

Fel lehet gyorsítani az indexelést?

Befolyásolhatja a html dokumentumok keresőrobotok általi betöltésének sebességét. Ehhez kövesse az alábbi ajánlásokat:

- Növelje a közösségi jelzések számát azáltal, hogy arra ösztönzi a felhasználókat, hogy osszák meg a linkeket a profiljukban. És fogadhat tweeteket a Prospero (klout 50+) élő fiókjaiból. Ha felveszi a twitterek fehérlistáját, tekintse meg, hogy megkapta erős fegyver az indexelés felgyorsítása;

- Gyakrabban adjon hozzá új anyagokat;

- Elkezdheti használni a legolcsóbb közvetlen lekérdezéseket a tárgyban;

- Adja meg a címet új oldal addurilkiben közvetlenül a megjelenés után.

Magas viselkedési tényezők az oldalon is pozitív hatással vannak az oldalak frissítési sebességére a keresésben. Ezért ne feledkezzünk meg a tartalom minőségéről és hasznosságáról az emberek számára. A felhasználóknak igazán tetsző oldalak biztosan tetszeni fognak a keresőrobotoknak.

Általánosságban elmondható, hogy a Google-ban minden nagyon egyszerű - néhány percen belül hozzáadhat egy oldalt az indexhez a webmesteri panelen végzett szkenneléssel (elem Vizsgálat / nézze meg, hogyan Googlebot / hozzáadása az indexhez). Ugyanígy gyorsan újraindexelheti a szükséges oldalakat.

Több történetet is hallottam azokról a haverokról, akik Yandex-mailben küldtek URL-eket, hogy gyorsabban bekerüljenek az indexbe. Véleményem szerint ez nonszensz.

Ha közvetlen probléma van, és az előző tippek nem segítettek, akkor tovább kell lépni a nehéztüzérségre.

- Állítsa be az Utolsó módosítás fejléceit (hogy a robot csak a legutóbbi hívás óta valóban megváltozott dokumentumokat ellenőrizze a frissítéseket);

- Szemét eltávolítása az indexből kereső motorok(ezt a szemetet a Comparser segítségével lehet megtalálni);

- Minden felesleges/szemét dokumentumot elrejtünk a robot elől;

- Csinál további fájlok Sitemap.xml Általában a robotok akár 50 000 oldalt is beolvasnak ebből a fájlból, ha több oldala van, több oldaltérképet kell készítenie;

- A szerver beállítása.

Mi az indexelés? Ez az a folyamat, amellyel webhelye oldalainak tartalma eljut a robothoz, és bekerül a keresési eredmények közé. Ha rátérünk a számokra, akkor az indexelő robot adatbázisa több billió oldalcímet tartalmaz. A robot naponta több milliárd ilyen címet kér le.

De az internet indexelésének ez az egész nagy folyamata apró lépésekre osztható:

Először is, az indexelő robotnak tudnia kell, hogy mikor jelent meg egy oldal a webhelyén. Például más oldalak indexelésével az interneten, hivatkozások keresésével vagy a beállított nemp letöltésével. Megtudtuk az oldalt, ami után azt tervezzük, hogy megkerüljük ezt az oldalt, adatokat küldünk a szerverére, hogy lekérjük az oldal ezen oldalát, megszerezzük a tartalmat és bekerüljük a keresési eredmények közé.

Ez az egész folyamat az indexelő robot és a webhely cseréje. Ha az indexelő robot által küldött kérések gyakorlatilag nem változnak, és csak az oldal címe változik, akkor a szerver válasza a robot oldalkérésére számos tényezőtől függ:

- a CMS beállításaiból;

- a tárhelyszolgáltató beállításaiból;

- egy köztes szolgáltató munkájából.

Ez a válasz változik. Először is, amikor oldalt kér, a robot a következő szolgáltatási választ kapja az Ön webhelyéről:

Ezek HTTP-fejlécek. Különféle szolgáltatási információkat tartalmaznak, amelyek egyértelművé teszik a robot számára, hogy most milyen tartalom kerül továbbításra.

Az első fejlécre szeretnék összpontosítani – ez egy HTTP-válaszkód, amely jelzi az indexelő robotnak a robot által kért oldal állapotát.

A HTTP-kódoknak több tucat ilyen állapota létezik:

A legnépszerűbbekről fogok beszélni. A leggyakoribb válaszkód a HTTP-200. Az oldal elérhető, indexelhető, bekerülhet a találatok közé, minden rendben.

Ennek az állapotnak az ellenkezője a HTTP-404. Hiányzik az oldal az oldalról, nincs mit indexelni, nincs mit beletenni a keresésbe sem. A webhelyek szerkezetének megváltoztatásakor és a címek megváltoztatásakor belső oldalak javasoljuk, hogy állítson be egy 301-es szervert az átirányításhoz. Csak rá fogja mutatni a robotnak régi oldalúj címre költözött, és szerepelnie kell Keresési eredmények az új címet.

Ha az oldal tartalma nem változott azóta, hogy a robot utoljára felkereste az oldalt, a legjobb, ha HTTP-304 kódot küld vissza. A robot megérti, hogy nem szükséges frissíteni az oldalt a keresési eredmények között, és a tartalom sem kerül átvitelre.

Ha webhelye rövid ideig elérhető, például amikor valamilyen munkát végez a szerveren, a legjobb a HTTP-503 konfigurálása. Jelzi a robotnak, hogy az oldal és a szerver most nem elérhető, kicsit később kell mennie. Rövid távú elérhetetlenség esetén ez megakadályozza az oldalak kizárását a keresési eredmények közül.

Ezeken a HTTP-kódokon, oldalállapotokon kívül magának az oldalnak a tartalmát is közvetlenül meg kell szereznie. Ha egy normál látogató számára az oldal így néz ki:

ezek képek, szöveg, navigáció, minden nagyon szép, akkor az indexelő robot számára bármelyik oldal csak egy forráskód, HTML kód halmaza:

Különféle meta tagek, szöveges tartalom, linkek, szkriptek, sok információ. A robot összegyűjti és beviszi a keresési eredmények közé. Úgy tűnik, minden egyszerű, oldalt kértek - megkapták a státuszt, megkapták a tartalmat, bekerültek a keresésbe.

De nem ok nélkül a szolgáltatásban kereső szolgáltatás A Yandex több mint 500 levelet kap webmesterektől és webhelytulajdonosoktól, amelyekben azt állítják, hogy bizonyos problémák merültek fel a szerver válaszával.

Mindezek a problémák két részre oszthatók:

Ezek a HTTP-válaszkóddal és a HTML-kóddal, az oldalak közvetlen tartalmával kapcsolatos problémák. Ezeknek a problémáknak számos oka lehet. A leggyakoribb az indexelő robot letiltása a tárhelyszolgáltató által.

Például elindított egy webhelyet, hozzáadta új szakasz. A robot gyakrabban kezdi felkeresni az Ön oldalát, növeli a szerver terhelését. A tárhelyszolgáltató ezt látja a megfigyelésén, blokkolja az indexelő robotot, és ezért a robot nem tud hozzáférni az Ön webhelyéhez. Megy az erőforráshoz - minden rendben van, minden működik, az oldalak gyönyörűek, minden megnyílik, minden szuper, a robot nem tudja egyszerre indexelni az oldalt. Ha az oldal átmenetileg nem elérhető, például ha elfelejtett fizetni a domain névért, az oldal néhány napig le lesz tiltva. A robot az oldalra érkezik, nem elérhető, ilyen feltételek mellett egy idő után szó szerint eltűnhet a keresési eredmények közül.

Helytelen CMS beállítások, például frissítéskor vagy másik CMS-re váltáskor, a dizájn frissítésekor azt is okozhatják, hogy az oldalad oldalai eltűnnek a keresési eredmények közül, ha a beállítások nem megfelelőek. Például egy tiltó metacímke jelenléte a webhely oldalainak forráskódjában, a kanonikus attribútum helytelen beállítása. Ellenőrizze, hogy a webhelyen végzett összes módosítás után az oldalak elérhetőek-e a robot számára.

A Yandex eszköze segít ebben. Webmester a szerver válaszának ellenőrzéséhez:

Láthatja, hogy a szerver milyen HTTP-fejléceket küld vissza a robotnak, közvetlenül az oldalak tartalmát.

Az "indexelés" rész statisztikát tartalmaz, ahol megtekintheti, hogy mely oldalak kerültek kizárásra, ezen mutatók változásának dinamikája, valamint különféle rendezések és szűrések.

Ezenkívül ma erről a szakaszról, a „helyi diagnosztika” szakaszról beszéltem. Ha webhelye elérhetetlenné válik a robot számára, értesítést és ajánlásokat fog kapni. Hogyan lehet ezt korrigálni? Ha nincs ilyen probléma, az oldal elérhető, válaszol a 200-as kódokra, megfelelő tartalmat tartalmaz, akkor a robot elindul automatikus üzemmód keresse fel az összes általa felismert oldalt. Ez nem mindig vezet a kívánt következményekhez, így a robot tevékenysége bizonyos módon korlátozható. Ehhez létezik egy robots.txt fájl. A következő részben beszélünk róla.

Robots.txt

Maga a robots.txt fájl kicsi Szöveges dokumentum, az oldal gyökérmappájában fekszik, és szigorú szabályokat tartalmaz az indexelő robotra vonatkozóan, amelyeket be kell tartani az oldal feltérképezésekor. A robots.txt fájl előnye, hogy nem igényel speciális és speciális ismereteket a használatához.

Elég megnyitni a Jegyzettömböt, megadni bizonyos formátumszabályokat, majd egyszerűen elmenteni a fájlt a szerverre. A nap folyamán a robot elkezdi használni ezeket a szabályokat.

Ha példát veszünk egy egyszerű robots.txt fájlra, akkor itt van, csak a következő dián:

A User-Agent:” direktíva megmutatja, hogy mely robotokra vonatkozik a szabály, az engedélyezési/megtagadási direktívák, valamint a Sitemap és Host segéddirektívák. Egy kis elmélet, szeretnék áttérni a gyakorlatra.

Néhány hónapja lépésszámlálót akartam venni, ezért a Yandexhez fordultam. Keressen segítséget a választáshoz. Elköltözött innen kezdőlap Yandex a Yandex. Market és a szolgáltatás főoldalára került.

Lent láthatod annak az oldalnak a címét, ahova jártam. Magának a szolgáltatásnak a címéhez az én, mint felhasználó azonosítója is hozzáadásra került.

Aztán átmentem a "katalógus" részre

Kiválasztotta a kívánt alrészt, és beállította a rendezési lehetőségeket, árat, szűrőt, rendezési módot, gyártót.

Megkaptam a termékek listáját, és az oldal címe már nőtt.

Odamentem a kívánt termékhez, rákattintottam a „kosárba” gombra és folytattam a pénztárat.

Rövid utazásom során az oldalcímek bizonyos módon megváltoztak.

Szolgáltatási paraméterek kerültek hozzájuk, amelyek felhasználóként azonosítottak, rendezést állítottak be, jelezték az oldal tulajdonosának, hogy honnan mentem az oldal erre vagy arra az oldalára.

Az ilyen oldalak, szerviz oldalak szerintem nem nagyon fogják érdekelni a keresőket használókat. De ha az indexelő robot rendelkezésére állnak, akkor bekerülhetnek a keresésbe, mert a robot valójában felhasználóként viselkedik.

Felmegy egy oldalra, meglát egy hivatkozást, amelyre rákattinthat, rámegy, betölti az adatokat a robot adatbázisába, és folytatja az egész oldal megkerülését. Az ilyen címek azonos kategóriájába tartozhatnak a felhasználók személyes adatai is, például szállítási információk, vagy a felhasználók elérhetőségei.

Természetesen jobb, ha betiltjuk őket. Csak ebben segít a robots.txt fájl. Ma este a Webmester befejezése után felkeresheti az oldalát, kattintson, nézze meg, mely oldalak valóban elérhetők.

A robots.txt ellenőrzéséhez van egy speciális eszköz a Webmesterben:

Letöltheti, beírhatja az oldalcímeket, megnézheti, hogy elérhetők-e a robot számára vagy sem.

Végezzen néhány változtatást, és nézze meg, hogyan reagál a robot ezekre a változásokra.

Hibák a robots.txt fájl használatakor

Az ilyen pozitív hatáson kívül – a szolgáltatási oldalak bezárása mellett – a robots.txt, ha rosszul kezelik, kegyetlen tréfát is játszhat.

Először is, a robots.txt használatakor a leggyakoribb probléma a webhely azon oldalainak bezárása, amelyekre valóban szükség van, azokat, amelyeknek a keresésben kell lenniük és a kérésekre meg kell jelenniük. Mielőtt módosítaná a robots.txt fájlt, győződjön meg arról, hogy a bezárni kívánt oldal nem vesz-e részt a keresésben, és megjelenik-e a keresési lekérdezések során. Lehet, hogy egy bizonyos paraméterekkel rendelkező oldal szerepel a keresési eredmények között, és a látogatók a keresésből érkeznek rá. Ezért a robots.txt használata és módosítása előtt feltétlenül ellenőrizze.

Másodszor, ha a webhelyén cirill betűs címeket használnak, akkor ezeket nem tudja közvetlenül megadni a robots.txt fájlban, ezeket kódolni kell. Mivel a robots.txt egy nemzetközi szabvány, minden indexelő robot ezt követi, ezért mindenképpen kódolni kell. A cirill ábécé nem adható meg kifejezetten.

A harmadik legnépszerűbb probléma a különböző keresőmotorok különböző robotjaira vonatkozó eltérő szabályok. Az egyik indexelő robotnál az összes indexelő oldal be volt zárva, a másodiknál pedig semmi sem. Ennek eredményeként minden rendben van egy keresőben, a keresésben kívánt oldalt, egy másik keresőben pedig lehet kuka, különféle szemetes oldalak, valami más. Mindenképpen kövesse, ha tiltást állít be, azt minden indexelő robotnál meg kell tenni.

A negyedik leggyakoribb probléma a Crawl-delay direktíva használata, amikor nem szükséges. Ez az utasítás lehetővé teszi, hogy befolyásolja a lekérdezések tisztaságát az indexelő robot részéről. Ez gyakorlati példa, egy kis oldal, egy kis tárhelyre helyeztem, minden rendben van. tette hozzá nagy katalógus, jött a robot, látott egy csomó új oldalt, gyakrabban kezd hozzáférni az oldalhoz, növeli a terhelést, letölti és az oldal elérhetetlenné válik. Beállítjuk a Crawl-delay direktívát, a robot ezt látja, csökkenti a terhelést, minden rendben, az oldal működik, minden tökéletesen indexelve van, a keresési eredmények között van. Egy idő után a webhely még tovább növekszik, átkerül egy új tárhelyre, amely készen áll ezeknek a kéréseknek a kezelésére, nagy számú kéréssel, és a feltérképezés késleltetési direktíváját elfelejtik eltávolítani. Ennek eredményeként a robot megérti, hogy sok oldal jelent meg az Ön webhelyén, de egyszerűen az utasításkészlet miatt nem tudja őket indexelni. Ha valaha is használta a Crawl-delay direktívát, ellenőrizze, hogy ez most megszűnt-e, és hogy a szolgáltatása készen áll-e az indexelő robot terhelésének kezelésére.

A leírt funkciókon kívül a robots.txt fájl két nagyon fontos feladat megoldását is lehetővé teszi - megszabadulni a duplikátumoktól a webhelyen, és megadni a fő tükör címét. Pontosan erről lesz szó a következő részben.

Dupla

Az ismétlődések alatt ugyanazon webhely több olyan oldalát értjük, amelyek teljesen azonos tartalmat tartalmaznak. A leggyakoribb példa az oldalak perjellel a cím végén vagy anélkül. A másodpéldány ugyanazt a terméket is felfoghatja különböző kategóriákban.

Például a görkorcsolya lehet lányoknak, fiúknak ugyanaz a modell lehet egyszerre két szekcióban. És harmadszor, ezek jelentéktelen paraméterekkel rendelkező oldalak. Mint a Yandex példájában. Marketingesítse ezt az oldalt "munkamenet azonosító", ez a paraméter elvileg nem változtatja meg az oldal tartalmát.

Az ismétlődések észleléséhez nézze meg, hogy a robot mely oldalakhoz fér hozzá, használhatja a Yandexet. Webmester.

A statisztikákon kívül a robot által betöltött oldalak címei is megtalálhatók. Látja a kódot és az utolsó hívást.

Problémát a duplikációk okoztak

Miért rosszak a másolatok?

Először is, a robot elkezd hozzáférni a webhely teljesen azonos oldalaihoz, ami további terhelést okoz nemcsak a szerverén, hanem a webhely egészének megkerülésére is hatással van. A robot a duplikált oldalakra kezd figyelni, nem pedig azokra az oldalakra, amelyeket indexelni kell és szerepeltetni kell a keresési eredményekben.

A második probléma, hogy a duplikált oldalak, ha elérhetők a robot számára, bekerülhetnek a keresési eredmények közé, és felvehetik a versenyt a főoldalakkal a lekérdezésekért, ami természetesen negatívan befolyásolhatja bizonyos lekérdezések esetén a megtalált oldalt.

Hogyan kezelheti a duplikációkat?

Először is azt tanácsolom, hogy használja a „canonical” címkét annak érdekében, hogy a robot a fő, kanonikus oldalra mutasson, amelyet indexelni kell, és a lekérdezések keresésében kell lennie.

A második esetben 301-es szerver-átirányításokat használhat, például olyan helyzetekben, amikor a cím végén perjel van, és perjel nélkül. Átirányítás telepítve – nincsenek ismétlődések.

Harmadszor pedig, ahogy mondtam, ez a robots.txt fájl. Mind a disable direktívák, mind a Clean-param direktíva segítségével megszabadulhat a lényegtelen paraméterektől.

Helyszíntükrök

A második feladat, amelyet a robots.txt lehetővé tesz, hogy a robotot a főtükör címére irányítsa.

A tükrök olyan webhelyek csoportja, amelyek teljesen azonosak, mint az ismétlődések, csak két különböző webhely. A webmesterek általában két esetben találkoznak tükrökkel – amikor új tartományra szeretnének költözni, vagy amikor a felhasználónak több webhelycímet kell elérhetővé tennie.

Tudja például, hogy a felhasználók, amikor beírják az Ön címét, beírják a webhely címét címsor, gyakran elkövetik ugyanazt a hibát – le vannak pecsételve, rossz karaktert tesznek fel, vagy valami mást. Vásárolhat további domaint, hogy a felhasználóknak ne egy tárhelyszolgáltatótól származó csonkot jelenítsen meg, hanem azt a webhelyet, amelyre valóban fel akartak menni.

Maradjunk az első pontnál, mert a tükrökkel végzett munka során leggyakrabban vele merülnek fel problémák.

Azt tanácsolom, hogy végezze el a teljes költözési folyamatot következő utasítás. Egy kis útmutató, amely segít elkerülni különféle problémákúj domain névre költözéskor:

Először is elérhetővé kell tenni az oldalakat az indexelő robot számára, és teljesen azonos tartalmat kell elhelyezni rajtuk. Győződjön meg arról is, hogy a robot tud a webhelyek létezéséről. A legegyszerűbb módja, ha hozzáadja őket a Yandexhez. Webmester, és erősítse meg a hozzájuk fűződő jogokat.

Másodszor, a Host direktíva használatával irányítsa a robotot a fő tükör címére - arra, amelyet indexelni kell, és a keresési eredmények között kell lennie.

Várjuk az összes mutató ragasztását, áthelyezését a régi telephelyről az újra.

Ezt követően már beállíthat egy átirányítást a régi címről az újra. Egyszerű utasítások, ha költözik, feltétlenül használja. Remélem nincs gond vele

mozgó.

De természetesen hibák fordulnak elő a tükrökkel való munka során.

Mindenekelőtt a fő probléma az, hogy az indexelő robotnak nincsenek kifejezett utasításai a fő tükör címére, arra a címre, amelynek szerepelnie kell a keresésben. Ellenőrizze webhelyein, hogy van-e host direktíva a robots.txt fájlban, és az arra a címre vezet, amelyet látni szeretne a keresésben.

A második leggyakoribb probléma az átirányítás használata a tükör meglévő csoportjában a főtükör megváltoztatására. Mi történik? A régi címet, mivel átirányít, a robot nem indexeli, kihagyja a keresési eredmények közül. Ugyanakkor az új oldal nem kerül be a keresésbe, mert nem főtükör. Forgalmat veszít, látogatókat veszít, szerintem ez senkinek sem kell.

A harmadik probléma pedig az egyik tükör elérhetetlensége mozgás közben. A leggyakoribb példa erre az esetre, amikor az oldal tartalmát egy új címre másolták, és a régi címet egyszerűen letiltották, a domain névért nem fizettek, és elérhetetlenné vált. Az ilyen oldalak természetesen nem lesznek ragasztva, elérhetőnek kell lenniük az indexelő robot számára.

Hasznos linkek működés közben:

- Több hasznos információ megtalálja a Yandex.Help szolgáltatásban.

- Minden eszköz, amelyről beszéltem, és még több - létezik a Yandex.Webmaster béta verziója.

Válaszok kérdésekre

Köszönöm a beszámolót. Be kell zárnom a CSS-fájlok indexelését a robots.txt fájlban, vagy sem?

Jelenleg nem javasoljuk ezek bezárását. Igen, jobb elhagyni a CSS-t, JavaScriptet, mert most azon dolgozunk, hogy az indexelő robot felismerje az oldaladon lévő szkripteket és a stílusokat is, úgy lássa, mint egy látogató egy normál böngészőből.

"Mondd meg, ha a webhelycímek URL-jei megegyeznek a réginél és az újnál, ez normális?".

Rendben van. Valójában csak frissíteni kell a dizájnt, hozzáadni egy kis tartalmat.

„Az oldalnak van kategóriája, és több oldalból áll: perjel, 1. oldal, 2. oldal, például 10-ig. Minden oldalon egy kategóriájú szöveg található, és az ismétlődőnek bizonyul. Ez a szöveg másodpéldány lesz, vagy le kell zárni valahogy, új index a második és további oldalakon?

Először is, mivel az első oldal oldalszámozása és a második oldal tartalma általában eltérő, nem lesznek ismétlődések. De ki kell számolnia, hogy a második, harmadik és további oldalszámozási oldal bekerülhet a keresésbe, és bármilyen releváns kérésre megjelenhet. A lapozási oldalakon jobb esetben a canonical attribútumot javaslom, jó esetben az összes terméket tartalmazó oldalon, hogy a robot ne vegyen bele a lapozó oldalakat a keresésbe. Az emberek nagyon gyakran a kanonikust használják az oldalszámozás első oldalán. A robot a második oldalra jön, látja a terméket, látja a szöveget, nem vesz fel oldalakat a keresésbe, és az attribútum miatt megérti, hogy ez az első oldalszámozási oldal, aminek szerepelnie kell a keresési eredmények között. Használj kanonikust, és zárd be magát a szöveget, szerintem nem szükséges.

Forrás (videó): A webhelyindexelés beállítása- Alekszandr Szmirnov

Magomed Cserbizsev

A keresőmotorok számos okból nem indexelik a webhely összes oldalát, vagy éppen ellenkezőleg, nemkívánatos oldalakat adnak hozzá az indexhez. Ennek eredményeként szinte lehetetlen olyan webhelyet találni, amely ugyanannyi oldalt tartalmaz a Yandexben és a Google-ban.

Ha az eltérés nem haladja meg a 10%-ot, akkor erre nem mindenki figyel. Ez az álláspont azonban igaz a médiára és az információs oldalakra, amikor az oldalak kis részének elvesztése nem befolyásolja a teljes forgalmat. Az online áruházak és más kereskedelmi oldalak esetében azonban a termékoldalak hiánya a keresésben (akár tízből egy) bevételkiesést jelent.

Ezért fontos, hogy legalább havonta egyszer ellenőrizze az oldalak indexelését a Yandexben és a Google-ban, hasonlítsa össze az eredményeket, azonosítsa, mely oldalak hiányoznak a keresésből, és tegyen lépéseket.

Probléma az indexelés figyelésével

Az indexelt oldalak megtekintése nem nehéz. Ezt úgy teheti meg, hogy jelentéseket tölt fel a webmesteri panelekre:

- ("Indexelés" / "Oldalok keresésben" / "Minden oldal" / "XLS / CSV-tábla letöltése");

A szerszám jellemzői:

- az indexelt oldalak egyidejű ellenőrzése a Yandexben és a Google-ban (vagy egy PS-ben);

- az összes webhely URL-jének egyidejű ellenőrzésének lehetősége a segítségével;

- az URL-ek száma nincs korlátozva.

Sajátosságok:

- munka "felhőben" - nincs szükség szoftverek vagy bővítmények letöltésére és telepítésére;

- jelentések feltöltése XLSX formátumban;

- levélben értesíteni az adatgyűjtés befejezéséről;

- jelentések tárolása korlátlan ideig a PromoPult szerveren.

Simán visszatérünk a maratonhoz... Ezalatt egy bizonyos témáról készítettünk egy kis oldalt, keresőmotorokra optimalizálva, és készen áll a további promóciókra. Ma a webhely kezdeti indexeléséről és minden ezzel kapcsolatos dologról kell írnom.

A cikkben arról írtam, hogy cikkekkel töltöm fel az oldalt, és teljesen elfelejtettem írni a töltési gyakoriságról. Mindenki megérti, hogy minél gyakrabban frissítünk (megtöltjük tartalommal az oldalt), annál jobb. Célszerű ezt minden nap megtenni. naponta cikkenként. Ha nem tudsz minden nap frissíteni, akkor legalább kétnaponta. Így mutatjuk meg a keresőknek, hogy az oldal él és folyamatosan fejlődik (az).

Tegyük fel, hogy cikkeket ír, de valamiért az oldal sokáig nem indexelték a PS-ben. Általában a Google gyorsan indexeli az új webhelyeket, de a Yandex néha makacs, és azért gyors indexelés tennie kell valamit.

Hogyan lehet gyorsan indexelni egy webhelyet?

Először is meg kell tennie.

1. Webhely hozzáadása a webmesteri szolgáltatásokhoz

Egy webhely gyors indexeléséhez a Yandexben tegye a következőket:

Webhely hozzáadása a Yandex.Webmasterhez: http://webmaster.yandex.ru/

Megerősítjük az oldalhoz fűződő jogokat a szükséges lépésekkel.

Adja hozzá webhelyéhez a Sitemap.xml fájlt: http://webmaster.yandex.ru/site/map.xml .

Az oldalt az adurilku-hoz is hozzáadhatja. De elvileg ez nem szükséges, mert amikor hozzáadja a Yandex.Webmasterhez, már tájékoztatja a Yandexet az új webhelyről.

A gyors indexelés érdekében a Google webmesteri panellel is rendelkezik:

Adjon hozzá egy Sitemap.xml fájlt. Megnézzük a beállításokat, és szükség esetén módosítjuk.

Ha nem tud hozzáadni a webmestereszközökhöz, egyszerűen használhatja google addurilka.

2. ping szolgáltatásokat használunk (ping - szolgáltatások)

A ping szolgáltatások segítenek gyorsan indexelni az újonnan közzétett bejegyzéseket, vagy inkább arra szolgálnak, hogy értesítsék a keresőmotorokat és más szolgáltatásokat az új bejegyzések megjelenéséről a webhelyen.

A WordPress rendelkezik egy olyan eszközzel, amely automatikusan értesíti a frissítési szolgáltatásokat, ha frissítések állnak rendelkezésre. új bejegyzés. A ping szolgáltatások listája a WP Admin - "Beállítások" - "Írás" menüpontban van konfigurálva. Frissítési szolgáltatások.

Hatalmas listák állnak rendelkezésre az online frissítési szolgáltatásokról. Nem látom értelmét a ping szolgáltatások nagy listájának, és csak ezeket a szolgáltatásokat használom:

http://rpc.pingomatic.com/

http://ping.blogs.yandex.ru/RPC2

http://blogsearch.google.com/ping/RPC2

http://ping.feedburner.com

A webhely gyors indexelésének eszközeként.

Most sok a szociális könyvjelzők és számos szolgáltatás és program a közösségi hálózatokon való közzétételhez. Könyvjelzők. Szeretem a Bug Maker programot. Általában véve a szociális a könyvjelzők használata egyszerű. Regisztráljon fiókokat a könyvjelző szolgáltatásokban, tegye közzé a főoldal vagy bármely belső oldal URL-jét, írjon leírást, kulcsszavakat stb.

Linkek vásárlása. Az indexelés felgyorsítása érdekében linkeket vásárolhat. Sapában vagy GGL-ben vásárolok (minden az indexelendő oldaltól függ). Olyan bizalmi forrásokból vásárolok emberek számára, amelyeken a tartalom naponta többször frissül, és a keresőrobotok nagyon gyakran mennek.

Saját oldalak, fórumok, baráti oldalak stb. A legfontosabb, hogy ne spamezzen. Az indexeléshez kis számú hivatkozásra van szükség. Ez is lehetséges, de nem valószínű, hogy valaki nem indexelt erőforrással szeretne változtatni

Néhány tipp:

- Nincs spam.

- Ne használjon címtár-feltérképezést új webhelyekhez. A címtárakból és hirdetőtáblákból származó több száz (vagy akár több ezer) ostoba hivatkozás segíthet egy új webhely gyors indexelésében, de semmi értelme egy ilyen webhelynek. A keresők logikája egyértelmű, ha egy csomó szar oldal hivatkozik egy oldalra, akkor nagy valószínűséggel ez az oldal is egy szar oldal. A tetves adományozókról nem is beszélve, a Yandex egyáltalán nem szereti a gyors linkek tömeges növekedését. Ezért szelektíven tegyen linkeket, tegyen mindent a kezével és szeretettel.

sushiandbox.ru A számítógép elsajátítása - Internet. Skype. Közösségi média. Leckék a Windowsról.

sushiandbox.ru A számítógép elsajátítása - Internet. Skype. Közösségi média. Leckék a Windowsról.