(11 )

Dans cet article, nous décrirons l'algorithme complet de collecte du noyau sémantique, principalement pour un site informatif, mais cette approche peut également s'appliquer à des sites marchands.

Sémantique initiale et création de la structure du site

Préparation des mots pour l'analyse et la structure initiale du site

Avant de commencer à analyser des mots, nous devons les connaître. Par conséquent, nous devons créer la structure initiale de notre site et les mots initiaux pour l'analyse (ils sont également appelés marqueurs).

Vous pouvez voir la structure et les mots d'origine :

1. En utilisant la logique, les mots de la tête (si vous comprenez le sujet).

2. De vos concurrents, que vous avez analysés lors du choix des niches ou de la saisie de votre requête principale.

3. De Wikipédia. Il ressemble généralement à ceci :

4. Nous regardons wordstat pour vos requêtes principales et la colonne de droite.

5. Autres ouvrages thématiques et ouvrages de référence.

Par exemple, le sujet de notre site est la maladie cardiaque. Il est clair que nous devons avoir toutes les maladies cardiaques dans notre structure.

Vous ne pouvez pas vous passer d'un manuel médical. Je ne regarderais pas les concurrents, car ils n'ont peut-être pas toutes les maladies, ils n'ont probablement pas eu le temps de les couvrir.

Et vos premiers mots pour l'analyse seront exactement toutes les maladies cardiaques, et sur la base des clés que nous analysons, vous construirez la structure du site lorsque vous commencerez à les regrouper.

De plus, vous pouvez prendre tous les médicaments pour le traitement du cœur, comme extension du sujet, etc. Vous regardez Wikipedia, les rubriques des concurrents sur le site, wordstat, pensez logiquement et trouvez ainsi plus de mots marqueurs que vous analyserez.

Structure du site

Vous pouvez regarder les concurrents pour un aperçu général, mais vous n'êtes pas toujours obligé de créer une structure comme la leur. Vous devriez procéder davantage à partir de la logique de votre public cible, ils saisissent également les requêtes que vous analysez à partir des moteurs de recherche.

Par exemple, comment procéder ? Énumérez toutes les maladies cardiaques et, à partir d'elles, effectuez déjà des symptômes, un traitement. Ou, néanmoins, faites des rubriques pour les symptômes, le traitement, et à partir d'eux conduisent déjà à des maladies. Ces problèmes sont généralement résolus en regroupant les mots-clés en fonction des données des moteurs de recherche. Mais pas toujours, parfois vous devrez faire vos propres choix et décider comment rendre la structure la meilleure, car les demandes peuvent se chevaucher.

Vous devez toujours vous rappeler que la structure est créée tout au long de la collection de sémantiques et parfois dans sa forme originale, elle se compose de plusieurs en-têtes, et avec un regroupement et une collection supplémentaires, elle se développe à mesure que vous commencez à voir les requêtes et la logique. Et parfois, vous pouvez le composer et ne pas vous soucier immédiatement des mots-clés, car vous connaissez bien le sujet ou il est bien représenté par les concurrents. Il n'y a pas de système pour compiler la structure du site, vous pouvez dire que c'est votre créativité personnelle.

La structure peut être personnelle (différente des concurrents), mais elle doit être pratique pour les gens, répondre à leur logique, et donc à la logique des moteurs de recherche, et telle que vous puissiez couvrir tous les mots thématiques de votre créneau. Ce devrait être le meilleur et confortable!

Penser à l'avance. Il arrive que vous preniez un créneau, puis que vous souhaitiez l'étendre, et que vous commenciez à modifier la structure de l'ensemble du site. Et la structure créée sur le site est très difficile et morne à changer. Idéalement, vous devrez modifier les URL des pièces jointes et coller le tout sur le site lui-même. Bref, quel travail fastidieux et très responsable, alors décidez immédiatement comme un homme quoi et comment vous devriez avoir!

Si vous êtes très nouveau sur le sujet du site en cours de création et que vous ne savez pas comment la structure sera construite, que vous ne savez pas quels mots initiaux prendre pour l'analyse, vous pouvez alors échanger les étapes 1 et 2 de la collection. Autrement dit, analysez d'abord les concurrents (nous analyserons comment les analyser ci-dessous), examinez leurs clés, sur cette base, créez une structure et des mots initiaux pour l'analyse, puis analysez wordstat, astuces, etc.

Pour compiler la structure, j'utilise le gestionnaire d'esprit - Xmind. C'est gratuit et a tout ce dont vous avez besoin.

Une structure simple ressemble à ceci :

C'est la structure d'un site marchand. Habituellement, dans les sites d'information, il n'y a pas d'intersections ni de filtres de fiches de produits. Mais cette structure n'est pas compliquée non plus, elle a été compilée pour que le client la comprenne. Habituellement, mes structures consistent en de nombreuses flèches et intersections, des commentaires - moi seul peux comprendre une telle structure.

Est-il possible de créer une sémantique dans le processus de remplissage du site ?

Si la sémantique est facile, que vous avez confiance dans le sujet et que vous le connaissez, alors vous pouvez faire la sémantique en parallèle avec le contenu du site. Mais la structure initiale doit nécessairement être jetée. Je pratique moi-même parfois cela dans des niches très étroites ou dans des niches très larges, pour ne pas passer beaucoup de temps à collecter de la sémantique, mais pour lancer immédiatement le site, mais je ne conseillerais toujours pas de le faire. La probabilité d'erreurs est très élevée si vous n'avez aucune expérience. Pourtant, c'est plus facile lorsque toute la sémantique est prête, que toute la structure est prête et que tout est dégroupé et compréhensible. De plus, dans la sémantique finie, vous pouvez voir quelles clés doivent être prioritaires, lesquelles n'ont pas de concurrence et apporteront plus de visiteurs.

Ici, vous devez également repousser la taille du site, si la niche est large, il est inutile de collecter la sémantique, il est préférable de le faire en cours de route, car la collecte de la sémantique peut prendre un mois ou plus.

Nous avons donc initialement intégré la structure ou ne l'avons pas intégrée, nous avons décidé de passer à la deuxième étape. Nous avons une liste de mots ou d'expressions initiaux pour notre sujet que nous pouvons commencer à analyser.

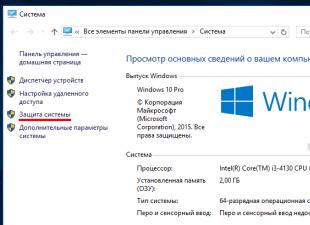

Analyser et travailler dans keycollector

Pour l'analyse, bien sûr, j'utilise keycollector . Je ne m'attarderai pas sur la mise en place de keycollectora, vous pouvez lire l'aide de ce programme ou trouver des articles de configuration sur Internet, il y en a beaucoup et tout y est décrit en détail.

Lors du choix des sources de grattage, vous devez calculer vos coûts de main-d'œuvre et leur efficacité. Par exemple, si vous analysez la base de données de Pastukhov ou MOAB, vous fouillerez dans un tas de requêtes indésirables qui devront être filtrées, et c'est le moment. Et à mon avis, cela ne vaut pas la peine de trouver quelques demandes. Il existe une étude très intéressante sur les bases de données de RushAnalytics, bien sûr elles s'en vantent, mais si vous n'y prêtez pas attention, des données très intéressantes sur le pourcentage de mauvais mots-clés http://www.rush-analytics.ru/ blog/analytica-istochnikov-sémantique

Lors de la première étape, j'analyse wordstat, adwords, leurs conseils et j'utilise la base de données de mots clés Bookvarix (la version de bureau est gratuite). J'avais aussi l'habitude de parcourir manuellement les conseils de Youtube. Mais récemment, keycollector a ajouté la possibilité de les analyser, ce qui est très agréable. Si vous êtes un pervers complet, vous pouvez ajouter d'autres bases de mots-clés ici.

Commencez l'analyse et c'est parti.

Nettoyer le noyau sémantique d'un site d'information

Nous avons analysé les requêtes et nous avons obtenu une liste de mots différents. Bien sûr, il contient les mots nécessaires, ainsi que les mots indésirables - vides, non thématiques, non pertinents, etc. Par conséquent, ils doivent être nettoyés.

Je ne supprime pas les mots inutiles, mais les déplace dans des groupes, car :

- À l'avenir, ils peuvent devenir matière à réflexion et acquérir une pertinence.

- Nous excluons la possibilité de suppression accidentelle de mots.

- Lors de l'analyse ou de l'ajout de nouvelles phrases, elles ne seront pas ajoutées si vous cochez la case.

J'ai parfois oublié de le définir, j'ai donc configuré l'analyse dans un groupe et analysé les clés uniquement dans celui-ci afin que la collection ne soit pas dupliquée :

Vous pouvez travailler de cette façon ou de cette façon, selon ce qui vous convient.

Collection de fréquences

Nous recueillons de tous les mots par direct, fréquence de base [W] et exact [“!W”].

Tout ce qui ne s'est pas réuni, nous le collectons via wordstat.

Nettoyage d'un seul mot et non-format

Nous filtrons par mots simples, les examinons et supprimons ceux qui ne sont pas nécessaires. Il existe de telles requêtes à un mot qu'il est insensé de continuer, elles ne sont pas sans ambiguïté ou ne dupliquent pas une autre requête à un mot.

Par exemple, nous avons un sujet - les maladies cardiaques. Par le mot «cœur», il ne sert à rien d'aller de l'avant, ce qu'une personne veut dire n'est pas clair - c'est une demande trop large et ambiguë.

Nous examinons également les mots que la fréquence n'a pas collectés - il contient soit des caractères spéciaux dans les mots, soit il y a plus de 7 mots dans la requête. Nous les transférons au non-format. Il est peu probable que de telles demandes soient saisies par des personnes.

Brossage par fréquence globale et exacte

Nous supprimons tous les mots avec une fréquence commune [W] de 0 à 1.

J'enlève aussi tout de 0 à 1 selon la fréquence exacte [”!W”].

Je les divise en différents groupes. ![]()

Dans ce qui suit, des mots clés logiques normaux peuvent être trouvés dans ces mots. Si le noyau est petit, vous pouvez immédiatement revoir manuellement tous les mots avec une fréquence nulle et partir, ce que, comme vous le pensez, les gens entrent. Cela aidera à couvrir complètement le sujet et il est possible que les gens suivent de tels mots. Mais naturellement, ces mots doivent être utilisés en dernier, car selon eux grand trafic certainement pas.

La valeur de 0 à 1 est également prise en fonction du sujet, s'il y a beaucoup de mots clés, vous pouvez filtrer de 0 à 10. Autrement dit, tout dépend de l'étendue de votre sujet et de vos préférences.

Chaussure par couverture

La théorie ici est la suivante: par exemple, il y a un mot - "forum", sa fréquence de base est de 8 136 416 et la fréquence exacte est de 24 377, car nous voyons que la différence est de plus de 300 fois. Par conséquent, nous pouvons supposer que cette requête est vide, elle comprend beaucoup de queues.

Par conséquent, par tous les mots, je calcule, tel KEI :

Fréquence fine / Fréquence de base * 100 % = couverture de couverture

Plus le pourcentage est faible, plus il est probable que le mot soit vide.

Dans KeyCollector, cette formule ressemble à ceci :

YandexWordstatQuotePointFreq / (YandexWordstatBaseFreq+0.01) * 100

Ici aussi, tout dépend du sujet et du nombre de phrases dans le noyau, vous pouvez donc supprimer l'exhaustivité de la couverture à moins de 5%. Et là où le noyau est gros, vous ne pouvez même pas en prendre 10 à 30%.

Purge par doublons implicites

Pour nettoyer les doublons implicites, nous devons collecter la fréquence Adwords à partir d'eux et naviguer par celle-ci, car il prend en compte l'ordre des mots. Nous économisons des ressources, nous collecterons donc cet indicateur non pas sur l'ensemble du noyau, mais uniquement sur les doublons.

De cette façon, nous avons trouvé et marqué tous les doublons non évidents. Fermez l'onglet - Analyse des doublons implicites. Ils nous ont marqués dans groupe de travail. Maintenant, nous n'afficherons qu'eux, car les paramètres ne sont tirés que des phrases que nous avons montrées dans le groupe sur ce moment. Et seulement alors nous commençons l'analyse.

On attend qu'Adwords prenne les indicateurs et se lance dans l'analyse des doublons implicites.

Nous définissons ces paramètres d'une marque de groupe intelligent et cliquez sur - effectuer une vérification intelligente. De cette façon, seules les requêtes Adwords les plus fréquentes ne seront pas marquées dans notre groupe de doublons.

Bien sûr, il vaut mieux passer en revue tous les doublons et regarder manuellement, tout à coup quelque chose s'est mal configuré. Portez une attention particulière aux groupes où il n'y a pas d'indicateurs de fréquence, où les doublons sont marqués au hasard.

Tout ce que vous marquez dans l'analyse des groupes implicites, c'est aussi déposé dans le groupe de travail. Ainsi, une fois l'analyse terminée, fermez simplement l'onglet et transférez tous les doublons implicites marqués dans le dossier approprié.

Nettoyage par mots vides

Arrêtez les mots que je divise également en groupes. Séparément, j'apporterai les villes. Ils peuvent être utiles à l'avenir si nous décidons de créer un répertoire d'organisations.

Séparément, je saisis les mots contenant les mots photo, vidéo. Un jour, ils seront utiles.

Et aussi, "demandes vitales", par exemple, Wikipedia, j'inclus le forum ici, ainsi que dans le sujet médical, cela peut inclure - Malyshev, les moustiques, etc.

Tout dépend du sujet aussi. Vous pouvez également faire des demandes commerciales distinctes - prix, acheter, stocker.

Il s'avère que voici une liste de groupes par mots vides :

Nettoyer les mots tordus

Cela s'applique aux sujets concurrentiels, ils sont souvent trompés par des concurrents dans le but de vous induire en erreur. Par conséquent, il est nécessaire de collecter la saisonnalité et d'éliminer tous les mots avec une médiane égale à 0.

Et aussi, vous pouvez regarder le rapport de la fréquence de base à la moyenne, une grande différence peut également indiquer une demande de triche.

Mais vous devez comprendre que ces indicateurs peuvent également indiquer qu'il s'agit de nouveaux mots pour lesquels les statistiques ne sont apparues que récemment ou qu'ils sont simplement saisonniers.

Nettoyage par géo

Habituellement, la vérification par géo pour les sites d'information n'est pas nécessaire, mais juste au cas où, je signerai ce moment.

S'il y a le moindre doute que certaines demandes sont géo-dépendantes, il est préférable de vérifier cela via la collection Rookee, bien qu'elle fasse parfois des erreurs, mais beaucoup moins souvent que de vérifier ce paramètre par Yandex. Ensuite, après avoir collecté Rookee, il convient de vérifier manuellement tous les mots, qui sont indiqués comme géodépendants.

Nettoyage manuel

Maintenant, notre noyau est devenu plusieurs fois plus petit. Nous l'examinons manuellement et supprimons les phrases inutiles.

En conséquence, nous obtenons les groupes suivants de notre noyau :

Jaune - mérite d'être creusé, vous pouvez trouver des mots pour l'avenir.

Orange - peut être utile si nous élargissons le site avec de nouveaux services.

Rouge - pas utile.

Analyse de la concurrence des requêtes pour les sites d'information

Après avoir collecté les demandes et les avoir nettoyées, nous devons maintenant vérifier leur concurrence afin de comprendre à l'avenir quelles demandes doivent être traitées en premier lieu.

Concurrence dans le nombre de documents, titres, pages principales

Tout cela est facilement supprimé via KEI dans le KeyCollector.

Nous obtenons des données pour chaque demande, combien de documents ont été trouvés dans le moteur de recherche, dans notre exemple dans Yandex. Combien de pages principales se trouvent dans les résultats de cette requête et les occurrences de la requête dans le titre.

Sur Internet, vous pouvez trouver différentes formules pour calculer ces indicateurs, même s'il semble que dans le KeyCollector fraîchement installé, selon la norme, une sorte de formule de calcul de KEI est intégrée. Mais je ne les suis pas, car vous devez comprendre que chacun de ces facteurs a poids différent. Par exemple, le plus important est la présence des pages principales dans les résultats de recherche, puis les rubriques et le nombre de documents. Il est peu probable que cette importance des facteurs puisse d'une manière ou d'une autre être prise en compte dans la formule, et si c'est encore possible, alors vous ne pouvez pas vous passer d'un mathématicien, mais alors cette formule ne pourra pas s'adapter aux capacités de KeyCollector .

Concurrence sur le marché des liens

C'est plus intéressant ici. Chaque échange a ses propres algorithmes de calcul de la concurrence, et on peut supposer qu'ils prennent en compte non seulement la présence de pages principales dans les résultats de recherche, mais également l'âge des pages, la masse de liens et d'autres paramètres. Fondamentalement, ces échanges sont bien sûr conçus pour des demandes commerciales, mais encore, plus ou moins, certaines conclusions peuvent être tirées des demandes d'informations.

Nous collectons des données sur les échanges et affichons des moyennes et nous nous concentrons déjà sur eux.

Je collecte généralement sur 2-3 échanges. L'essentiel est que toutes les demandes soient collectées pour les mêmes échanges et que le nombre moyen ne soit dérivé que pour elles. Et non pas pour que certaines demandes aient été collectées par certains échanges, et d'autres par d'autres, et qu'ils en aient déduit la moyenne.

Pour une vue plus visuelle, vous pouvez appliquer la formule KEI, qui affichera le coût d'un visiteur en fonction des paramètres des échanges :

KEI = Budget moyen / (Trafic moyen +0,01)

Divisez le budget moyen des échanges par le trafic moyen prévu pour les échanges, nous obtenons le coût par visiteur basé sur les données des échanges.

compétition mutagène

Ce n'est pas dans keycollector, mais ce n'est pas un problème. Sans problème, tous les mots peuvent être téléchargés vers Excel, puis exécutés via le KeyCollector.

Pourquoi Keyso est-il meilleur ? Il a une base plus large que ses concurrents. C'est propre, il n'y a pas de phrases qui sont dupliquées et écrites dans un ordre différent. Par exemple, vous n'y trouverez pas de telles touches répétées "diabète de type 1", "diabète de type 1".

Keyso sait également comment incendier des sites avec un compteur Adsense, Analytics, Leadia, etc. Vous pouvez voir quels autres sites il y a du propriétaire du site analysé. Oui, et en général, quand il s'agit de trouver des sites concurrents, je pense que c'est la meilleure solution.

Comment travailler avec Keyso ?

Nous prenons n'importe quel site de notre concurrent, c'est mieux bien sûr plus, mais pas particulièrement critique. Parce que nous allons travailler en deux itérations, saisissez-le dans le champ. Zhmakaem - analyser.

On se renseigne sur le site, on s'intéresse aux concurrents ici, cliquez sur ouvrir tout.

Nous ouvrons tous les concurrents.

Ce sont tous des sites qui chevauchent d'une manière ou d'une autre des mots-clés avec notre site analysé. Il y aura youtube.com, otvet.mail.ru, etc., c'est-à-dire de grands portails qui écrivent sur tout. Nous n'en avons pas besoin, nous avons besoin de sites uniquement sur notre sujet. Par conséquent, nous les filtrons selon les critères suivants.

La similarité est le pourcentage de clés communes par rapport au nombre total de ce domaine.

Thématicité - le nombre de clés de notre site analysé dans les clés du domaine du concurrent.

Par conséquent, l'intersection de ces paramètres supprimera les sites partagés.

Nous mettons le thème 10, similarité 4 et voyons ce que nous obtenons.

Il s'est avéré 37 concurrents. Mais tout de même, nous allons toujours les vérifier manuellement, les télécharger sur Excel et, si nécessaire, supprimer ceux qui ne sont pas nécessaires.

Allez maintenant dans l'onglet de rapport de groupe et entrez tous nos concurrents que nous avons trouvés ci-dessus. Cliquez pour analyser.

Nous obtenons une liste de mots clés pour tous ces sites. Mais nous n'avons pas encore entièrement dévoilé le sujet. Nous passons donc chez les concurrents du groupe.

Et maintenant, nous obtenons tous les concurrents, tous les sites auxquels nous sommes entrés. Il y en a plusieurs fois plus et il y en a aussi beaucoup de thématiques générales. Nous les filtrons par similarité, disons 30.

Nous obtenons 841 concurrents.

Ici, nous pouvons voir le nombre de pages de ce site, le trafic et tirer des conclusions sur le concurrent le plus efficace.

Nous les exportons tous vers Excel. Nous trions entre nos mains et ne laissons que les concurrents de notre créneau, nous pouvons marquer les camarades les plus efficaces afin de les évaluer plus tard et voir quelles puces ils ont sur le site, des requêtes qui donnent beaucoup de trafic.

Maintenant, nous allons à nouveau au rapport de groupe et ajoutons tous les concurrents que nous avons déjà trouvés et obtenons une liste de mots-clés.

Ici, nous pouvons immédiatement filtrer la liste par "!wordstat" Plus de 10.

Voici nos demandes, maintenant nous pouvons les ajouter au KeyCollector et spécifier que les phrases qui sont déjà dans un autre groupe KeyCollector ne sont pas ajoutées.

Maintenant, nous nettoyons nos clés et élargissons, regroupons nos noyau sémantique.

Services de collecte sémantique de base

Dans cette industrie, vous pouvez trouver de nombreuses organisations prêtes à vous offrir des services de clustering. Par exemple, si vous n'êtes pas prêt à prendre le temps d'apprendre les subtilités du clustering et de le faire vous-même, il y a beaucoup de gens prêts à faire le travail.

Yadrex

L'un des premiers sur le marché à utiliser intelligence artificielle créer un noyau sématique. Le chef d'entreprise est lui-même webmaster professionnel et spécialiste des technologies SEO, il est donc garant de la qualité du travail de ses collaborateurs.

De plus, vous pouvez appeler les numéros indiqués pour obtenir des réponses à toutes vos questions concernant les travaux.

Lors de la commande de services, vous recevrez un fichier contenant les groupes de contenu du noyau et sa structure. De plus, vous obtenez la structure dans le mindmup.

Le coût des travaux varie en fonction du volume, plus le volume de travail est important, moins le coût d'une clé est élevé. Coût maximal pour projet d'information sera de 2,9 roubles pour une clé. Pour le vendeur 4,9 roubles par clé. Des rabais et des primes sont offerts pour les grosses commandes.

Conclusion

Ceci achève la création du noyau sémantique du site d'information.

Je vous conseille de surveiller l'historique des modifications du programme KeyCollector, car il est constamment complété par de nouveaux outils, par exemple, youtube pour l'analyse a été récemment ajouté. Avec l'aide de nouveaux outils, vous pouvez encore étendre votre noyau sémantique.

Si vous connaissez la douleur de "l'aversion" des moteurs de recherche pour les pages de votre boutique en ligne, lisez cet article. Je parlerai de la voie pour augmenter la visibilité du site, ou plutôt de sa première étape - la collecte de mots-clés et la compilation d'un noyau sémantique. A propos de l'algorithme pour sa création et des outils qui sont utilisés pour cela.

Commandez la collection du noyau sémantique auprès des spécialistes SEO de l'agence Netpeak :

Pourquoi constituer un noyau sémantique ?

Augmenter la visibilité des pages du site. Faites en sorte que les robots de recherche Yandex et Google commencent à trouver des pages de votre site à la demande des utilisateurs. Bien sûr, la collecte de mots-clés (composant la sémantique) est la première étape vers cet objectif. Ensuite, un « squelette » conditionnel est ajouté pour répartir les mots-clés selon différentes pages de destination. Et puis les articles/meta tags sont déjà écrits et implémentés.

Soit dit en passant, sur Internet, vous pouvez trouver de nombreuses définitions du noyau sémantique.

1. "Le noyau sémantique est un ensemble ordonné de mots de recherche, leurs formes morphologiques et les phrases qui caractérisent le plus précisément le type d'activité, de produit ou de service proposé par le site." Wikipédia.

Pour collecter la sémantique des concurrents dans Serpstat, entrez l'une des requêtes clés, sélectionnez une région, cliquez sur "Rechercher" et allez dans la catégorie "Analyse" Expressions-clés". Sélectionnez ensuite "Analyse SEO" et cliquez sur "Sélectionner des phrases". Exporter les résultats :

2.3. Utilisation de Key Collector/Slovoeb pour créer un noyau sémantique

Si vous avez besoin de créer un noyau sémantique pour une grande boutique en ligne, vous ne pouvez pas vous passer de Key Collector. Mais si vous êtes débutant, il est plus pratique d'utiliser un outil gratuit - Slovoeb (que ce nom ne vous effraie pas). Téléchargez le programme et, dans les paramètres Yandex.Direct, spécifiez le nom d'utilisateur et le mot de passe de votre Yandex.Mail :  Créez un nouveau projet. Dans l'onglet "Données", sélectionnez la fonction "Ajouter des phrases". Sélectionnez une région et entrez les demandes que vous avez reçues précédemment :

Créez un nouveau projet. Dans l'onglet "Données", sélectionnez la fonction "Ajouter des phrases". Sélectionnez une région et entrez les demandes que vous avez reçues précédemment :  Conseil : créez un projet distinct pour chaque nouveau domaine, et créez un groupe distinct pour chaque catégorie/page de destination. Par exemple:

Conseil : créez un projet distinct pour chaque nouveau domaine, et créez un groupe distinct pour chaque catégorie/page de destination. Par exemple:  Collectez maintenant la sémantique de Yandex.Wordstat. Ouvrez l'onglet "Collecte de données" - "Collection par lots de mots de la colonne de gauche de Yandex.Wordstat". Dans la fenêtre qui s'ouvre, cochez la case "Ne pas ajouter de phrases si elles existent déjà dans d'autres groupes". Entrez certaines des phrases les plus populaires (à haute fréquence) parmi les utilisateurs et cliquez sur "Commencer à collecter":

Collectez maintenant la sémantique de Yandex.Wordstat. Ouvrez l'onglet "Collecte de données" - "Collection par lots de mots de la colonne de gauche de Yandex.Wordstat". Dans la fenêtre qui s'ouvre, cochez la case "Ne pas ajouter de phrases si elles existent déjà dans d'autres groupes". Entrez certaines des phrases les plus populaires (à haute fréquence) parmi les utilisateurs et cliquez sur "Commencer à collecter":

Soit dit en passant, pour les grands projets dans Key Collector, vous pouvez collecter des statistiques à partir des services d'analyse des concurrents SEMrush, SpyWords, Serpstat (ex. Prodvigator) et d'autres sources supplémentaires.

En 2008, j'ai créé mon premier projet Internet.

C'était un magasin d'électronique en ligne qui avait besoin de promotion.

Initialement, le travail de promotion a été confié aux programmeurs qui l'ont créé.

Que promouvoir ?

Ils ont compilé une liste de clés en 5 minutes : téléphones portables, caméscopes, appareils photo, iPhones, Samsung - toutes les catégories et tous les produits du site.

Il s'agissait de noms communs qui ne ressemblaient pas du tout à un noyau sémantique correctement composé.

Une longue période passa sans résultats.

Des rapports incompréhensibles contraints de rechercher des artistes spécialisés dans la promotion de sites Web.

J'ai trouvé une entreprise locale, je leur ai confié le projet, mais même ici, tout n'a servi à rien.

Ensuite, la compréhension est venue que de vrais professionnels devraient être engagés dans la promotion.

Après avoir lu de nombreuses critiques, j'ai trouvé l'un des meilleurs freelances qui assura le succès.

Six mois plus tard, toujours aucun résultat.

C'est le manque de résultats en organique depuis deux ans qui m'a poussé vers le SEO.

Par la suite, cela est devenu la vocation principale.

Maintenant, je comprends ce qui n'allait pas dans ma promotion initiale.

Ces erreurs sont répétées par la plupart des spécialistes du référencement, même expérimentés, qui ont passé plus d'un an à promouvoir des sites Web.

Les ratés étaient dans le mauvais travail avec des mots-clés.

En fait, il n'y avait aucune compréhension de ce que nous promouvons.

Vous n'avez pas le temps de collecter le noyau sémantique, remplissez rapidement les coordonnées.

Le noyau sémantique (en abrégé SN) est une liste spécifique de mots-clés décrivant au mieux le thème du site.

Pourquoi faut-il constituer le noyau sémantique du site

- le noyau sémantique caractérise, c'est grâce à lui que les robots indexant la page déterminent non seulement le naturel du texte, mais aussi le sujet afin d'amener la page dans la section de recherche appropriée. Il est évident que les robots fonctionnent en toute autonomie après avoir saisi l'adresse de la page du site dans la base de ressources de recherche ;

- bien écrit est la base sémantique du site et reflète la structure appropriée pour la promotion du référencement ;

- chaque page du site, respectivement, est liée à une certaine partie du CL de la ressource Web ;

- grâce au noyau sémantique, une stratégie de promotion dans les moteurs de recherche est formée;

- selon le noyau sémantique, vous pouvez estimer le coût de la promotion.

Règles de base pour compiler un noyau sémantique

Afin d'assembler le SA, vous devrez assembler des ensembles de mots-clés. À cet égard, vous devez évaluer votre force par rapport à la promotion des requêtes à haute et moyenne fréquence. Si vous souhaitez obtenir le plus de visiteurs avec un budget limité, vous devez utiliser des requêtes à fréquence élevée et moyenne. Si c'est l'inverse, alors requêtes moyenne et basse fréquence.

Même si vous avez un budget élevé, cela n'a aucun sens de promouvoir le site uniquement pour les requêtes à haute fréquence. Souvent, ces demandes sont trop caractère général et charge sémantique non spécifiée, par exemple, "écouter de la musique", "actualités", "sports".

Lors du choix des requêtes de recherche, ils analysent un ensemble d'indicateurs correspondant à la phrase de recherche :

- nombre d'impressions (fréquence) ;

- le nombre d'impressions sans changements morphologiques et combinaisons de mots ;

- les pages émises par le moteur de recherche lors de la saisie d'une requête de recherche ;

- pages dans le TOP de recherche pour les requêtes clés ;

- estimer le coût de la promotion à la demande ;

- concurrence par mots-clés ;

- nombre prévu de transitions ;

- taux de rebond (fermeture du site après avoir cliqué sur le lien) et saisonnalité du service ;

- géo-dépendance des mots-clés (localisation géographique de l'entreprise et de ses clients).

Comment construire un noyau sémantique

En pratique, la sélection du noyau sémantique peut être effectuée par les méthodes suivantes :

Les sites Web concurrents peuvent devenir la source de mots-clés pour le noyau sémantique. C'est là que vous pouvez rapidement sélectionner des mots-clés, ainsi que déterminer la fréquence de leur "environnement" à l'aide d'une analyse sémantique. Pour ce faire, il faudra faire un bilan sémantique de la page de texte, les mots les plus cités constituent le noyau morphologique ;

Nous vous recommandons de former votre propre noyau sémantique basé sur des statistiques services spéciaux. Utilisez, par exemple, Wordstat Yandex- le système statistique du moteur de recherche Yandex. Ici, vous pouvez voir la fréquence de la requête de recherche, ainsi que découvrir ce que les utilisateurs recherchent avec ce mot-clé ;

Les "astuces" des systèmes s'affichent lorsque vous essayez d'entrer une expression de recherche dans ligne interactive. Ces mots et phrases peuvent également entrer dans le SL en tant que mots connectés ;

Les bases de données fermées de requêtes de recherche, par exemple la base de données de Pastukhov, peuvent devenir la source de mots-clés pour CL. Il s'agit de tableaux de données spéciaux contenant des informations sur les combinaisons efficaces de requêtes de recherche ;

Les statistiques internes du site peuvent également devenir une source de données sur les requêtes de recherche qui intéressent l'utilisateur. Il contient des informations sur la source et sait d'où vient le lecteur, combien de pages il a consultées et de quel navigateur il vient.

Outils gratuits pour compiler un noyau sémantique :

Yandex.Wordstat- un outil gratuit populaire utilisé pour compiler un noyau sémantique. En utilisant le service, vous pouvez savoir combien de fois les visiteurs ont saisi une requête spécifique dans le moteur de recherche Yandex. Permet d'analyser la dynamique de la demande pour cette requête par mois.

Google AdWords est l'un des systèmes les plus utilisés pour sortir du noyau sémantique du site. Avec l'aide de Google Keyword Planner, vous pouvez calculer et prévoir les impressions de requêtes spécifiques à l'avenir.

Yandex.Direct de nombreux développeurs utilisent les mots-clés les plus rentables pour la sélection. Si, à l'avenir, il est prévu de placer des publicités sur le site, le propriétaire de la ressource avec cette approche recevra un bon profit.

Slovoeb- le frère cadet de Kay Collector, qui sert à compiler le noyau sémantique du site. Les données de Yandex sont prises comme base. Parmi les avantages, on peut noter une interface intuitive, ainsi qu'une accessibilité non seulement pour les professionnels, mais aussi pour les débutants qui commencent tout juste à s'engager dans l'analyse SEO.

Outils payants pour compiler un noyau sémantique :

Base Pastukhov selon de nombreux experts n'ont pas de concurrents. La base de données affiche de telles demandes que ni Google ni Yandex n'affichent. Il existe de nombreuses autres fonctionnalités inhérentes aux bases de données de Max Pastukhov, parmi lesquelles on peut noter un shell logiciel pratique.

Mots espions- Un outil intéressant qui permet d'analyser les mots clés des concurrents. Avec son aide, vous pouvez effectuer une analyse comparative des noyaux sémantiques des ressources d'intérêt, ainsi que d'obtenir toutes les données sur RRS et Sociétés de référencement concurrents. La ressource est russophone, il ne sera pas difficile de gérer ses fonctionnalités.

Un programme payant créé spécifiquement pour les professionnels. Aide à composer le noyau sémantique en identifiant les requêtes pertinentes. Il est utilisé pour estimer le coût de promotion d'une ressource pour les mots-clés d'intérêt. En plus d'un haut niveau d'efficacité, ce programme se distingue par sa facilité d'utilisation.

SEMrush vous permet de déterminer les mots-clés les plus efficaces en fonction des données provenant de ressources concurrentes. Avec son aide, vous pouvez sélectionner des requêtes à basse fréquence, caractérisées par haut niveau circulation. Comme le montre la pratique, pour de telles demandes, il est très facile de promouvoir la ressource aux premières positions du problème.

SeoLib- un service qui a gagné la confiance des optimiseurs. A beaucoup de fonctionnalités. Vous permet de composer avec compétence un noyau sémantique, ainsi que d'effectuer les mesures analytiques nécessaires. En mode gratuit, vous pouvez analyser 25 requêtes par jour.

promoteur permet d'assembler le noyau sémantique primaire en quelques minutes seulement. Il s'agit d'un service utilisé principalement pour l'analyse des sites concurrents, ainsi que pour la sélection des requêtes clés les plus efficaces. L'analyse de mots est sélectionnée pour Google en Russie ou pour Yandex dans la région de Moscou.

Le noyau sémantique est assemblé assez rapidement si les sources et les bases de données sont utilisées comme indice.

Les processus suivants doivent être distingués

Selon le contenu du site et les sujets pertinents sont sélectionnés mots clés, qui reflètent le plus fidèlement la signification de votre portail Web.

- De l'ensemble sélectionné, les superflus sont éliminés, éventuellement les requêtes qui peuvent aggraver l'indexation de la ressource. Le filtrage des mots clés est effectué sur la base des résultats de l'analyse décrite ci-dessus.

- Le noyau sémantique résultant doit être uniformément réparti entre les pages du site, si nécessaire, des textes avec un thème spécifique et un volume de mots-clés sont commandés.

Un exemple de collecte d'un noyau sémantique à l'aide du service Wordstat Yandex

Par exemple, vous faites la promotion d'un salon de manucure à Moscou.

Nous pensons et sélectionnons toutes sortes de mots qui correspondent au thème du site.

Activité de l'entreprise

- salon de manucure;

- salon de manucure;

- atelier de manucure

- studio de manucure;

- studio de pédicure;

- studio de création d'ongles

Nom du service général

Pédicure;

- manucure;

- extension d'ongle.

Maintenant, nous allons au service Yandex et saisissons chaque demande, après avoir sélectionné la région dans laquelle nous allons nous déplacer.

Nous copions tous les mots dans Excel à partir de la colonne de gauche, ainsi que les phrases auxiliaires à droite.

Nous supprimons les mots inutiles qui ne correspondent pas au sujet. Les mots qui correspondent sont surlignés en rouge ci-dessous.

Le chiffre de 2320 demandes montre combien de fois les gens ont tapé cette demande non seulement dans sa forme pure, mais aussi dans le cadre d'autres phrases. Par exemple : manucure et prix à Moscou, prix manucure et pédicure à Moscou, etc.

Si vous entrez notre requête entre guillemets, il y aura déjà un autre chiffre, qui prend en compte les formes de mots de la phrase clé. par exemple : prix manucure, prix manucure, etc.

Si vous saisissez la même requête requête entre guillemets avec points d'exclamation, nous verrons combien de fois les utilisateurs ont tapé la requête "prix manucure".

Ensuite, nous décomposons la liste de mots résultante en pages du site. Ainsi, par exemple, nous laisserons les demandes à haute fréquence sur la page principale et sur les sections principales du site, telles que : manucure, studio de service d'ongles, extension d'ongles. Nous distribuerons les fréquences moyennes et basses fréquences sur le reste des pages, par exemple : prix manucure et pédicure, conception d'extension d'ongles en gel. Les mots doivent également être divisés en groupes selon leur sens.

- Page principale - studio, salon de manucure, etc.

- 3 sections - pédicure, manucure, prix pour manucure et pédicure.

- Pages - extension des ongles, pédicure matérielle, etc.

Quelles erreurs peuvent être commises lors de la compilation d'un

Lors de la compilation d'un noyau sémantique, personne n'est à l'abri d'erreurs. Les plus courants incluent les suivants :

- Il y a toujours le danger de choisir des requêtes inefficaces qui génèrent le nombre minimum de visiteurs.

- Lors de la re-promotion du site, vous ne devez pas modifier complètement le contenu publié sur le site. Sinon, tous les paramètres précédents seront remis à zéro, y compris le classement dans les résultats de recherche.

- Vous ne devez pas utiliser de requêtes incorrectes pour la langue russe, les robots de recherche définissent déjà bien ces requêtes et suppriment la page de la recherche lorsqu'ils « spamment » avec des mots-clés.

Nous vous souhaitons bonne chance dans la promotion de votre site !

Bonjour, chers lecteurs du site blog. Je veux faire un autre appel sur le thème de "récolter la semence". D'abord, comme prévu, puis beaucoup d'entraînement, peut-être un peu maladroit dans ma performance. Alors, les paroles. J'en ai eu assez de marcher les yeux bandés à la recherche de la bonne chance un an après avoir commencé ce blog. Oui, il y avait des "coups chanceux" (devinettes intuitives des requêtes fréquemment posées aux moteurs de recherche) et il y avait du trafic provenant des moteurs de recherche, mais je voulais atteindre la cible à chaque fois (au moins pour la voir).

Ensuite, j'ai voulu plus - automatiser le processus de collecte des demandes et de filtrage des «nuls». Pour cette raison, il y a eu une expérience avec Keycollector (et son jeune frère dissonant) et un autre article sur le sujet. Tout était génial et même tout simplement génial, jusqu'à ce que je réalise qu'il y a un point très important qui est resté essentiellement dans les coulisses - la dispersion des demandes d'articles.

La rédaction d'un article séparé pour une demande distincte est justifiée soit dans des sujets hautement compétitifs, soit dans des sujets très rentables. Pour les sites d'information, c'est complètement absurde et les requêtes doivent donc être combinées sur une seule page. Comment? Intuitivement, c'est-à-dire encore une fois à l'aveuglette. Mais toutes les demandes ne s'entendent pas sur une seule page et ont au moins une chance hypothétique d'atteindre le Top.

En fait, aujourd'hui, nous parlerons du regroupement automatique du noyau sémantique à l'aide de KeyAssort (divisant les requêtes en pages, et pour les nouveaux sites, construisant également une structure basée sur celles-ci, c'est-à-dire des sections, des catégories). Eh bien, nous allons encore une fois passer par le processus de collecte des demandes pour chaque pompier (y compris avec de nouveaux outils).

Laquelle des étapes de collecte du noyau sémantique est la plus importante ?

En soi, la collecte de requêtes (la base du noyau sémantique) pour un site futur ou déjà existant est un processus plutôt intéressant (comme n'importe qui, bien sûr) et peut être mis en œuvre de plusieurs manières, dont les résultats peuvent ensuite être combinés dans une grande liste (en nettoyant les doublons, en supprimant les sucettes par des mots vides).

Par exemple, vous pouvez commencer manuellement à tourmenter Wordstat, et en plus de cela, connecter le Keycollector (ou son dissonant version gratuite). Cependant, tout va bien lorsque vous êtes plus ou moins familiarisé avec le sujet et que vous connaissez les clés sur lesquelles vous pouvez compter (collecter leurs dérivés et requêtes similaires dans la colonne de droite de Wordstat).

Sinon (oui, et en tout cas ça ne fera pas de mal), vous pouvez commencer par les outils de « meulage grossier ». Par exemple, SerpstatComment(née Prodvigator), qui vous permet littéralement de "voler" vos concurrents pour les mots-clés qu'ils utilisent (voir). Il existe d'autres services similaires de "vol de concurrents" (mots espions, keys.so), mais je suis "bloqué" avec l'ancien Prodvigator.

Au final, il existe aussi un Bukvaris gratuit, qui permet de commencer à collecter les demandes très rapidement. Vous pouvez également commander un téléchargement privé depuis la monstrueuse base de données Ahrefs et récupérer à nouveau les clés de vos concurrents. En général, il vaut la peine de considérer tout ce qui peut apporter au moins une fraction de demandes utiles pour une promotion future, qui ne seront alors pas si difficiles à nettoyer et à combiner en une seule grande (souvent même une énorme liste).

Nous considérerons tout cela (en termes généraux, bien sûr) un peu plus bas, mais à la fin, la question principale se pose toujours - que faire ensuite. En fait, c'est effrayant même juste d'approcher ce que nous avons obtenu en conséquence (avoir volé une douzaine ou deux concurrents et gratté le fond du baril avec un Keycollector). La tête peut éclater d'essayer de casser toutes ces requêtes (mots clés) dans des pages distinctes d'un site futur ou existant.

Quelles requêtes coexisteront avec succès sur une page, et lesquelles ne devraient même pas être essayées de combiner ? Une question vraiment difficile, que j'ai précédemment résolue de manière purement intuitive, car l'analyse manuelle de l'émission de Yandex (ou Google) sur le sujet de "qu'en est-il des concurrents" est-elle manuellement médiocre, et les options d'automatisation ne sont pas apparues à portée de main. Eh bien, pour le moment. Néanmoins, un tel outil a "fait surface" et aujourd'hui il sera discuté dans la dernière partie de l'article.

Ceci n'est pas un service en ligne, mais solutions logicielles, dont la distribution peut être téléchargé sur la page principale du site officiel (version démo).

Par conséquent, il n'y a aucune restriction sur le nombre de demandes traitées - traitez autant que vous en avez besoin (il y a cependant des nuances dans la collecte des données). La version payante coûte moins de deux mille, ce qui, pour les tâches à résoudre, peut être dit pour rien (IMHO).

Mais on parlera du côté technique de KeyAssort un peu plus bas, mais là je voudrais parler de moi principe qui permet de décomposer une liste de mots-clés(pratiquement de n'importe quelle longueur) en grappes, c'est-à-dire un ensemble de mots-clés qui peuvent être utilisés avec succès sur une page du site (optimisez le texte, les titres et la masse de liens pour eux - appliquez la magie SEO).

D'où pouvez-vous obtenir des informations? Qui vous dira ce qui va "brûler" et ce qui ne fonctionnera pas de manière fiable ? Évidemment, le moteur de recherche lui-même sera le meilleur conseiller (dans notre cas, Yandex, en tant qu'entrepôt de requêtes commerciales). Il suffit de regarder grand volume sortie de données (disons, analysez le TOP 10) pour toutes ces requêtes (à partir de la liste collectée de la future graine) et comprenez ce que vos concurrents ont réussi à combiner avec succès sur une seule page. Si cette tendance se répète plusieurs fois, alors on peut parler d'un modèle, et sur la base de celui-ci, il est déjà possible de battre les clés en grappes.

KeyAssort vous permet de définir la "strictité" avec laquelle les clusters seront formés dans les paramètres (sélectionnez les clés pouvant être utilisées sur une page). Par exemple, pour le commerce, il est logique de resserrer les exigences de sélection, car il est important d'obtenir un résultat garanti, même si cela se fait au détriment de coûts légèrement plus élevés pour la rédaction de textes destinés à plus groupes. Pour les sites informatifs, au contraire, vous pouvez faire quelques concessions afin d'obtenir potentiellement plus de trafic avec moins d'effort (avec un risque légèrement plus élevé de « non-burnout »). Parlons de la façon de le faire à nouveau.

Mais que se passe-t-il si vous avez déjà un site avec un tas d'articles, mais que vous voulez développer une graine existante et optimiser les articles existants pour un plus grand nombre de mots-clés afin d'obtenir plus de trafic avec un minimum d'effort (décaler légèrement l'emphase des mots-clés) ? Ce programme donne également une réponse à cette question - vous pouvez effectuer les requêtes pour lesquelles les pages existantes sont déjà optimisées, faites des marqueurs, et autour d'elles, KeyAssort assemblera un cluster avec des requêtes supplémentaires qui sont promues avec succès (sur une page) par votre concurrents sur la question. C'est intéressant comment ça se passe...

Comment collecter un vivier de demandes sur le sujet dont vous avez besoin ?

Tout noyau sémantique commence, en fait, par la collecte d'un grand nombre de requêtes, dont la plupart seront rejetées. Mais l'essentiel est qu'au stade initial, ces «perles» y entrent, sous lesquelles des pages individuelles de votre site futur ou existant seront ensuite créées et promues. À ce stade, probablement, le plus important est de collecter autant de demandes plus ou moins appropriées que possible et de ne rien manquer, puis il est facile d'éliminer les vides.

Il y a une bonne question, quels outils utiliser? Il y a une réponse sans équivoque et très correcte - différente. Le plus gros le meilleur. Cependant, ces méthodes mêmes de collecte du noyau sémantique devraient probablement être répertoriées et faire l'objet d'évaluations générales et de recommandations pour leur utilisation.

- Yandex Wordstat et ses homologues dans d'autres moteurs de recherche - initialement, ces outils étaient destinés à ceux qui placent publicité contextuelle afin qu'ils puissent comprendre à quel point certaines expressions sont populaires auprès des utilisateurs des moteurs de recherche. Eh bien, il est clair que les référenceurs utilisent également ces outils et avec beaucoup de succès. Je peux recommander de jeter un œil à l'article, ainsi qu'à l'article mentionné au tout début de cette publication (il sera utile pour les débutants).

Parmi les lacunes de Vodstat, on peut noter :

- Une quantité monstrueuse de travail manuel (nécessite certainement une automatisation et nous en parlerons un peu plus tard), à la fois dans la perforation des phrases basées sur la clé et dans la perforation des requêtes associatives à partir de la colonne de droite.

- Limiter l'émission de Wordstat (2000 requêtes et pas une ligne de plus) peut poser problème, car pour certaines phrases (par exemple, "travail") c'est extrêmement faible et on perd de vue les basses fréquences, et parfois même les moyennes fréquences requêtes qui peuvent apporter un bon trafic et des revenus (beaucoup de gens les manquent). Vous devez "vous étirer beaucoup la tête", ou utiliser des méthodes alternatives (par exemple, des bases de données de mots clés, dont nous examinerons l'une ci-dessous - et c'est gratuit !).

- KayCollector(et son petit frère libre Slovoeb) - il y a quelques années, l'apparition de ce programme était simplement un "salut" pour de nombreux travailleurs du réseau (et même maintenant, il est plutôt difficile d'imaginer travailler sur une graine sans QC). Paroles de chanson. J'ai acheté KK il y a deux ou trois ans, mais je l'ai utilisé quelques mois tout au plus, car le programme est lié au matériel (bourrage informatique), et je le change plusieurs fois par an. En général, ayant une licence pour KK, j'utilise SE - c'est donc à cela que la paresse apporte.

Vous pouvez lire les détails dans l'article "". Les deux programmes vous aideront à collecter les requêtes des colonnes droite et gauche de Wordstat, ainsi que des suggestions de recherche pour les phrases clés dont vous avez besoin. Les indices sont ce qui tombe chaîne de recherche lorsque vous commencez à taper une requête. Souvent, les utilisateurs ne terminent pas l'ensemble en choisissant simplement l'option la plus appropriée dans cette liste. Les seoshniks ont compris cela et utilisent de telles requêtes dans l'optimisation et même.

QC et SE vous permettent de taper immédiatement un très grand nombre de demandes (bien que cela puisse prendre beaucoup de temps, ou d'acheter des limites XML, mais plus à ce sujet ci-dessous) et d'éliminer facilement les mannequins, par exemple, en vérifiant la fréquence des phrases dans guillemets (apprenez le matériel si vous ne comprenez pas que la parole - liens au début de la publication) ou en définissant une liste de mots vides (particulièrement pertinent pour le commerce). Après cela, l'ensemble du pool de requêtes peut être facilement exporté vers Excel pour la poursuite des travaux ou pour le chargement dans KeyAssort (clusterer), qui sera discuté ci-dessous.

- SerpStat(et autres services similaires) - vous permet d'entrer l'URL de votre site pour obtenir une liste de vos concurrents pour l'émission de Yandex et Google. Et pour chacun de ces concurrents il sera possible d'obtenir liste complète des mots-clés pour lesquels ils ont réussi à percer et à atteindre certains sommets (obtenir du trafic des moteurs de recherche). Le tableau croisé dynamique contiendra la fréquence de la phrase, la place du site dessus dans le Top et un tas d'autres informations utiles et pas très différentes.

Il n'y a pas si longtemps, j'ai utilisé presque le plan tarifaire Serpstat le plus cher (mais seulement pour un mois) et j'ai réussi à économiser près d'un gigaoctet de diverses choses utiles dans Excel pendant cette période. J'ai collecté non seulement les clés des concurrents, mais aussi des pools de requêtes pour les phrases clés qui m'intéressaient, et j'ai également collecté sept graines des pages les plus réussies de mes concurrents, ce qui, me semble-t-il, est également très important. Une chose est mauvaise - maintenant je ne trouve pas le temps de maîtriser le traitement de toutes ces informations inestimables. Mais il est possible que KeyAssort enlève tout de même l'engourdissement face au monstrueux colosse de données à traiter.

- boukvariks est une base de données gratuite de mots-clés dans son propre shell logiciel. La sélection des mots-clés prend une fraction de seconde (téléchargement vers Excel minutes). Je ne me souviens pas combien de millions de mots il y a, mais les critiques à ce sujet (y compris la mienne) sont tout simplement excellentes, et surtout, toute cette richesse est gratuite ! Certes, le package de distribution du programme pèse 28 gigaoctets et, une fois décompressé, la base de données occupe plus de 100 Go sur le disque dur, mais ce ne sont que des bagatelles par rapport à la simplicité et à la rapidité de collecte d'un pool de requêtes.

Mais non seulement la vitesse de collecte des graines est le principal avantage par rapport à Wordstat et KeyCollector. L'essentiel est qu'il n'y ait pas de restriction sur 2000 lignes pour chaque requête, ce qui veut dire qu'aucune basse fréquence et au-delà des basses fréquences ne nous échappera. Bien sûr, la fréquence peut être clarifiée une fois de plus par le même QC et filtrée à l'aide de mots vides, mais Bukvariks remplit remarquablement sa tâche principale. Certes, le tri par colonnes ne lui convient pas, mais en enregistrant le pool de requêtes dans Excel, il sera possible de le trier à sa guise.

Probablement, au moins quelques outils de cathédrale de demande de pool de demandes plus «sérieux» seront fournis par vous dans les commentaires, et je les emprunterai avec succès ...

Comment effacer les requêtes de recherche collectées de "dummy" et "garbage" ?

La liste obtenue à la suite des manipulations décrites ci-dessus est susceptible d'être très longue (voire énorme). Donc, avant de le charger dans le clusterer (pour nous ce sera KeyAssort) il est logique de le nettoyer un peu. Pour ce faire, le pool de requêtes, par exemple, peut être déchargé sur le collecteur de clés et supprimé :

- Demandes avec une fréquence trop faible (personnellement, je brise la fréquence entre guillemets, mais sans point d'exclamation). C'est à vous de décider quel seuil choisir, et à bien des égards, cela dépend du sujet, de la concurrence et du type de ressource vers laquelle la graine est destinée.

- Pour les requêtes commerciales, il est judicieux d'utiliser une liste de mots vides (comme « gratuit », « télécharger », « résumé », ainsi que, par exemple, les noms de villes, d'années, etc.) afin de supprimer à partir de la graine à l'avance, ce qui est connu n'amènera pas les acheteurs cibles sur le site (éliminer les cadeaux, recherche d'information, et non un produit, bien, et les habitants d'autres régions, par exemple).

- Parfois, il est logique de se laisser guider par l'indicateur de concurrence en matière de dépistage. cette demande en cause. Par exemple, à la demande de «fenêtres en plastique» ou de «climatiseurs», vous n'avez même pas besoin de faire basculer le bateau - l'échec est garanti à l'avance et avec une garantie à 100%.

Dites que c'est trop simple dans les mots, mais difficile dans la pratique. Et ici ce n'est pas le cas. Pourquoi? Mais parce qu'une personne que je respecte (Mikhail Shakin) n'a pas ménagé son temps et a enregistré une vidéo avec un détail une description de la façon de nettoyer les requêtes de recherche dans le collecteur de clés:

Merci à lui pour cela, car ces questions sont beaucoup plus faciles et plus claires à montrer qu'à décrire dans l'article. En général, vous pouvez le faire, car je crois en vous ...

Configuration du cluster de semences KeyAssort pour votre site

En fait, le plus intéressant commence. Maintenant, toute cette énorme liste de clés devra être en quelque sorte brisée (éparpillée) sur des pages distinctes de votre site futur ou existant (que vous souhaitez améliorer de manière significative en termes de trafic provenant des moteurs de recherche). Je ne vais pas me répéter et parler des principes et de la complexité de ce processus, car alors pourquoi ai-je écrit la première partie de cet article.

Notre méthode est donc assez simple. Nous allons sur le site officiel de KeyAssort et télécharger la version démo essayer le programme pour une dent (la différence entre la démo et la version complète est l'impossibilité de décharger, c'est-à-dire d'exporter les graines collectées), et après cela, il sera possible de payer (1900 roubles ne suffisent pas, pas assez selon les réalités modernes). Si vous souhaitez commencer immédiatement à travailler sur le noyau, appelé «pour une copie propre», il est préférable de choisir version complète avec possibilité d'exportation.

Le programme KeyAssort lui-même ne peut pas collecter les clés (ce n'est en fait pas sa prérogative), et elles devront donc y être chargées. Cela peut être fait de quatre manières - manuellement (il est probablement logique de recourir à cette méthode pour ajouter des clés déjà trouvées après la collection principale de clés), ainsi que trois méthodes par lots pour importer des clés:

- au format txt - lorsque vous avez juste besoin d'importer une liste de clés (chacune sur une ligne distincte du fichier txt et ).

- ainsi que deux variantes du format Excel : avec les paramètres dont vous aurez besoin dans le futur, ou avec les sites collectés du TOP10 pour chaque clé. Ce dernier peut accélérer le processus de clustering, car le programme KeyAssort n'a pas à analyser la sortie elle-même pour collecter ces données. Cependant, les URL du TOP10 doivent être fraîches et précises (une telle version de la liste peut être obtenue, par exemple, dans le Keycollector).

Oui, ce que je vous dis - il vaut mieux voir une fois:

Dans tous les cas, pensez d'abord à créer un nouveau projet dans le même menu "Fichier", et ce n'est qu'ensuite que la fonction d'importation deviendra disponible :

Passons en revue les paramètres du programme (heureusement il y en a très peu), car pour différents types sites, un ensemble différent de paramètres peut être optimal. Ouvrez l'onglet "Service" - "Paramètres du programme" et vous pouvez immédiatement aller à l'onglet « Regroupement »:

La chose la plus importante ici est peut-être choisir le type de clustering dont vous avez besoin. Le programme peut utiliser deux principes par lesquels les demandes sont combinées en groupes (clusters) - dur et doux.

- Difficile - toutes les demandes qui tombent dans un groupe (adaptées à la promotion sur une page) doivent être combinées sur une page pour le nombre requis de concurrents du Top (ce nombre est spécifié dans la ligne "force du groupe").

- Soft - toutes les demandes qui tombent dans le même groupe se produiront partiellement sur la même page pour le nombre requis de concurrents et le Top (ce nombre est également défini dans la ligne "force du groupement").

Manger bonne image illustrant clairement ceci :

Si ce n'est pas clair, tant pis, car ce n'est qu'une explication du principe, et ce qui nous importe n'est pas la théorie, mais la pratique, qui dit que :

- Le clustering dur est mieux utilisé pour les sites commerciaux. Cette méthode donne une grande précision, grâce à laquelle la probabilité d'atteindre le Top des requêtes combinées sur une page du site sera plus élevée (avec la bonne approche pour optimiser le texte et sa promotion), bien qu'il y ait moins de requêtes elles-mêmes dans le cluster, ce qui signifie qu'il y a plus de clusters eux-mêmes (plus de pages devront être créées et promues).

- Le regroupement souple est logique à utiliser pour les sites d'information, car les articles seront obtenus avec un indicateur de complétude élevé (ils pourront répondre à un certain nombre de demandes d'utilisateurs de sens similaire), ce qui est également pris en compte dans le classement. Et les pages elles-mêmes seront plus petites.

Un autre paramètre important, à mon avis, est une coche dans la case « Utilisez des phrases repères ». Pourquoi cela pourrait-il être nécessaire ? Jetons un coup d'œil.

Disons que vous avez déjà un site Web, mais que les pages qu'il contient ont été optimisées non pas pour un pool de requêtes, mais pour un seul, ou que vous considérez ce pool comme insuffisamment volumineux. Dans le même temps, vous souhaitez de tout cœur étendre la graine non seulement en ajoutant de nouvelles pages, mais également en améliorant celles qui existent déjà (c'est encore plus facile en termes de mise en œuvre). Il est donc nécessaire que chacune de ces pages obtienne la graine "au maximum".

C'est à cela que sert ce paramètre. Après l'avoir activé, il sera possible de cocher chaque phrase de votre liste de requêtes. Il vous suffit de trouver les requêtes principales pour lesquelles vous avez déjà optimisé les pages existantes de votre site (une par page) et le programme KeyAssort va construire des clusters autour d'elles. En fait, tout. Plus dans cette vidéo :

Un autre élément important (pour bon fonctionnement programmes) mettant des vies sur l'onglet "Collecte de données à partir de Yandex XML". vous pouvez lire dans l'article ci-dessous. En bref, les référenceurs analysent constamment les résultats Yandex et Wordstat, créant une charge excessive sur sa capacité. Pour la protection, le captcha a été introduit et un accès spécial a été développé via XML, où le captcha ne sortira plus et les données ne seront pas déformées par les clés vérifiées. Certes, le nombre de ces contrôles par jour sera strictement limité.

Qu'est-ce qui détermine le nombre de limites allouées ? Comment Yandex évalue votre . Vous pouvez suivre ce lien (en étant dans le même navigateur où vous êtes autorisé dans Ya.Webmaster). Par exemple, ça ressemble à ça pour moi :

Il y a aussi un graphique de la distribution des limites par heure de la journée ci-dessous, ce qui est également important. Si vous devez gérer un grand nombre de demandes et qu'il y a peu de limites, ce n'est pas un problème. Ils peuvent être achetés. Pas Yandex, bien sûr, directement, mais ceux qui ont ces limites, mais ils n'en ont pas besoin.

Le mécanisme Yandex XML permet le transfert de limites, et les bourses devenues intermédiaires aident à automatiser tout cela. Par exemple, sur Proxy XML vous pouvez acheter des limites pour seulement 5 roubles pour 1000 requêtes, ce qui, voyez-vous, n'est pas cher du tout.

Mais cela n'a pas d'importance, car les limites que vous avez achetées seront toujours transférées sur votre "compte", mais pour les utiliser dans KeyAssort, vous devrez vous rendre sur le " Paramètre" et copiez le lien long dans le champ "URL des requêtes" (n'oubliez pas de cliquer sur "Votre IP actuelle" et cliquez sur le bouton "Enregistrer" pour lier la clé à votre ordinateur) :

Après cela, il ne reste plus qu'à insérer cette URL dans la fenêtre avec les paramètres KeyAssort dans le champ "Url pour les requêtes" :

En fait, tout est terminé avec les paramètres KeyAssort - vous pouvez commencer à regrouper le noyau sémantique.

Regroupement de mots-clés dans KeyAssort

Donc, j'espère que vous avez tout configuré (sélectionné le type de clustering souhaité, connecté vos propres limites ou acheté des limites de Yandex XML), compris comment importer une liste avec des requêtes et transféré avec succès le tout vers KeyAssort. Et après? Et puis, bien sûr, le plus intéressant est le lancement de la collecte de données (Urls des sites du Top 10 pour chaque requête) et le regroupement ultérieur de toute la liste en fonction de ces données et des paramètres que vous avez définis.

Alors, pour commencer, cliquez sur le bouton "Collecter des données" et attendez de plusieurs minutes à plusieurs heures pendant que le programme scanne les Tops pour toutes les requêtes de la liste (plus il y en a, plus l'attente est longue) :

Il m'a fallu environ une minute pour faire trois cents requêtes (c'est un petit noyau pour une série d'articles sur le travail sur Internet). Après quoi vous pouvez déjà procéder directement au regroupement, le bouton du même nom de la barre d'outils KeyAssort devient disponible. Ce processus est très rapide, et littéralement en quelques secondes, j'ai obtenu tout un ensemble de calsters (groupes), conçus comme des listes imbriquées :

En savoir plus sur l'utilisation de l'interface du programme, ainsi que sur création de clusters pour les pages de site existantes regardez mieux dans la vidéo, car c'est beaucoup plus clair:

Tout ce que nous voulions, nous l'avons eu, et attention, en mode entièrement automatique. Lepota.

Bien que, si vous créez un nouveau site, en plus du clustering, il est très important esquisser la future structure du site(définir les sections/catégories et répartir les clusters entre elles pour les futures pages). Curieusement, mais c'est assez pratique de le faire dans KeyAssort, mais la vérité n'est plus dans mode automatique, et en mode manuel. Comment?

Encore une fois, il sera plus facile de voir à nouveau - tout est mis en place littéralement sous nos yeux en faisant simplement glisser les clusters de la fenêtre de gauche du programme vers celle de droite :

Si vous avez acheté le programme, vous pouvez exporter le noyau sémantique résultant (et en fait la structure du futur site) vers Excel. De plus, sur le premier onglet, il sera possible de travailler avec des demandes sous la forme d'une seule liste, et sur le deuxième onglet, la structure que vous avez configurée dans KeyAssort sera déjà enregistrée. Très, très pratique.

Bien, peu importe. Je suis prêt à discuter et à entendre votre avis sur la collecte de semis pour le site.

Bonne chance à toi! A bientôt sur le site des pages du blog

Vous pourriez être intéressé

vpodskazke- nouveau service Dans une info-bulle pour faire avancer les conseils dans moteurs de recherche

Classement SE- meilleur service suivi de position pour débutants et professionnels en SEO Collection d'un noyau sémantique complet dans Topvisor, une variété de façons de sélectionner des mots-clés et de les regrouper par page La pratique consistant à collecter un noyau sémantique pour le référencement auprès d'un professionnel - comment cela se passe dans les réalités actuelles de 2018 Optimisation facteurs comportementaux sans leur torsion SEO PowerSuite - programmes d'optimisation de sites Web internes (WebSite Auditor, Rank Tracker) et externes (SEO SpyGlass, LinkAssistant)  SERPClick : promotion par facteurs comportementaux

SERPClick : promotion par facteurs comportementaux

sushiandbox.ru Mastering PC - Internet. Skype. Réseaux sociaux. Cours sur Windows.

sushiandbox.ru Mastering PC - Internet. Skype. Réseaux sociaux. Cours sur Windows.